Êtes-vous un Oncrawler chevronné qui pense connaître la plateforme comme le fond de sa poche ?Ou vous venez de devenir utilisateur et vous recherchez les meilleurs conseils pour vous aider à démarrer ?

En tant que membre de l’équipe CSM d’Oncrawl, j’ai une vision particulière des fonctionnalités qui, selon moi, sont sous-utilisées mais qui offrent une valeur ajoutée considérable.

Quelle que soit votre situation, voici un résumé de mes 5 fonctionnalités Oncrawl les plus sous-estimées que vous avez peut-être négligées ou que vous ne connaissez tout simplement pas encore !

Champs personnalisés (scraping de données)

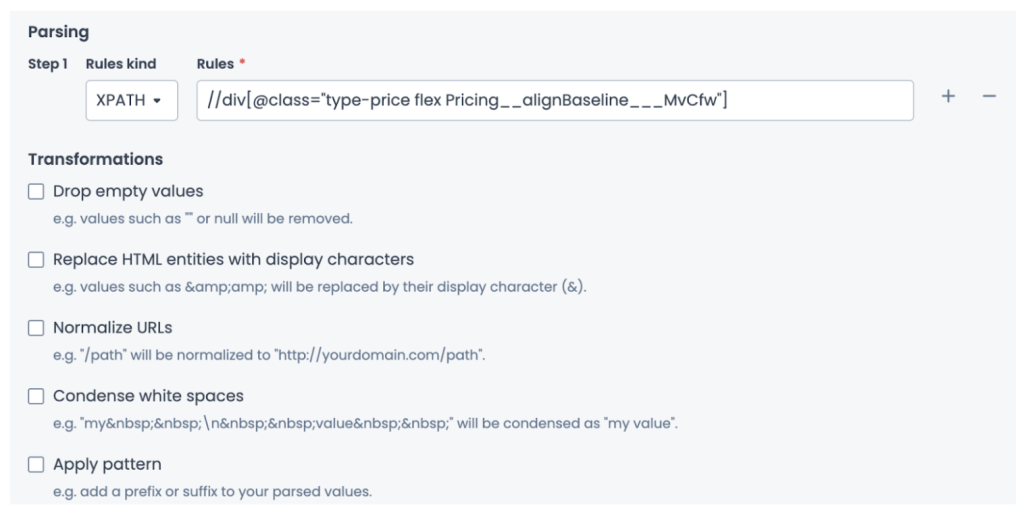

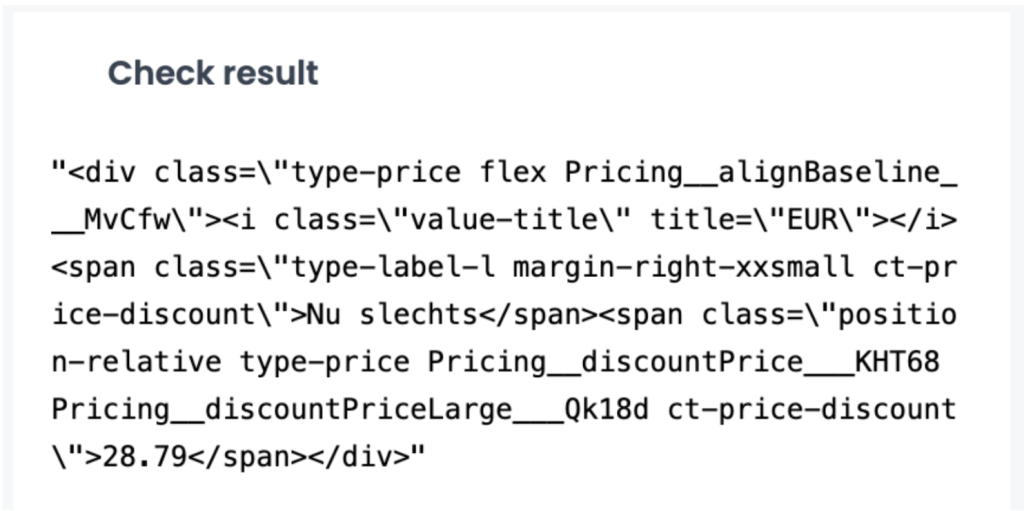

Une brève introduction aux champs personnalisés chez Oncrawl : nous proposons deux méthodes de scraping, XPath et Regex. Avant d’aller plus loin, si vous souhaitez en savoir plus sur le scraping, qui consiste à extraire des données de sites web, consultez notre ressource sur le scraping, qui présente ses fonctions utiles à l’aide d’exemples pertinents.

La fonctionnalité des champs personnalisés n’est pas nécessairement révolutionnaire, mais ce qui est extrêmement utile, c’est la possibilité de combiner Regex et XPath plutôt que de se limiter à une seule méthode.

Pour simplifier, Regex et XPath sont des méthodes permettant de trouver des éléments spécifiques dans une grande quantité de données. Plutôt que d’effectuer des recherches individuelles pour trouver du texte, vous pouvez effectuer une recherche basée sur un modèle.

Supposons que vous souhaitez identifier le mois dans ce texte, « 5 août », plutôt que de rechercher « août » avec Regex, vous pouvez utiliser \w+ pour sélectionner le caractère alphabétique, tandis que XPath vous permet d’afficher les éléments textuels d’un document XML ou HTML.

Ou supposons que vous souhaitiez afficher le contenu d’un élément div. Vous commencerez par //div[@class et terminerez par le nom de la classe. Dans certains cas, vous souhaitez simplement afficher le contenu, dans d’autres, vous souhaitez identifier un schéma spécifique, mais parfois, vous avez besoin d’une combinaison des deux.

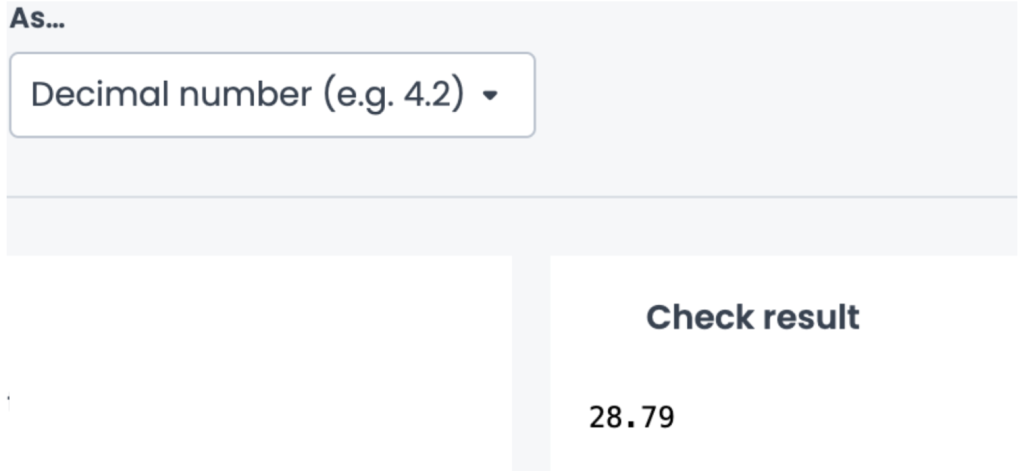

Prenons un exemple concret pour illustrer cela. Imaginez que vous devez extraire le prix de tous les articles d’un site. Dans ma première règle, j’utilise XPath et vous pouvez voir que j’extrais les données brutes pour vérifier que je récupère bien l’élément de prix.

J’ajouterai une deuxième règle pour épurer l’exportation afin de me concentrer uniquement sur la valeur du prix, puis j’utiliserai Regex comme troisième règle pour ne capturer que les éléments et les valeurs non numériques dans ce cas, le prix : (\d+\D+\d+).

La flexibilité permettant d’utiliser les deux méthodes rend l’ajout de règles de scraping plus efficace et vous offre davantage d’options pour scraper et combiner les données afin d’obtenir davantage d’informations en fonction de votre secteur d’activité.

J’utilise le prix dans cet exemple, mais vous pouvez envisager de scraper la date de publication et de modification des articles, la disponibilité des articles sur les pages PDP ou le fil d’Ariane afin de mieux visualiser vos pages crawlées avec des segmentations.

Filtres instantanés avec un raccourci clavier

L’une des fonctionnalités les plus petites mais les plus puissantes de la plateforme en termes de gain de temps est le filtre instantané, accessible via un simple raccourci clavier.

Que vous soyez plongé dans un rapport de crawl ou que vous parcouriez simplement un crawl hebdomadaire, le filtre instantané vous aide à concentrer votre analyse sur ce qui a attiré votre attention.

Imaginez que vous examinez un rapport de crawl et que vous remarquez un pic de pages non indexables dû à une balise méta robots. Vous souhaitez approfondir votre analyse et voir comment cela se reflète dans les autres graphiques.

Au lieu d’appliquer manuellement des filtres dans le data explorer, il vous suffit de maintenir la touche Option (Mac) ou Alt (Windows) enfoncée et de cliquer sur le segment que vous souhaitez mettre en évidence. Instantanément, tous les graphiques du tableau de bord sont mis à jour pour refléter ce filtre précis.

Pourquoi est-ce utile ?

- Des informations plus rapides : explorez les tendances sur plusieurs graphiques sans quitter le rapport.

- Suivi ciblé : mettez en évidence des problèmes tels que l’indexabilité, les performances ou la fréquence de crawl d’un simple clic.

- Filtrage cohérent : pas besoin de créer manuellement le filtre, vous ne manquez rien.

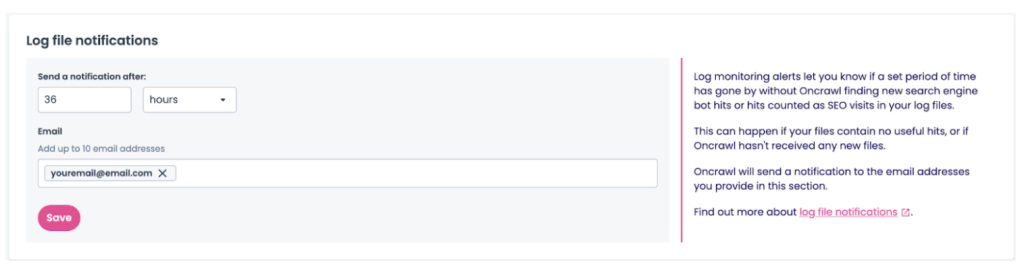

Alertes / notifications des logs

Facilement négligée mais cruciale pour le monitoring de vos fichiers de logs, l’activation des alertes de logs vous permet d’ajouter jusqu’à 10 adresses email qui seront notifiées si aucun fichier de logs récent ou utilisable n’est déposé dans votre projet.

Tomber sur un problème avec vos fichiers de logs peut être une découverte désagréable et entraîner un long délai avant qu’il ne soit résolu. Avec les notifications de fichiers de logs, configurez-les et n’y pensez plus.

Définissez le délai après lequel vous souhaitez être averti lorsqu’un problème survient et vous recevrez un e-mail s’il n’y a pas eu de dépôts récents ou si ce qui a été déposé n’est pas considéré comme utile.

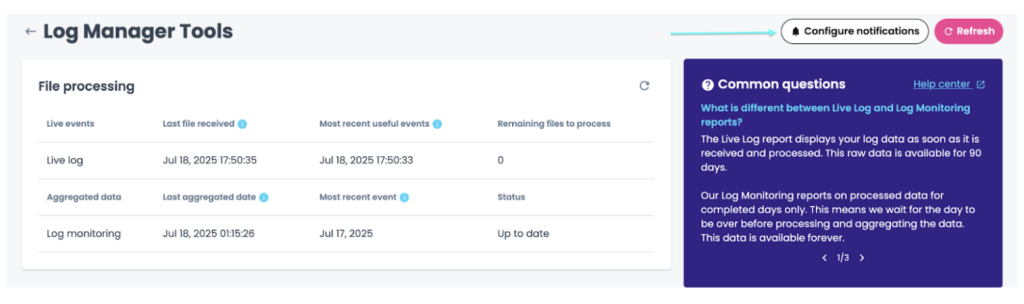

Pour le configurer, rendez-vous dans votre projet sur lequel la fonctionnalité de monitoring des logs est activée et cliquez sur les Log Manager Tools. À partir de là, cliquez sur Configure notifications.

À ce stade, vous pourrez activer les notifications et définir un seuil à partir duquel vous serez contacté si vos logs nécessitent votre attention.

Cela peut vous faire gagner du temps pour découvrir exactement ce qui ne va pas avec certains dépôts, ce qui vous permet d’obtenir plus rapidement des rapports de log à jour.

Log manager tools

Puisque nous parlons de logs, il semble approprié de mentionner que le rapport du Log Manager Tools est une autre zone importante de la plate-forme qui n’est pas toujours utilisée aussi souvent qu’elle le pourrait. Il s’agit d’un petit hub bien caché au niveau du projet, qui contient les détails sur ce qui est exactement déposé, en ce qui concerne les fichiers de logs.

En y accédant, vous verrez non seulement les fichiers exacts qui ont été déposés, mais aussi la date et l’heure exactes de chaque dépôt, la répartition de chaque type de ligne de log (OK, filtré, erroné), un graphique qui surveille le nombre de faux hits de robots détectés par date de dépôt, et vous pouvez voir une ventilation de la qualité des logs déposés et la distribution des lignes utiles.

C’est un endroit idéal pour vérifier la qualité des dépôts de fichiers, par exemple en s’assurant que les fichiers sont compressés, que vous déposez réellement des lignes liées au SEO, comme les visites organiques et les hits de robots, et en vérifiant la fréquence des dépôts.

Si vous commencez à remarquer quelque chose d’étrange dans vos rapports de logs, vous pouvez commencer votre enquête dans le Log Manager Tools.

Vous découvrirez peut-être que le format de la ligne de log a changé et que notre équipe de Customer Success doit mettre à jour le parseur, ou vous remarquerez peut-être que le nom du bucket a changé et que vous devez nous envoyer de nouvelles informations d’identification.

Dans tous les cas, vous pouvez toujours jeter un coup d’œil et nous contacter si vous avez besoin d’aide pour approfondir la question.

Segmentations personnalisées avec le filtre OQL

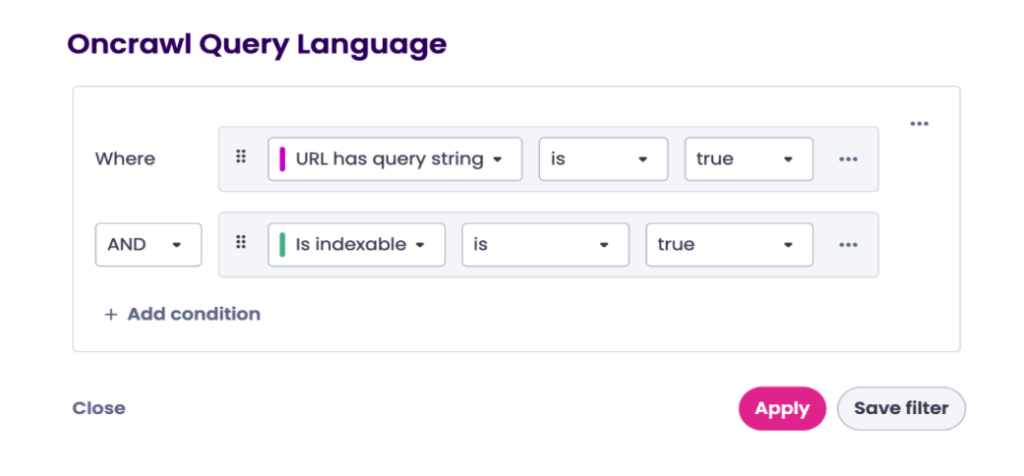

À côté du menu déroulant de segmentation se trouve le filtre OQL, très pratique, qui mérite d’être mis en avant. Lorsqu’il est utilisé, il facilite considérablement la vérification de vos rapports de crawl. Le filtre OQL, qui fait référence au langage de requête Oncrawl, est un moyen simple de filtrer vos données Oncrawl.

Par exemple, si vous essayez de trouver tous les liens pointant vers des pages 404, vous pouvez utiliser ce filtre OQL dans Oncrawl.

C’est ainsi que vous découvrirez tous les trésors cachés en explorant en profondeur vos données de crawl. Bien que vous puissiez utiliser directement l’OQL dans le data explorer, vous avez en fait la possibilité de l’utiliser et de l’appliquer directement à tous les tableaux de bord de votre projet.

Tout comme la segmentation vous permet de regrouper les pages crawlé

Voyons un cas pratique pour comprendre son utilité. Si vous consultez un rapport de crawl récent et que vous souhaitez vérifier uniquement les pages qui sont paramétrées mais indexables, vous devez d’abord cliquer sur Filter.

Sélectionnez ensuite le filtre OQL pour afficher les URLs qui contiennent une chaîne de requête et qui sont considérées comme indexables.

Vous obtiendrez ainsi le nombre de pages considérées comme des chaînes de requête également indexables, ce qui vous permettra de vérifier si la stratégie de gestion est appropriée ou si des ajustements sont nécessaires.

L’application directe des filtres OQL aux tableaux de bord vous offre les avantages suivants :

- Résolution plus rapide des problèmes, grâce à la réduction du nombre d’URL spécifiques.

- Analyse plus ciblée, grâce au filtrage des URLs susceptibles de créer du bruit.

- Option de personnalisation lors de la consultation des tableaux de bord.

Que vous ayez une vision d’ensemble ou que vous vous intéressiez aux détails, ces fonctionnalités sous-estimées pourraient bien devenir vos nouvelles favorites.