Êtes-vous un Oncrawler chevronné qui pense connaître la plateforme comme le fond de sa poche ? Ou cherchez-vous des conseils d’initiés pour vous lancer ? En tant que membre de l’équipe CSM d’Oncrawl, j’ai une vision assez précise sur les fonctionnalités de la plateforme qui, à mon avis, sont moins souvent utilisées. Quelle que soit votre situation, voici un tour d’horizon de mes 5 fonctionnalités d’Oncrawl les plus sous-estimées, que vous avez peut-être négligées ou que vous ne connaissez tout simplement pas encore !

Champs personnalisés (scraping de données)

Un bref rappel concernant les champs personnalisés à Oncrawl, nous offrons deux méthodes pour le scraping, XPath et Regex. Avant d’aller plus loin, si vous avez besoin d’un regard plus approfondi sur le scraping web, l’extraction de données à partir de sites web, consultez cet article qui passe en revue ses fonctions utiles.

Les fonctions de champs personnalisés ne sont pas nécessairement révolutionnaires, mais ce qui est incroyablement pratique, c’est la possibilité d’utiliser un mélange de Regex et de XPath plutôt que d’être limité à une seule méthode. Pour le dire simplement, Regex et Xpath sont des méthodes pour trouver des choses. Plutôt que d’effectuer des recherches individuelles de texte, vous pouvez effectuer une recherche basée sur un modèle. Disons que vous voulez identifier le mois dans ce texte, « 21 septembre », plutôt que de chercher « septembre », avec Regex vous pouvez utiliser \w+ pour récupérer le caractère du mot. Tandis que Xpath vous permet d’afficher les éléments de texte d’un document XML ou HTML. Dans ce cas, disons que vous voulez afficher le contenu de l’élément div, vous commencerez par //div[@class et ainsi de suite. Dans certains cas, vous souhaitez simplement afficher le contenu, dans d’autres, vous voulez identifier un motif spécifique, mais parfois vous avez besoin d’un mélange des deux.

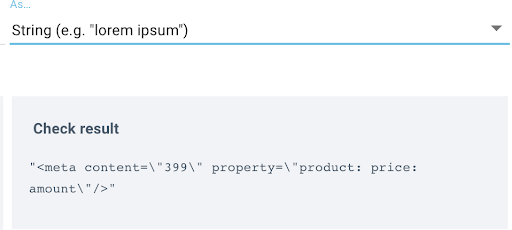

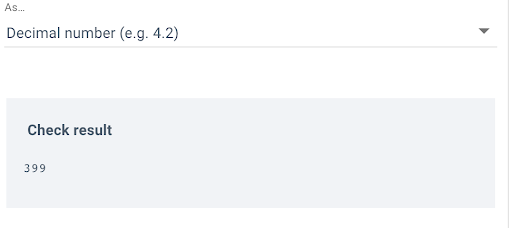

Par exemple, disons que je veux scraper le prix de tous les produits d’un site. Dans ma première règle, j’utilise XPath et vous pouvez voir que je tire les données brutes pour vérifier que je récupère l’élément de prix :

Ensuite, j’utilise Regex pour ma deuxième règle afin de ne récupérer que tout élément jusqu’au guillemet, dans ce cas, le prix : content= »([^\ »]+) :

Cela rend la création de règles de scraping un peu plus rapide et plus facile. Et si vous n’êtes pas encore à l’aise avec l’une ou l’autre de ces méthodes, vous trouverez ici un article contenant quelques conseils.

Filtres personnalisés dans le Data Explorer

Vous arrive-t-il de vous retrouver dans le Data Explorer en essayant de vous souvenir des filtres que vous avez utilisés avec le langage de requête Oncrawl ? Ou peut-être que chaque fois que vous êtes là, vous utilisez manuellement l’OQL pour filtrer les pages crawlées et ajouter chaque colonne pertinente une par une. Vous pourriez gagner un temps précieux en utilisant la fonction de filtres personnalisés, qui se trouve à droite des options DataSet :

Vous avez l’option Quickfilters qui est composée de requêtes courantes, et chaque filtre personnalisé que vous enregistrez sera ajouté dans la section « Own filters » où vous pouvez facilement retrouver les pages que vous recherchez. Cette opération peut être effectuée pour tous les ensembles de données disponibles. Par défaut, vous disposez de Pages et de Liens, mais si votre abonnement a activé la surveillance des journaux, vous verrez apparaître l’option de surveillance des logs : Pages, et Surveillance des logs : Événements.

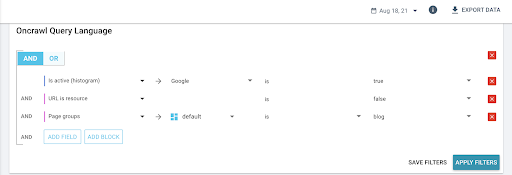

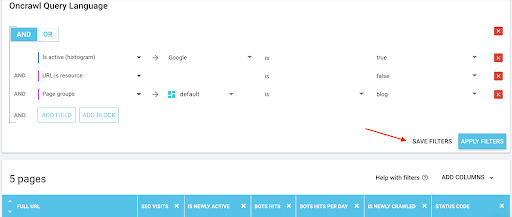

Tout ce que vous avez à faire est d’utiliser l’OQL pour filtrer les pages, ici nous regardons les pages actives SEO pour le 18 août, spécifiquement pour le groupe de pages Blog :

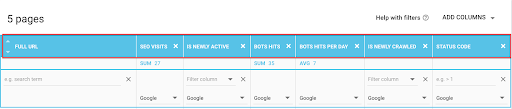

Et ensuite vous pouvez utiliser le menu déroulant (« ADD COLUMNS ») pour ajouter les métriques pertinentes à votre recherche :

Ensuite, cliquez sur « SAVE FILTERS » pour enregistrer votre filtre personnalisé et il sera disponible sous « Own filters ».

Alerte/notifications de logs

Un ajout récent à nos mises à jour de fonctionnalités pour 2021 qui peut être négligé est l’option d’activer les alertes de logs – C’est un excellent moyen d’être au courant de tout problème de traitement de vos logs. Ainsi, plutôt que d’attendre de découvrir un problème avec les dépôts lorsque vous vous connectez à la plate-forme, activez l’alerte de logs pour vous informer lorsque des logs n’ont pas été déposés récemment, ou si ce qui est déposé n’est pas considéré comme utile.

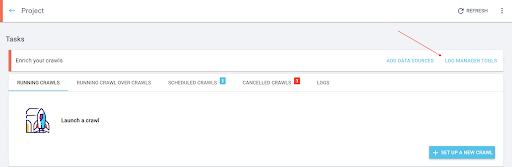

L’utilisation est assez simple, il suffit de se rendre dans votre projet dont le suivi des logs est activé et de cliquer sur l’onglet « Log Manager Tools » :

Une fois que vous êtes dans le rapport Log Manager Tools, vous cliquez sur « Configure Notifications » :

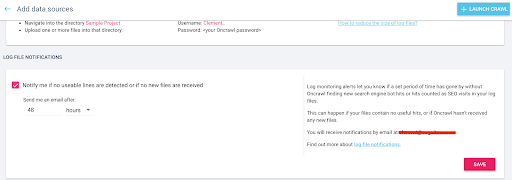

A partir de là, vous pourrez activer les notifications et définir un seuil à partir duquel vous serez contacté si aucune ligne utile ou aucun nouveau fichier n’a été déposé.

Cela peut vous faire gagner du temps pour découvrir ce qui ne va pas dans certains dépôts, ce qui vous permet de disposer plus rapidement de rapports à jour.

[Ebook] Analyse de logs : 4 cas d’usage

Log Manager Tools

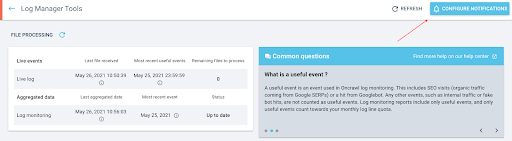

Puisque nous parlons de logs, il semble approprié de mentionner que le rapport du Log Manager Tools est une autre zone importante de la plate-forme qui n’est pas toujours utilisée aussi souvent qu’elle le pourrait. Il s’agit d’un petit hub bien caché au niveau du projet, qui contient les détails sur ce qui est exactement déposé, en ce qui concerne les fichiers de logs.

En y accédant, vous verrez non seulement les fichiers exacts qui ont été déposés, mais aussi la date et l’heure exactes de chaque dépôt, la ventilation de chaque type de ligne de log (OK, filtré, erroné), un graphique qui surveille le nombre de faux hits de robots détectés par date de dépôt, et vous pouvez voir une ventilation de la qualité des logs déposés et la distribution des lignes utiles.

C’est un endroit idéal pour vérifier la qualité des dépôts de fichiers, par exemple en s’assurant que les fichiers sont compressés, que vous déposez réellement des lignes liées au SEO, comme les visites organiques et les hits de robots, et en vérifiant la fréquence des dépôts.

Si vous commencez à remarquer quelque chose d’étrange dans vos rapports de logs, vous pouvez commencer votre enquête dans le Log Manager Tools. Vous découvrirez peut-être que le format de la ligne de log a changé et que notre équipe de Customer Success doit mettre à jour le parseur, ou vous remarquerez peut-être que le nom du bucket a changé et que vous devez nous envoyer de nouvelles informations d’identification. Dans tous les cas, vous pouvez toujours jeter un coup d’œil et nous contacter si vous avez besoin d’aide pour approfondir la question.

Segmentations personnalisées

Enfin, le dernier ajout en date à notre arsenal, les segmentations personnalisées ! Nous disposons désormais d’une collection de modèles de segmentation pour inspirer les nouveaux utilisateurs d’Oncrawl qui n’ont jamais travaillé sur une segmentation, ou pour faciliter l’élaboration d’une segmentation.

Les segmentations sont essentielles au développement car vous voulez savoir quelle partie du site vous regardez lorsque vous examinez les résultats du crawl. Elles peuvent être aussi simples que le regroupement des pages par le premier chemin dans l’URL, ou aussi spécifiques que le regroupement des pages par une série de sessions GA.

En plus des modèles qui vous donnent maintenant quelques indications sur la raison pour laquelle vous devriez les utiliser, vous aurez également plusieurs modèles disponibles en fonction des connecteurs de données externes que vous avez configurés pour le projet.

Ainsi, si vous disposez de données de logs, vous aurez une suggestion de modèle pour les visites SEO ou les visites de robots, et si vous avez connecté Google Search Console, vous verrez l’option de créer une segmentation basée sur les positions ou ranking pages.

C’est à vous de décider comment vous voulez voir le site, nous sommes là pour vous faciliter la tâche. Alors allez-y, essayez et dites-nous ce que vous en pensez.