Des données complètes et exploitables pour Analytics et le trafic des robots

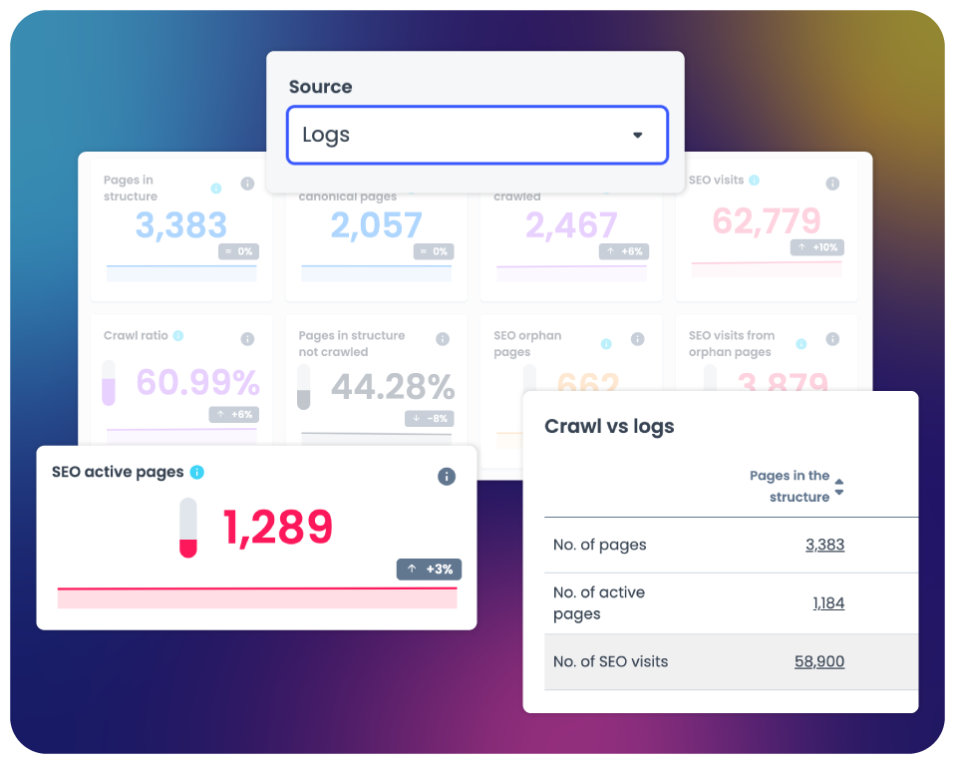

Les informations des logs sont essentielles pour monitorer la santé du site, l’intérêt et l’attention des moteurs de recherche, ainsi que le volume des visites organiques.

Des informations impartiales sur les visites de votre site

Identifiez avec précision qui et quoi a visité votre site

Les solutions d’Analytics anonymisent, échantillonnent et masquent souvent les données de trafic, ce qui peut compromettre la possibilité de visualiser le trafic sur votre site. L’analyse des logs pour le SEO technique offre une solution plus complète.

- Traitez les analyses de manière conforme à la législation sur la protection de la vie privée.

- Aucune donnée cachée ou « non signalée », comme c’est souvent le cas avec les solutions d’analyse.

- Visualisez les connexions entre la performance du site, les métriques SEO et le trafic.

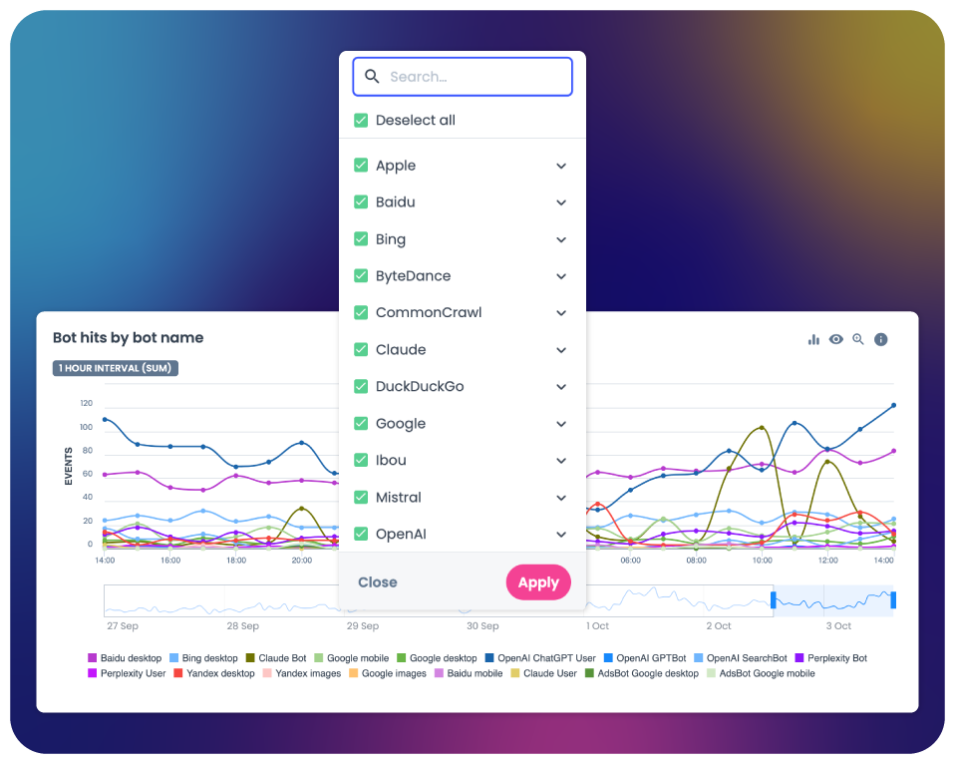

Observez les robots des moteurs de recherche

Les moteurs de recherche utilisent des robots pour découvrir et collecter des informations sur les sites et les pages qu’ils ont l’intention d’indexer. Observez-les pour comprendre si vos pages répondent aux besoins des moteurs de recherche.

- Comprenez le comportement des robots des moteurs de recherche en analysant les tendances et la fréquence des crawls.

- Déterminez les indicateurs qui influencent le comportement des robots.

- Anticipez le temps nécessaire à l’indexation des nouvelles pages.

- Découvrez les corrélations entre les indicateurs SEO et l’attention portée par les moteurs de recherche.

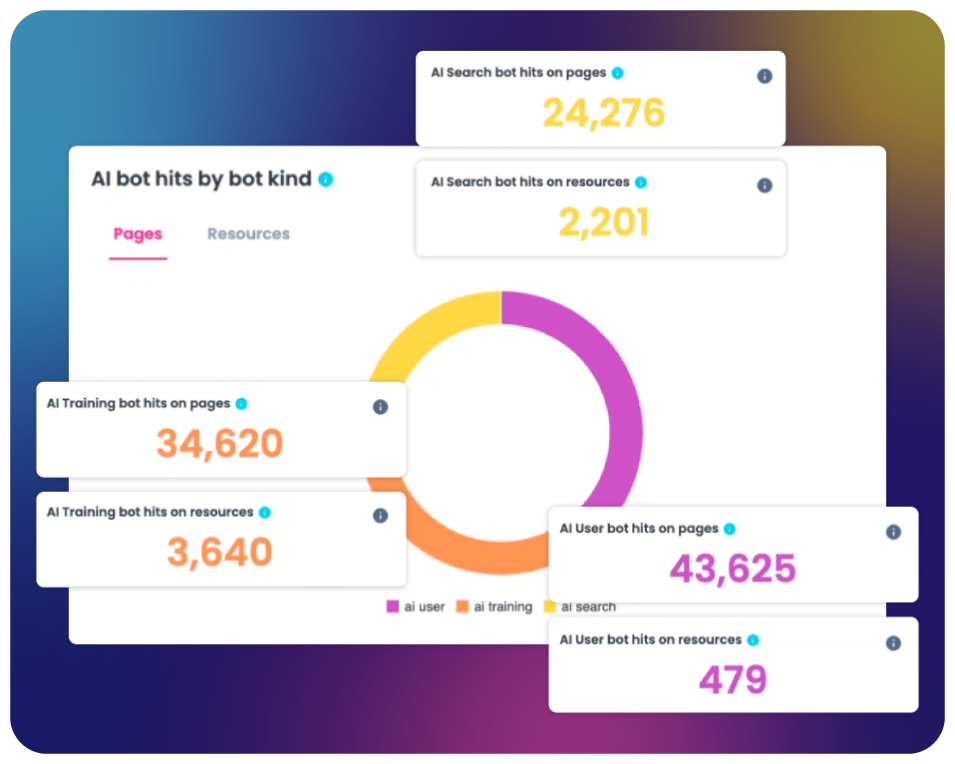

Surveillez les robots de l'IA

Le SEO va désormais bien au-delà de Google. Votre contenu est aussi exploré, interprété et réutilisé par les systèmes d’IA. Avec Oncrawl, suivez les bots IA qui soutiennent les LLMs tels que OpenAI, Gemini ou Perplexity, et ouvrez la boîte noire de la recherche IA :

- Explorez le tableau de bord dédié aux bots IA pour mieux comprendre comment les bots IA interagissent avec votre site web.

- Suivez les bots utilisateurs IA pour mesurer votre visibilité dans les LLMs.

- Analysez et identifiez le contenu le plus visible utilisé dans les LLMs.

- Préparez votre contenu pour les systèmes IA et le Search moderne.

Assurez la santé SEO de votre site

Repérez les problèmes techniques avant qu’ils n’affectent votre positionnement.

- Vérifiez le délai de découverte entre la publication, l’exploration et les premières visites organiques.

- Repérez les contenus problématiques et autres obstacles techniques.

- Obtenez une confirmation instantanée que les migrations sont correctement pris en compte par les moteurs de recherche.

- Surveillez les problèmes critiques qui ont un impact sur la visibilité.