Récemment, nous avons sorti notre nouvelle fonctionnalité crawl over crawl. Cette dernière vous permet de comparer 2 crawls différents tout en indiquant les évolutions du crawl ainsi que vos améliorations SEO.

Nous pensons sincèrement que cet outil est indispensable pour tout expert SEO, car il permet de faciliter et d’alléger la charge de travail, et ce, au quotidien.

Vous pouvez séparer l’analyse par expertise métier et ainsi suivre automatiquement l’évolution de votre site – crawl après crawl, vérifier les améliorations suivant l’audit SEO ou tout simplement détecter rapidement des problèmes en comparant 2 crawls.

Dans cet article, on vous donne 10 cas pratiques pour améliorer votre SEO grâce au Crawl over Crawl.

10 cas pratiques utilisant le Crawl over Crawl

Si vous n’avez pas encore lu notre guide sur comment lire un sunburst, il n’est pas trop tard !

#1 Vérifiez les évolutions en terme d’indexation

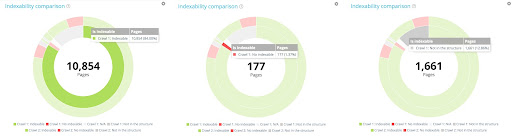

Le Crawl over Crawl vous permet de comparer l’indexabilité entre 2 crawls :

Dans cet exemple, le 1er crawl contient 10 854 pages indexables et 177 pages non indexables. 1 661 pages ont seulement été trouvé dans le second crawl.

Regardons maintenant le cercle externe. Pour chaque segment du premier cercle, nous avons la distribution de ces pages dans le second crawl.

Au sein des 10 854 pages indexables du premier crawl, seulement 10 104 le sont toujours dans le second, 560 sont maintenant non indexables dans le second crawl et 190 n’existent plus dans le crawl 2.

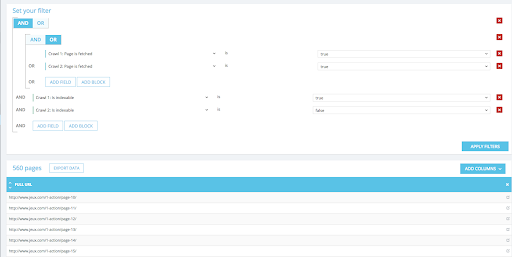

Cela permet de détecter facilement les mouvements d’indexabilité entre les 2 crawls. Vous attendiez-vous à ce résultat ? Si ce n’est pas le cas, vous avez désormais les bonnes données en main pour prendre une décision. Vous pouvez également cliquer sur n’importe quelle partie du graphique pour identifier les URLs concernés et les exporter en csv pour mieux visualiser le tout :

#2 Obtenez un aperçu clair des mouvements de profondeur

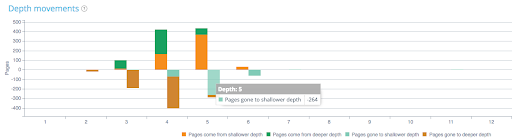

Vous pouvez analyser comment la profondeur de votre page a évolué entre deux crawls. Vous pouvez observer les mouvements de profondeur dans le graphique ci-dessous :

Par exemple, si on regarde la profondeur 5, on peut voir des pages qui sont parties vers un niveau de profondeur supérieur ou inférieur qui proviennent de niveau moins ou plus profond entre le crawl 1 et 2. Ici, les 264 pages qui étaient dans le crawl 1 avec un niveau de profondeur 5 se sont déplacées à un niveau moins profond (4,3,2).

Si vous optimisez vos liens internes, gardez ces données en tête pour bien analyser le mouvement de vos pages.

#3 Détectez vos pages manquantes entre 2 crawls

La comparaison de vos crawls peut vous aider à identifier les pages orphelines. Disons que vous avez un site web contenant 500 pages. En regardant le Search Console, on peut voir que Google a indexé 390 pages. Si j’efface 250 pages après mon premier crawl, je ne peux pas savoir si c’est 250 pages faisaient partie des 390 pages reconnues par Google.

Dans le crawl 2, les pages indexées dans le crawl 1 par Google, mais qui ne sont plus dans la structure seront crawlées dans le crawl 2 et perçues comme des pages orphelines.

#4 Surveillez la qualité de la refonte éditoriale

La comparaison des crawls peut également vous aider à vérifier si votre stratégie éditoriale est sur le droit chemin. Supposons que vous avez détecté un trop grand nombre de pages contenant du contenu faible et que vous souhaitez enrichir ces pages… Avec la comparaison des crawls vous pouvez contrôler et voir si toutes ces pages ont été optimisées, si certaines nécessitent encore des améliorations ou même si vous en avez oubliées. Il en va de même pour les balises principales. Vous pouvez analyser leur qualité crawl après crawl. De manière générale, cet outil peut vous aider à adapter vos stratégies.

#5 Surveillez votre contenu dupliqué

En sachant que le contenu dupliqué n’est pas recommandé, il faut s’assurer que l’optimisation de la totalité du contenu de votre site est bien effectuée dès le départ. Avec le crawl over crawl, vous pouvez surveiller votre processus et facilement comparer le crawl 1 avec le crawl 2.

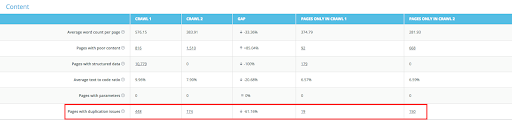

Dans la capture d’écran ci-dessous, vous pouvez mesurer l’écart entre le crawl 1 et le 2. Dans ce cas-ci, il y a une diminution de 61% du contenu dupliqué :

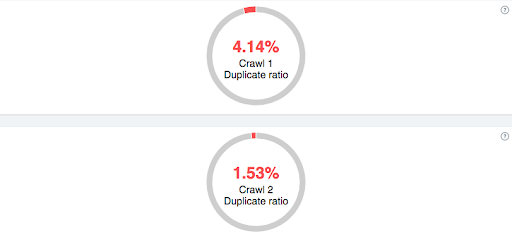

De même pour le cas suivant, vous pouvez clairement identifier votre ratio de contenu en double et évaluer où vous améliorer :

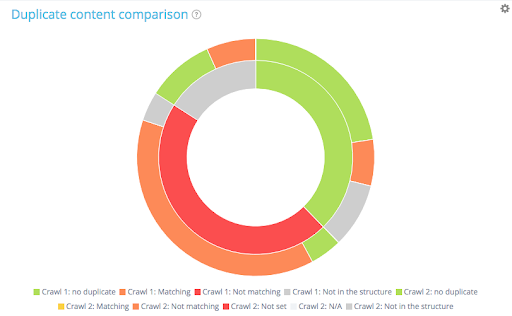

Si l’on se concentre maintenant sur la comparaison du crawl 1 avec le crawl 2, on peut accéder à plus d’informations sur les pages non dupliquées, si les canoniques sont bien mises en place ou non correspondante ou encore voir si les pages sont dans la structure ou non.

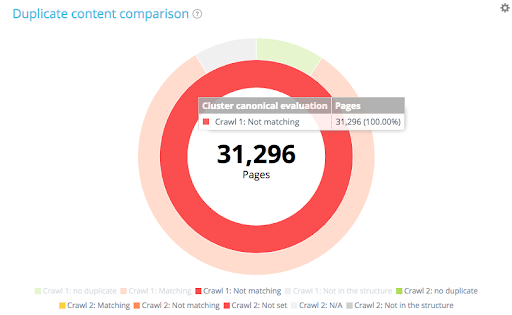

Concentrons-nous désormais sur les canoniques en “not matching” dans le crawl 1 :

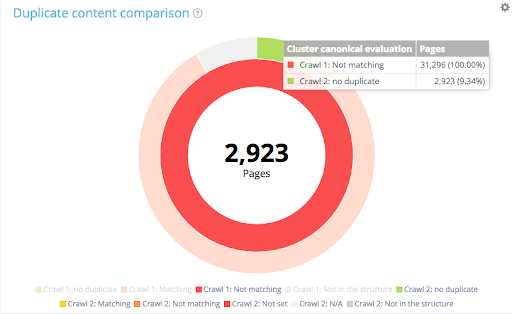

Dans les 31 296 pages avec des canoniques “not matching” dans le crawl 1, 2 923 non aucun problème de duplication dans le crawl 2 :

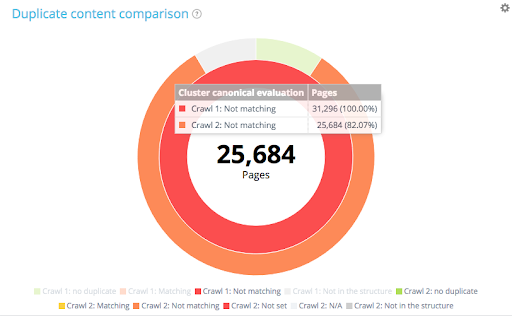

25 684 pages n’ont toujours pas de canoniques propres dans le crawl 2 :

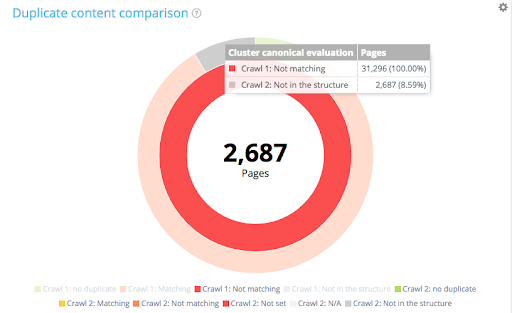

Et 2 687 pages ont été supprimées de la structure :

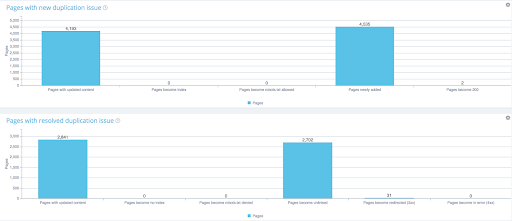

Vous pouvez alors comprendre pourquoi les pages se sont dupliquées lors du crawl 2 ou comment elle ont été améliorées :

#6 Améliorez votre temps de chargement

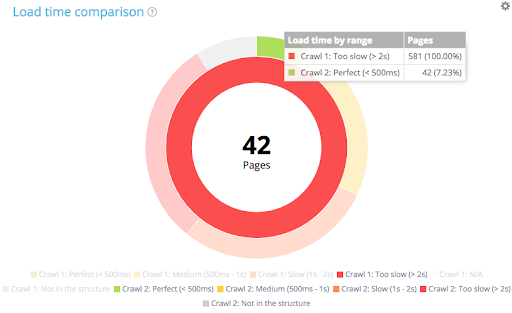

Si vous rencontrez des difficultés de temps de chargement, le crawl over crawl vous permet d’avoir une vue d’ensemble sur ce qui reste à améliorer :

Dans le cas ci-dessus, j’ai uniquement sélectionné les pages “too slow” du crawl 1. Dans le crawl 2, nous pouvons voir qu’il y a seulement 42 pages qui ont bien été optimisées et qui prennent moins de 500 ms pour télécharger.

Pour les sites e-commerce, le temps de téléchargement a un impact majeur sur les conversions et les ventes. Cela étant dit, les pages qui prennent plus de 3 secondes à charger font face à un taux de rebond non négligeable (40%) et sont donc à éviter.

#7 Regardez si les nouvelles redirections agissent correctement

Imaginez que vous avez 200 pages à supprimer, vous pouvez choisir d’écrire une regex pour faire des redirections sur ces pages. Avec les comparaisons de crawl, vous pouvez vérifier que les pages qui ont été redirigées sont les bonnes. À noter qu’il peut arriver qu’une regex redirige plus de pages que prévu.

D’autre part, si vous avez des pages en 3xx ou 4xx que vous souhaitez déplacer en 200, vous pouvez avoir une première idée du volume de pages à travers notre Data Explorer et obtenir une liste exhaustive des pages concernées.

#8 Vérifiez si vous avez des nouvelles pages en 4xx ou avec un statut 200

Il est également intéressant de comprendre si entre deux optimisations SEO, vous avez généré des erreurs 4xx sans le faire exprès. Avec le crawl over crawl, vous pouvez clairement identifier ce type de page. Vous pouvez également vérifier que les pages en 404 dans le crawl 1 ont été corrigées et renvoient maintenant au code statut 200.

#9 Analyser comment vos liens internes et votre Inrank agissent

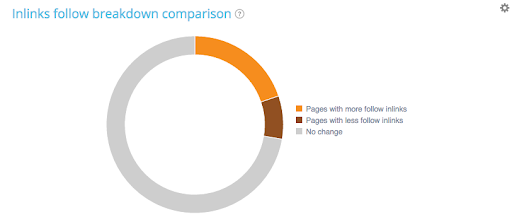

Vous optimisez actuellement vos liens internes ? Vous pouvez vérifier l’évolution de vos liens internes entre votre 1er et 2eme crawl. Vous pouvez également cliquer sur le graphique pour voir quelles pages ont gagné ou perdu des liens internes.

Vous pouvez également voir quelles pages ont reçu le plus des liens internes :

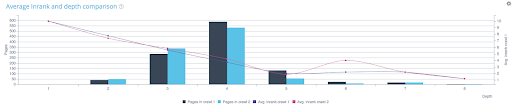

Si vous devez analyser comment l’optimisation de vos liens internes se fait, vous pouvez regarder l’évolution du Inrank. Il marque la popularité de votre page en utilisant une échelle de 0 à 10.

Dans cet exemple, le Inrank a légèrement augmenté sur les pages avec une profondeur de 6. Est-ce que cela a été fait exprès ? Vous pouvez également voir que la majorité des pages sont situées à la profondeur 4. Devriez-vous optimiser la popularité de ces pages par rapport aux pages moins profondes ? En clair, ce type de données peut vous aider à gérer votre stratégie de liens internes.

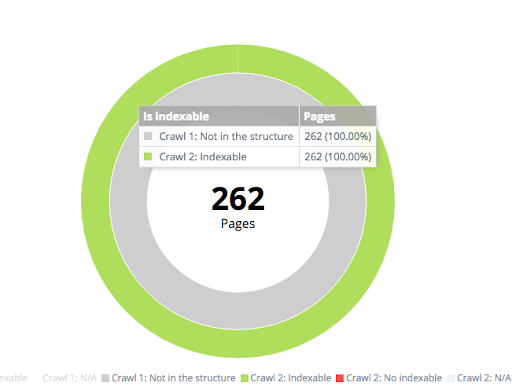

# 10 Obtenez une vue d’ensemble de toutes les pages nouvellement créées entre 2 crawls

Vous pouvez également identifier les pages qui n’étaient pas dans le premier crawl, mais qui apparaissent dans le second. Ces pages peuvent soit être indexables ou non indexables. Dans la capture d’écran ci-dessous, 262 pages qui n’existaient pas dans le premier crawl ont été créées dans le second et sont désormais indexables.

Avez-vous des questions concernant notre fonctionnalité Crawl over Crawl ? Nous aimerions recevoir vos commentaires, alors n’hésitez pas à nous laisser un mot sur @Oncrawl_CS.