Précédemment, nous avons parcouru la façon dont l’API Oncrawl peut être utilisée pour mettre à l’échelle votre data science SEO avec du code Python. Si vous avez suivi les étapes, vous êtes maintenant prêt pour le SEO scientifique.

Avec la data à disposition, nous pouvons maintenant commencer à examiner les données techniques SEO et finalement générer des recommandations techniques plus créatives, mais précises, qui rendront le contenu de votre site web plus découvrable et plus significatif pour les moteurs de recherche.

Non seulement vos recommandations seront plus efficaces, mais vous constaterez que lorsqu’il s’agira d’obtenir l’adhésion des décideurs et de vos collègues développeurs (qui ont probablement un esprit très scientifique), le fait de fournir des données facilitera considérablement les choses tout en améliorant votre crédibilité en tant que professionnel du SEO.

Les étapes que nous allons parcourir sont presque les mêmes que celles enseignées dans les cours de data science tels que Udacity et Datacamp, sauf que nous sommes des consultants SEO et que nous allons donc sauter les questions que les purs data scientists pourraient poser lorsqu’ils examinent les données de crawl pour la première fois.

Les étapes sont les suivantes :

- Analyse univariée

- Segmentation des URLs

- Analyse bivariée

Analyse univariée

Lorsqu’il pratique la data science, le data scientist commence par examiner les données, ce que l’on appelle dans le métier l’analyse exploratoire des données (AED). En fin de compte, les data scientists recherchent des caractéristiques (lire des facteurs de positionnement) pour alimenter un modèle qui les aidera à :

- Comprendre le fonctionnement de quelque chose (un processus)

- Faire des prévisions et des prédictions

Pour ce faire, ils examinent les données, principalement pour la distribution d’un facteur de positionnement : cela nous indique si les données sont asymétriques et nécessitent une normalisation, la valeur la plus courante (c’est-à-dire la centralité, la moyenne).

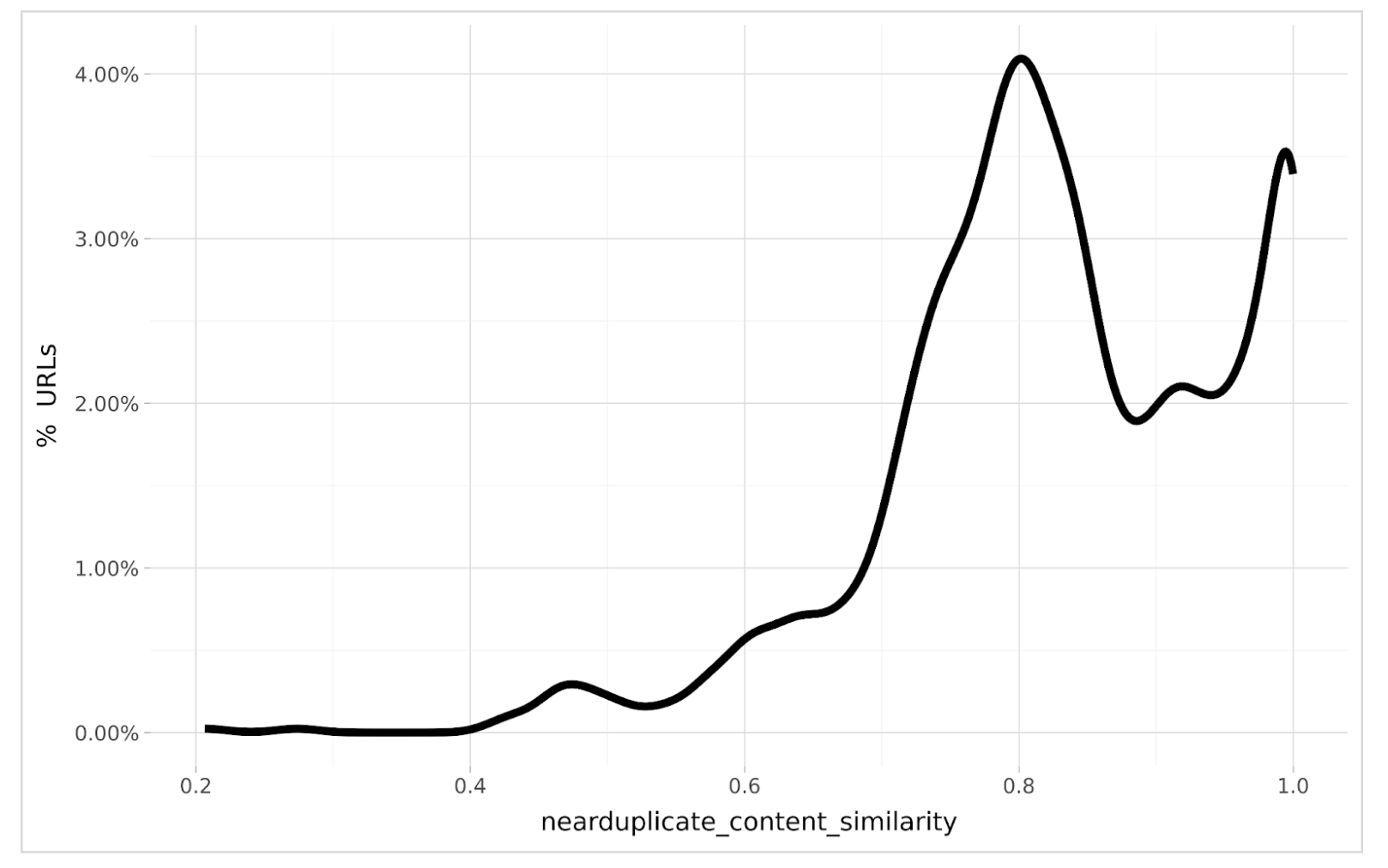

Examinons quelques distributions. Le graphique ci-dessous montre la distribution des URLs dont le contenu est presque dupliqué, soit le volume d’URLs pour différents niveaux de duplication.

Que constate-t-on ? La plupart des URLs sont similaires à 80 %, comme le montre le pic qui se situe juste au-dessus de 4 % du total du site. Il y a un autre pic à 99 % de similarité. En statistiques, ou en langage data science, nous appellerions cette distribution multi-modale car il y a deux valeurs populaires de scores de similarité de contenu dupliqué.

Nous pouvons également constater que la distribution est négativement asymétrique, car les pics se trouvent à droite du centre, de sorte que les valeurs les plus extrêmes se trouvent à gauche, ce qui signifie que le contenu unique est plus rare que courant.

Cette analyse visuelle devrait être effectuée pour tous les problèmes techniques de SEO car elle nous indique ce qui est « normal » pour le site web que nous auditons.

[Ebook] Data SEO : La prochaine grande aventure

Segmentation des URLs

Si la répartition globale est utile, il est encore plus utile de segmenter les URLs par type de contenu. Par exemple, les catégories de produits, les blogs, les pages et les articles de produits si votre site d’audit est un site d’e-commerce.

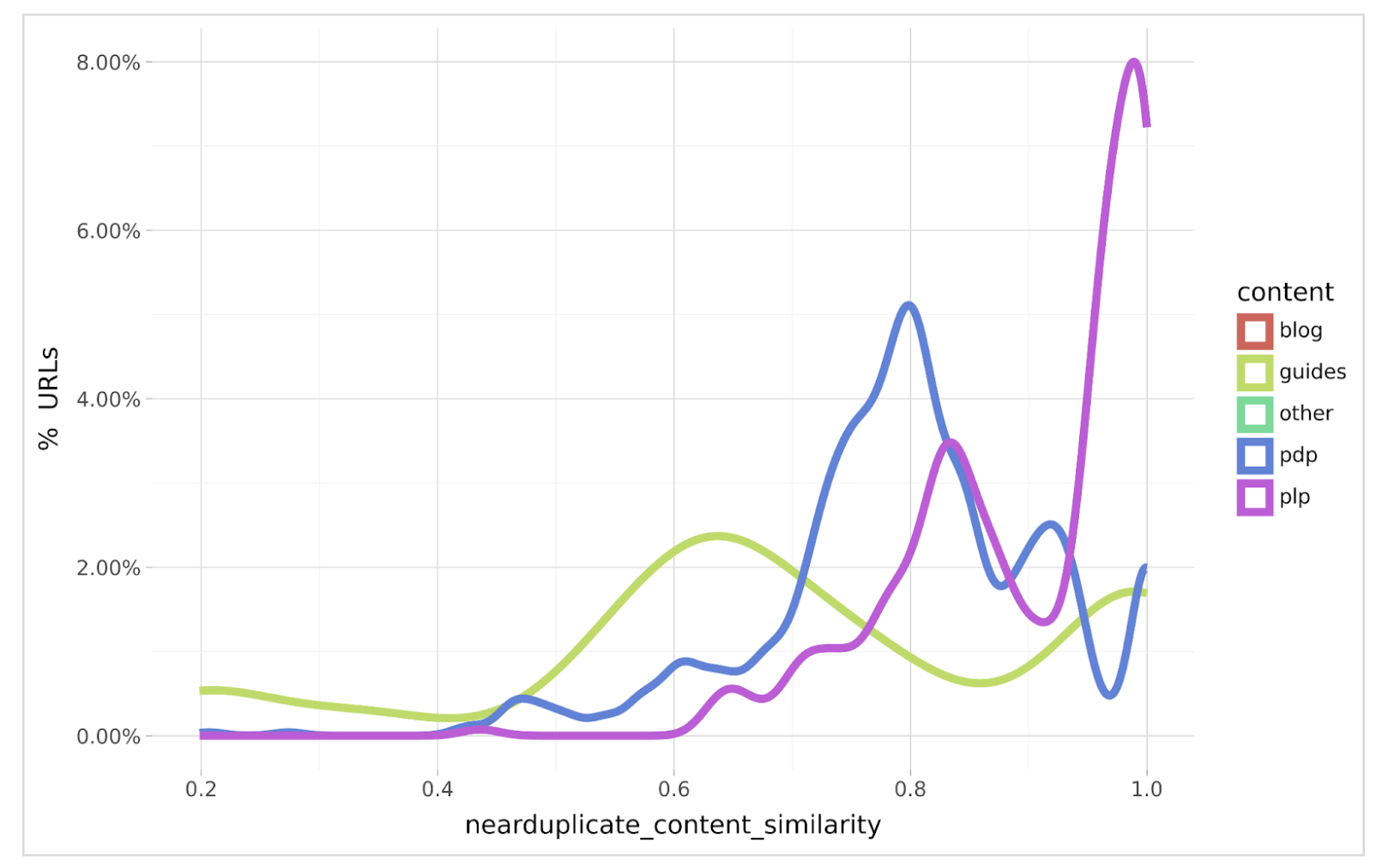

Vous pouvez choisir d’autres segmentations, comme les sous-répertoires, si cela vous aide, vous ou vos collègues, à mieux les comprendre. Le graphique ci-dessous montre une distribution segmentée du contenu presque dupliqué.

La segmentation est un peu plus révélatrice car nous pouvons voir que la plupart des doublons se trouvent dans les pages de détail des produits (PDP) et les pages de liste des produits (PLP).

La segmentation démontre également la raison pour laquelle la distribution globale est multi-modale, puisque les PDPs sont dupliquées à 80% tandis que les PLPs sont dupliquées à 98%.

Cela nous donne intuitivement des modèles sur lesquels nous pouvons nous concentrer pour revoir la conception et l’ingénierie afin de réduire la duplication pour les deux types de contenu.

Nous pouvons également constater que le contenu des blogs n’apparaît pas dans le graphique, ce qui indique qu’il n’y a pas de duplication récurrente dans ce type de contenu.

Dans le cas des guides, la duplication est de 65%, mais grâce à l’analyse segmentée, nous sommes en mesure d’établir un ordre de priorité pour les duplications de contenu à résoudre en premier lieu.

Analyse bivariée

Naturellement, la question suivante se pose de manière tout à fait prévisible : quelle est la performance attendue de la résolution du contenu dupliqué, c’est-à-dire pourquoi l’organisation devrait-elle consacrer des ressources de conception et/ou de développement à la résolution de ce problème ?

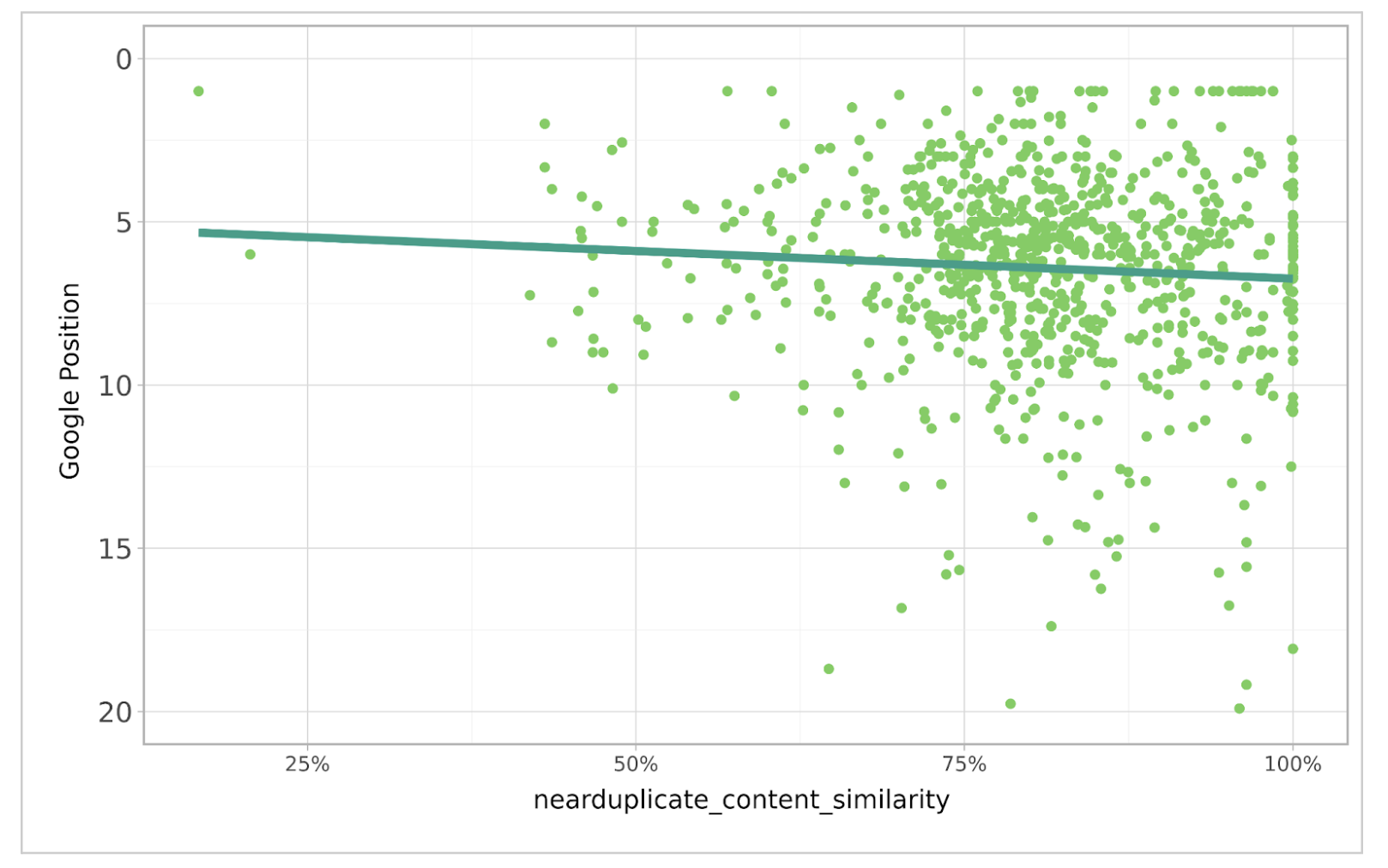

Je suggère d’utiliser un graphique de corrélation, dont l’exemple ci-dessous montre la corrélation entre le Google Rank (provenant de Google Search Console, également disponible dans Oncrawl) et la similarité du contenu dupliqué.

La corrélation est positive car nous pouvons voir que la réduction de la duplication conduit à un meilleur positionnement dans Google. Bien que la corrélation ne soit pas la plus forte, elle reste très bonne si l’on considère les centaines d’autres facteurs de positionnement pris en compte par Google.

Avec un peu de modélisation statistique, le coefficient bêta démontrerait la quantité d’amélioration de la position dans le classement Google disponible pour chaque diminution de 1% de la similarité du contenu presque dupliqué.

Conclusion

Jusqu’à présent, nous avons vu que l’adoption d’une approche statistique des données techniques SEO peut nous en dire beaucoup plus sur la nature de la fonctionnalité d’un site que de se fier simplement à leurs moyennes. Elle permet de savoir où se trouvent la plupart des données et quelle est la prévalence de la fonctionnalité technique.

La segmentation des données nous permet de mieux comprendre quel contenu est le plus affecté par telle ou telle caractéristique technique et d’accélérer la résolution du problème.

Si nous utilisons l’analyse de régression pour établir une corrélation entre la caractéristique technique et le positionnement, nous pouvons plus facilement communiquer le fait que la caractéristique technique est en fait un problème, et indiquer l’avantage de la résoudre.

Cependant, n’oubliez pas que tous les facteurs techniques ne peuvent pas être résolus en examinant les données d’audit d’un seul site. Par exemple, le rapport entre le texte et le code est probablement similaire pour l’ensemble du contenu du site d’un client. Seule, cette information n’a guère de sens. Il faut donc la replacer dans son contexte en la comparant à celle des concurrents, ce que nous verrons dans la partie 3.