L’analyse de logs est la seule manière d’obtenir des données 100% exactes lorsque vous analysez vos performances SEO. Les logs vous aident à fouiller les données de Google plus efficacement et à savoir exactement ce que les moteurs de recherche font sur votre site, quelles pages sont crawlées, actives et s’il y a des erreurs sur celui-ci.

François Goube a récemment réalisé un webinar avec SEMRush sur comment débloquer la boite noire de Google grâce à l’analyse de logs. Voici les points clés à retenir.

Peu importe la taille de votre site, l’analyse de fichiers de logs peut vous aider à débloquer des opportunités d’optimisations SEO. En effet, l’analyse de fichiers de logs est utile lors de l’audit de votre site pour identifier les pages importantes ou inutiles et les pages que Google voit ou non. L’analyse de fichiers de logs vous permet également de surveiller vos pages et ainsi de créer des alertes et de vérifier si vous avez des spams ou des attaques.

Pourquoi utiliser l’analyse de logs ?

L’analyse de fichiers de logs souligne ce que Google fait réellement sur votre site et ce qu’il a fait dans le passé. Vous pouvez savoir lesquelles de vos pages sont les plus actives et si Google a rencontré des erreurs. En fait, le moteur de recherche essaye d’optimiser ses ressources de crawl au maximum puisqu’il a un budget de crawl prédéfini à respecter. S’il a décidé de crawler 1000 pages par jour, il faut que vos pages les plus importantes soient crawlées et indexées avec ce quota.

10 cas pratique pour comprendre ce que Google fait sur votre site

1# Sachez ce que Google crawle

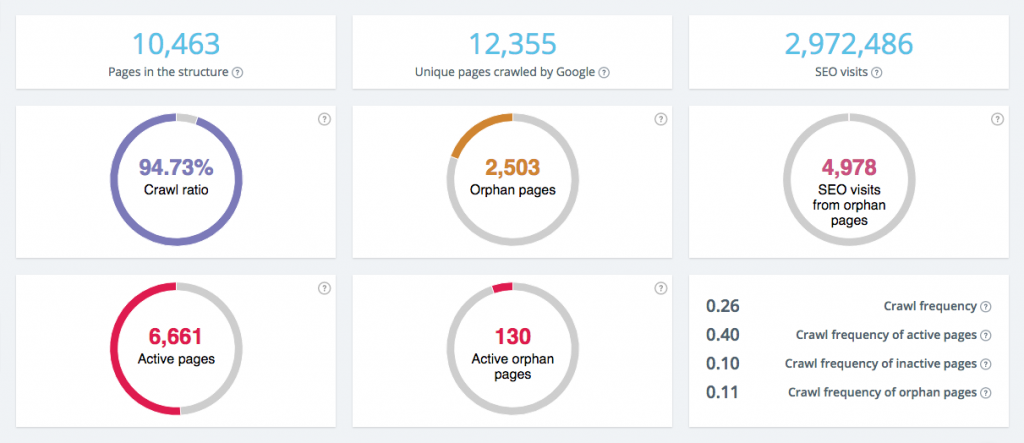

L’analyse de fichier de logs vous permet de savoir le nombre de pages uniques que vous possédez et la fréquence de crawl de Google. Il est intéressant de savoir si, a l’intérieur de ces pages uniques que Google crawle, toutes vos pages s’y trouvent et non pas de vieilles URLs qui n’existent plus.

Si vous êtes un site e-commerce, cela peut vous aider à vérifier que toutes vos pages produits sont crawlées par Google ou si du nouveau contenu a été découvert.

2# Sachez si Google favorise des endroits spécifiques de votre site

Comme nous avons dit, Google décide d’un certain budget de crawl pour votre site donc vous devez l’optimiser. Avec l’analyse de logs, vous pouvez identifier les endroits ou Google dépense son budget de crawl: si c’est sur les pages qui vous rapportent de l’argent ou les pages qui n’ont pas de valeur et ne génèrent pas de visites SEO (visites depuis les résultats organiques).

3# Sachez ce qu’aime Google

Vous pouvez identifier vos pages actives et donc les pages qui reçoivent du trafic SEO. Cela vous aide à déterminer le ratio actif, en prenant en compte toutes les pages que Google connaît. En d’autres termes, c’est le pourcentage de pages qui génèrent du trafic sur toutes les pages que connaît Google.

Le Fresh Rank (métrique maison d’Oncrawl) vous aide aussi à déterminer si Google apprécie votre site. C’est une métrique qui calcule le temps qu’il faut à une page entre le moment ou Google la découvre et où il envoie sa première visite. C’est assez utile pour savoir combien de temps vous allez devoir attendre pour positionner un produit par exemple.

4# Identifier les obstacles

L’analyse de logs est également utile pour identifier les obstacles à l’indexation des pages. Vous pouvez, par exemple, surveiller vos status codes. Disons que vous avez une augmentation de redirections 302 pendant un certain temps; vous pouvez alors en déduire que cette mise à jour n’a pas bien fonctionnée. Cela a un impact non négligeable sur votre fréquence de crawl et a tendance à baisser le budget de Google. C’est pour cela qu’il est important de corriger rapidement ce genre d’erreurs et les alertes en temps réel peuvent vous aider.

Parfois, les status codes changent aussi, surtout avec des CMS qui peuvent avoir des comportements bizarres. Les pages avec des status codes qui changent trop fréquemment diminueront la fréquence de crawl de Google. Encore une fois, pouvoir voir ces changements en temps réel peut vous aider à prendre des mesures plus rapidement.

5# Regardez l’impact SEO par groupes de pages

Il est utile de rassembler vos pages en groupes pour identifier votre trafic par groupe, voir la performance de vos pages produits et des pages les plus actives et enfin de vérifier les groupes qui ont les performances les plus basses. C’est également pratique pour valider vos différentes optimisations par groupe de page.

6# Fusionnez vos données de crawl et de logs

Lorsque vous faites de l’analyse de logs, il est intéressant de comparer ce que fait Google avec la théorie de la structure de votre site.

Pour ce faire, vous pouvez comparer les données de vos crawls avec ce que Google connaît réellement. Si Google connaît plus de pages que celles présentes dans la structure de votre site, cela peut entraîner des problèmes de pages orphelines ou de pages que Google ne connaît pas. En effet, les pages orphelines sont des pages que Google connaît mais qui ne sont pas reliées à la structure et donc qui ne sont pas populaires puisqu’il n’y a pas de liens qui pointent vers elles.

7# Trouvez le critère à optimiser

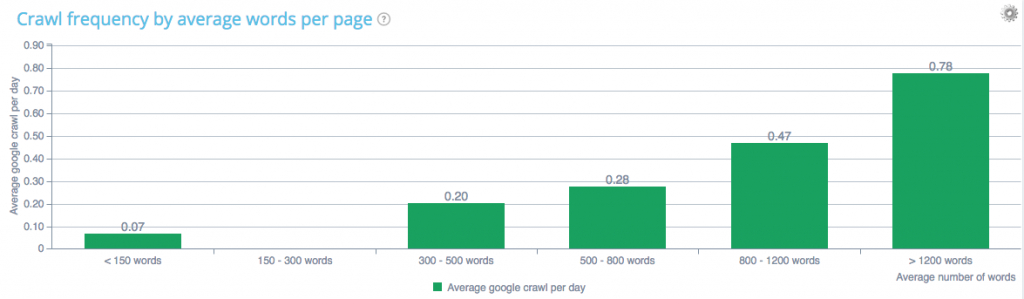

L’analyse croisée des données de crawl et de logs vous aide également à déterminer le facteur que vous devriez optimiser. Par exemple, quel est l’impact du nombre de mots ? On sait que l’on a besoin de contenu original, long, très bien mais combien de mots exactement ? Selon le thème, ce nombre peut évoluer mais dans la plupart des cas, moins vous possédez de mots sur vos pages, moins Google a envie de venir sur celles-ci.

Dans la même veine, est-ce que les liens internes sont un critère sur lequel travailler?

Plus vous possédez de liens pointant vers une page, plus Google viendra souvent pour la crawler. Vous pouvez aussi voir que la vitesse de page peut impacter le crawl de Google. Cela peut être utile de le prouver à l’équipe IT. ;)

8# Mesurez l’impact du contenu dupliqué sur les robots

Vous pouvez également mesurer l’impact du contenu dupliqué sur les robots. Les URLs canoniques peuvent être un problème. Si vous avez une seule canonique à l’intérieur d’un groupe de pages dupliquées, Google va arrêter de crawler ces pages et cela peut être le but que vous recherchiez. Mais si ces URLs canoniques sont différentes à l’intérieur de ce groupe de pages dupliquées, Google les crawlera comme d’habitude, comme s’il n’y avait pas de contenu dupliqué. Dans ce cas, vous ne faites pas d’économies sur votre budget de crawl.

9# Jugez votre architecture

Avec l’analyse de logs et de crawl, vous pouvez regarder vos groupes de pages par profondeur. Êtes vous sur d’avoir placé les bonnes pages à la bonne profondeur ? La profondeur de crawl est un paramètre qui peut impacter votre ratio de crawl. En effet, si vous avez des pages loin de la page d’accueil, elles seront crawlées moins souvent. Évidemment, vous pouvez améliorer cet effet grâce à un maillage interne transversal plus dense mais à partir du niveau 7 ou 8, Google a du mal à trouver vos pages.

10# Établissez des priorités concernant vos actions

L’analyse croisée peut vous aider à détecter des facteurs qui ont un impact sur le comportement des robots mais aussi à déterminer les pages sur lesquelles vous concentrer. Est-ce que c’est vos pages produits ? Vous pouvez savoir combien d’entre elles génèrent du trafic et des visites SEO afin de savoir sur lesquelles travailler en priorité.

Avec l’analyse croisée, vous pouvez ainsi connaître les facteurs qui ont un impact sur les performances de vos pages.

De plus, toute hypothèse doit être validée avec des données. Avec des outils en SaaS comme Oncrawl, vous trouverez plus de 300 métriques à utiliser pour effectuer vos requêtes, valider vos hypothèses et les exporter pour travailler dessus. C’est plus simple pour établir des priorités d’actions et justifier de leur efficacité.

Pour résumer, la clé avec l’analyse de logs est de croiser les données de logs avec celles de crawl pour ouvrir la boite noire de Google. Cela vous aidera à découvrir vos pages orphelines, savoir où se trouve vos pages actives et celles que vous devez optimiser etc..