Le plus important dans notre métier c’est de réussir un croisement de données SEO efficace et pertinent. Avec l’habitude, on remarque que certains croisements sont plus puissants que d’autres et qu’au fil des créations de segmentations avancées, certaines régularités se dessinent.

“Plein de données c’est bien mais savoir quoi en faire c’est mieux !” Paul Sanches, Président de SEO Hackers

Dans cet article nous tâcherons de vous partager les meilleurs modèles de représentation des données disponibles dans Oncrawl et comment utiliser les croisements pour révéler les optimisations les plus génératrices de valeur. Mais cet article est avant tout un moyen de vous faire comprendre que chaque graphique d’Oncrawl peut (et doit) être abordé sous différents angles de vue.

Vous comprendrez comment chaque prisme par lequel vous abordez un graphique peut révéler une optimisation ou confirmer/infirmer une hypothèse et qu’il est utile de maîtriser les fonctionnalités avancées dans Oncrawl telles que :

- Les segmentations “metric based”

- Les customs fields pour utiliser les données scrapées pour grouper les pages

- Le croisement des segmentations dans les customs dashboards

Tous les exemples de segmentation dans cet article sont disponibles pour téléchargement au format JSON. Pour les appliquer à vos propres données dans Oncrawl, suivez les instructions dans cet article pour créer une nouvelle segmentation. Vous devrez choisir « From an existing set or import » puis « Paste JSON ».

NB : Il est important que vous conserviez exactement le nom proposé pour les segmentations lors de la création pour profiter de nos prochaines updates.

Demandez votre démo personnalisée

Les segmentations sur les différentes métriques

Une bonne segmentation est une segmentation qui permet de mettre en perspective un champ d’Oncrawl pour les classement des pages sur la base des différentes valeurs d’un jeu de données.

Prenons cinq exemples simples :

- Quelles sont les pages qui rankent sur des expressions clés pour les positions feature snippets ?

Segmentation : oncrawl-segmentation-seo-voice-search.json

Name : SEO voice search - Quelles sont les pages les plus génératrices de visites ?

Segmentation : oncrawl-segmentation-seo-top-visits-by-day.json

Name : SEO visits by day - Quelles sont les pages les plus importantes aux yeux de Google ?

Segmentation : oncrawl-segmentation-log-bot-hits-by-day.json

Name : LOG bot hits by day - Quelles sont les pages les plus dupliquées de mon site ?

Segmentation : oncrawl-segmentation-seo-duplicate-rate.json

Name : SEO duplicate rate - Quelles sont les pages les mieux positionnées sur Google ?

Segmentation : oncrawl-segmentation-gsc-positions.json

Name : GSC positions

Si vous avez un modèle visuel de représentation de ces cinq aspects importants du SEO et que vous pouvez les utiliser dans n’importe quelle analyse d’Oncrawl, vous êtes en mesure de détecter rapidement les optimisations les plus importantes ou porteuses de valeur et de prioriser vos chantiers techniques sur la base de données chiffrées solides.

Et bien c’est ce que les segmentations Oncrawl vous permettent de faire… et nous sommes les seuls à proposer cette fonctionnalité !

Quelques exemples tirés des 5 points précédents :

- 1. Est-ce que toutes les pages qui rankent sur des potentielles “featured snippets” reçoivent des visites ?

- 2. Est-ce que la fréquence de crawl de mes top visited pages est supérieure à la moyenne ?

À priori il y a une forte corrélation ;)

Ou mieux ! Est-ce qu’il y a des pages “top visited” qui ne reçoivent plus de liens ?

- 3. Y a-t-il une corrélation entre le nombre de clics depuis la home page et le crawl de Google ?

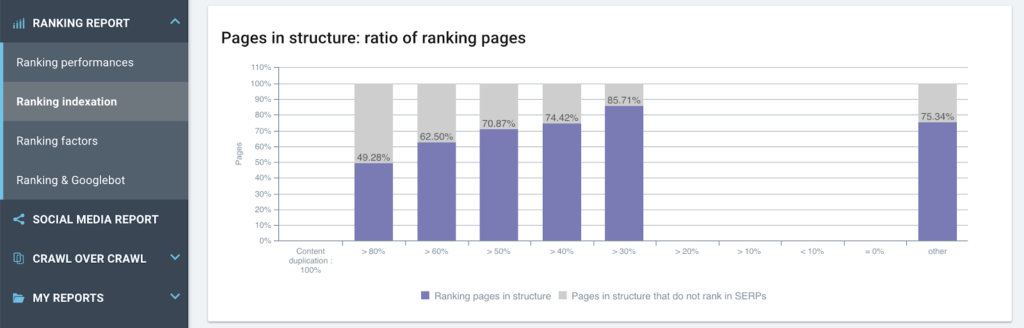

- 4. Y a-t-il un impact du duplicate content sur les rankings ?

- 5. Google crawle-t-il plus souvent les pages en fonction de leur rankings ou les rankings indiquent-ils que la fréquence de crawl est reliée aux rankings ?

NB: en tant que Customer Success Manager, nous voyons ce modèle sur la quasi totalité des sites et voici comment l’interpréter :

– De droite à gauche les position s’améliorent et la fréquence de crawl augmente.

– Jusqu’à la position 2-3 qui a 3x plus de bots hits que les positions suivantes de la page 1 de la SERP.

– Mais sur la position 1 (moyenne sur la période), la fréquence de crawl est largement inférieure à tous les autres groupes.

Lorsqu’une page est en Position 1 alors ce n’est plus elle que Google vient vérifier, ce sont ses concurrentes (imaginez ce graphique sur le site de vos concurrents – il est le même dans 90% des cas) donc les pages des sites concurrents en Position 2-3.

Vous l’avez compris, avoir de nouveaux angles de vue dans certaines données permet de tirer des enseignements essentiels pour votre stratégie de référencement naturel.

Voici maintenant quelques segmentations intéressantes.

Temps de chargement

Actuellement le temps d’affichage est un facteur important, tant d’un point de vue utilisateur que pour les crawlers de Google. La segmentation basée sur la métrique “Load Time” permet de classer les pages des plus rapides aux plus lentes et de suivre l’impact du temps de chargement sur les comportements de vos users (croisement avec le CTR si GA est activé), les comportements des bots d’indexation dans les LOGs et les performances ranking avec GSC.

Segmentation : oncrawl-segmentation-seo-load-time.json

Name : SEO load time

Impact de la profondeur sur les temps de chargements

Plus une page est profonde, plus elle met du temps à répondre

NB: par expérience nous savons que plus une page est profonde moins les composants de l’architecture système ont mit en cache les données, les bases de données n’ont pas les requêtes en mémoire, les systèmes de cache n’ont pas leur contenu. Ces pages ne sont pas très sollicitées, c’est normal !

Impact du temps de chargement sur les performances rankings

Plus nombreuses sont les pages qui répondent rapidement, plus il y a de pages qui rankent

Indexabilité

Cette segmentation permet d’identifier rapidement les défauts d’architecture en identifiant les liens internes qui pointent sur les mauvaises versions des pages ou vous indiquer le Inrank (taux de popularité interne) envoyé aux mauvais groupes.

Segmentation : oncrawl-segmentation-seo-indexability.json

Name : SEO indexability

Nombre de liens entrants moyen par type d’indexabilité

Beaucoup de liens perdus sur un groupe en deny robots.txt ainsi que sur des pages “non compliants”

Fréquence de crawl par type d’indexabilité

De nombreuses pages orphelines sont actives et sont les plus consommatrices de budget de crawl

Segmentation Google Search Console

Le croisement des données GSC dans Oncrawl crée de nouveaux champs sur lesquels il est possible de grouper les pages. Positions, CTR, impressions, clics deviennent des segments.

Segmentation : oncrawl-segmentation-seo-load-time.json

Name : GSC impressions

Représentation de la fréquence de crawl par impressions sur Google

On constate qu’il existe une cohérence dans les données (crawl budget vs impressions)

Segmentation : oncrawl-segmentation-gsc-positions.json

Name : GSC positions

Vision de la performance ranking en fonction de l’architecture

Plus une page est profonde moins elle rank

Segmentation : oncrawl-segmentation-gsc-clicks.json

Name : GSC clicks

Impact de la profondeur sur les clics (donc les visites SEO)

Plus une page est haute plus elle performe en SEO

Segmentation : oncrawl-segmentation-gsc-ranking-pages.json

Name : GSC ranking pages

Impact de la popularité interne sur la capacité à faire des impressions (rankings)

Il y a clairement des actions à entreprendre sur le maillage du site

Segmentation : oncrawl-segmentation-gsc-ctr.json

Name : GSC ctr

Groupement des CTR moyens par page entre les positions 4-10

Cela permet de cibler rapidement les premières pages à optimiser (meilleurs CTR) et de prioriser les actions pour maximiser les résultats

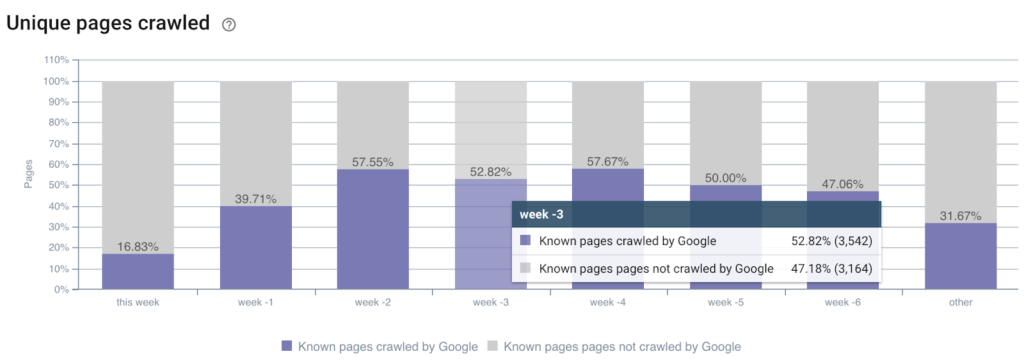

Segmentation sur les logs

Les segmentations issues des logs permettent une représentation évidente pour analyser chaque graphique d’Oncrawl. Lorsque l’on groupe les pages en fonction du nombre de visites SEO (et pourquoi pas par type de bot – mobile/desktop) ou par nombre de bots hits par jour (budget de crawl) on peut visualiser l’impact de chaque élément SEO issu du crawler.

Segmentation : oncrawl-segmentation-log-bot-hits-by-day.json

Name : LOG bot hits by day

Représentation de la fréquence de visites de Googlebot en fonction de la moyenne du nombre de mots par page

Segmentation : oncrawl-segmentation-log-seo-visits-by-day.json

Name : LOG seo visits by day

Analyse du rapport entre popularité interne et nombre de visites depuis les moteurs de recherche

Plusieurs optimisations à en déduire : les pages les plus populaires sans visites sont à démailler / certaines pages avec de nombreuses visites peuvent être peu populaires et les renforcer serait une bonne optimisation

Segmentation de répartition de la performance d’acquisition

Pour aller plus loin, vous pouvez choisir de grouper les pages en fonction des performances qu’elles réalisent déjà, cela vous permet de cibler des ensembles déjà porteurs de valeur et de repérer rapidement s’il y a des optimisations (depth, Inrank, content, duplication, load time, etc) à mettre en place. En optimisant des ensembles de pages qui ont déjà de bonnes performances d’acquisition, il est possible de créer un effet levier non négligeable sur le trafic. Vos efforts sont maximisés !

Segmentation : oncrawl-segmentation-seo-top-visits-by-day.json

Name : SEO top visits by day

NB : Cette segmentation exemple utilise les données de logs, mais peut être faite avec les sessions GA ou les clics GSC

Les segments sur les données scrapées

Oncrawl permet de récupérer des champs personnalisés issus de règles d’extraction du code source (XPATH ou REGEX). Ces nouveaux champs peuvent être utilisés pour créer des ensembles représentatifs des pages. Les types de pages, le data layer ou les dates de publication peuvent être utilisés pour de nouvelles segmentations.

Segmentation : oncrawl-segmentation-date-published.json

Name : date published

Taux de crawl des pages en fonction de leur date de publication

NB : le champ extrait doit se nommer publicationDate et le type date permet une segmentation glissante qui se verra mise automatiquement à jour à chaque crawl

Représentation du nombre moyen de liens entrants vers les pages en fonction de leur date de publication

Mise en forme de l’architecture du site par date de publication

Segmentation basée sur le pagetype (données data layer)

Une fois vos règles de scraping déclarées dans la crawl config (article sur le sujet) vous obtenez des nouveaux champs qui correspondent exactement aux données que toute votre équipe a l’habitude d’utiliser. Lorsque votre DataLayer est posé, il est utilisé par l’ensemble des métiers qui travaillent avec vous, et fournir des rapports qui utilisent une dénomination commune permet de se rassembler.

Etude du ratio de pages qui rankent / crawlées ou non par Google en fonction du type de page issu du data layer

Le croisement de segments

Prise une par une, ces segmentations sont capables de vous guider dans la découverte d’optimisations ou de facteurs bloquants d’un point de vue macro, mais Oncrawl vous permet également d’utiliser ces segmentations d’une manière unique sur le marché : vous pouvez croiser vos différents modes de représentation et affiner vos analyses en couplant les filtres et des graphiques forcés sur une segmentation dans les Custom Dashboards.

Si vous connaissez la fonctionnalité Custom Dashboard (vidéo youtube / article) vous savez qu’il est possible de forcer une segmentation particulière sur un graphique – setting réalisé en cliquant sur le header du graphique lors de la création du rapport – cela permet de conserver la segmentation globale (celle définie dans le menu en haut de page) et visualiser données dans le graphique avec une représentation issue d’une autre segmentation.

Par exemple :

J’aimerais connaître précisément la diffusion du InRank au sein d’un groupe de pages de la segmentation “Top Destination” et afficher les données pour un pays particulier en utilisant le prisme des “Impressions GSC” dans le graphique.

Illustration du croisement de 2 segmentations dans un même graphique

Conclusions

Lorsque l’on sort du cadre trop restrictif des groupements de pages basés sur les URLs on est en mesure d’explorer les données du site sous des angles très différents et plus précis. Oncrawl est aujourd’hui le seul outil permettant de réaliser cette mise en forme sur l’ensemble des données disponibles.

Avec un peu d’expérience et de curiosité vous allez pouvoir faire parler vos données plus efficacement et obligatoirement trouver des axes d’améliorations SEO pertinents qu’il sera plus simple de prioriser.

La seule limite dans la création et l’exploitation des segmentation est celle de votre créativité, à vous de jouer!

N’oubliez pas : toute l’équipe Oncrawl est là pour vous accompagner dans votre démarche.