La compréhension des données de logs en SEO a progressivement augmenté au sein de la communauté SEO. Les fichiers de log sont en fait la seule représentation qualitative de ce qu’il se passe sur un site web. Mais nous avons toujours besoin d’être capable de les faire parler efficacement.

Les visites SEO exactes et les comportements des bots sont présents dans vos fichiers de log. D’un autre côté, les données issues de vos rapports de crawl peuvent vous apporter une solide connaissance de votre performance on-site. Il est utile de croiser vos données de crawl et de logs pour mettre en avant de nouvelles dimensions lorsque vous analysez votre site web.

Cet article vous propose 5 excellents moyens pour croiser vos données de logs et de crawl. Bien sûr, il en existe beaucoup d’autres.

1# La détection des pages orphelines et l’optimisation du budget de crawl

Qu’est-ce qu’une page orpheline ? Si une URL apparaît dans vos logs sans être dans l’architecture de votre site, cette URL est considérée comme “orpheline”.

Google a un index colossal ! Au fil du temps, il va garder toutes les URLs qu’il a déjà découvert sur votre site, même si elles ne sont plus présentes dans l’architecture (changement de slug, pages supprimées, migration complète d’un site, liens externes en erreur ou transformés). Manifestement, laisser Google crawler ces fameuses “pages orphelines” peut avoir un impact sur l’optimisation de votre budget de crawl. Si les URLs obsolètes consomment votre budget de crawl, cela empêche les autres URLs d’être crawlées plus régulièrement et finira forcément par avoir un impact sur votre SEO.

Lorsque vous crawlez votre site, Oncrawl parcourt tous les liens qu’il découvre, profondeur par profondeur et à travers l’intégralité de l’architecture de votre site. D’un autre côté, lors de l’analyse des fichiers de log, Oncrawl compile les données issues des bots de Google et des visites SEO.

La différence entre les URLs connues de Google et celles qui sont reliées dans l’architecture peut être très importante. Il est donc essentiel de mettre en place des optimisations SEO qui ont pour objectif de corriger les liens oubliés ou cassés et de réduire les pages orphelines.

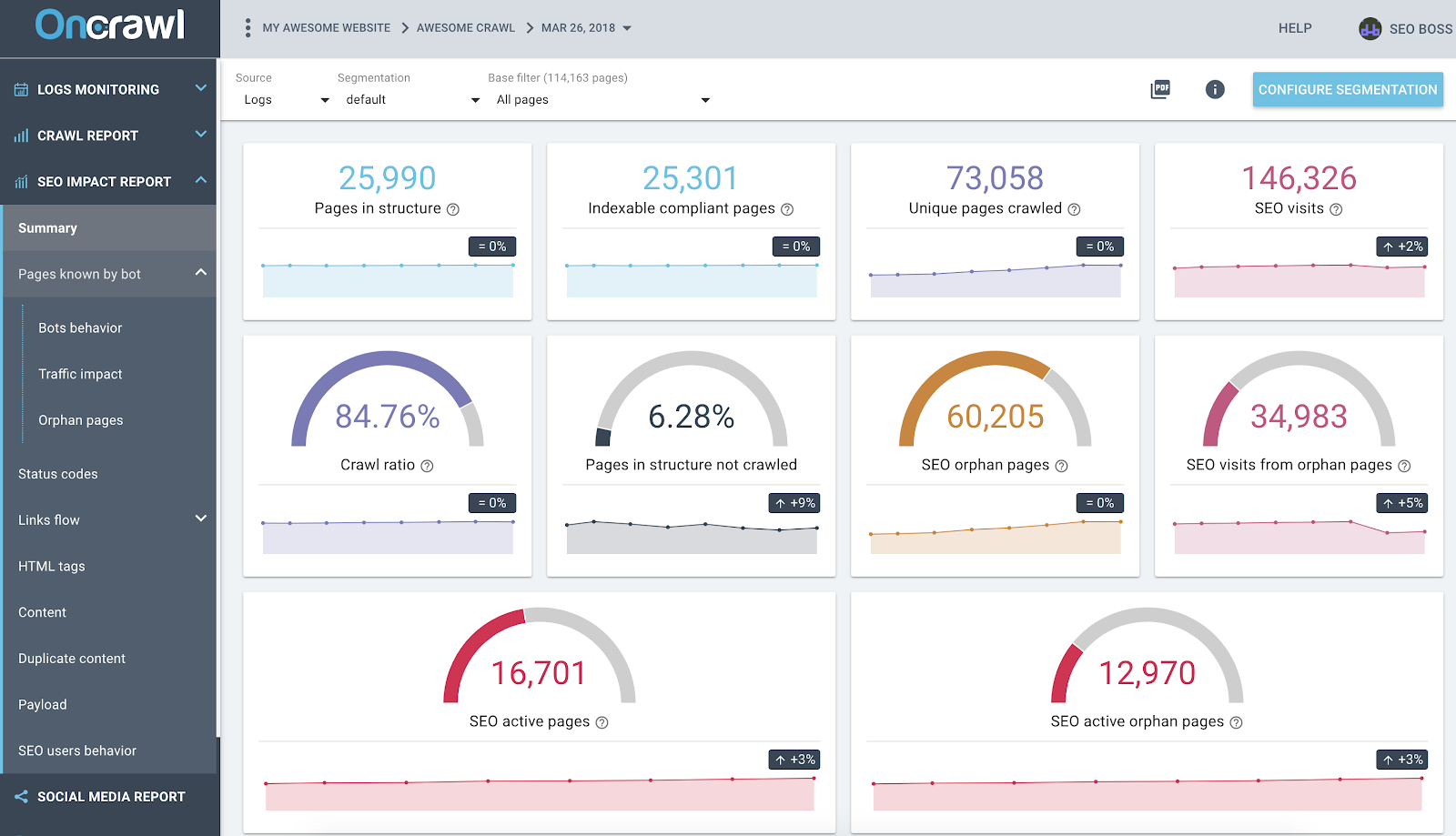

Rapport Oncrawl sur l’impact SEO basé sur des analyses combinant les données de crawl et de logs

La capture d’écran ci-dessus donne un aperçu de l’état de vos données de crawl et de logs. Vous pouvez rapidement remarquer que :

- 25 990 pages sont dans la structure – trouvées par notre crawler et prenant en compte tous les liens qu’il a suivi sur votre site web ;

- 73 058 pages sont crawlées par Google – c’est 3x plus que dans la structure ;

- Un ratio de crawl de 84 % – (Les pages crawlées par Oncrawl + les pages actives depuis les logs + les pages crawlées par Google) / Les pages crawlées par Google ;

- Plus de 6 % des pages internes ne sont pas crawlées – il suffit de cliquer sur la case noire pour avoir la liste des ces pages dans le Data Explorer ;

- 60K pages orphelines – la différence entre les pages dans la structure et les pages crawlées par Google ;

- 34 K visites SEO sur ces pages – il semble qu’il y ait un problème dans le maillage interne !

Bonne pratique : Oncrawl vous donne l’avantage d’explorer les données derrière chacun des graphiques ou des métriques juste en cliquant dessus. De cette manière, vous obtiendrez une liste téléchargeable des URLs qui sont directement filtrées dans le champ que vous avez exploré.

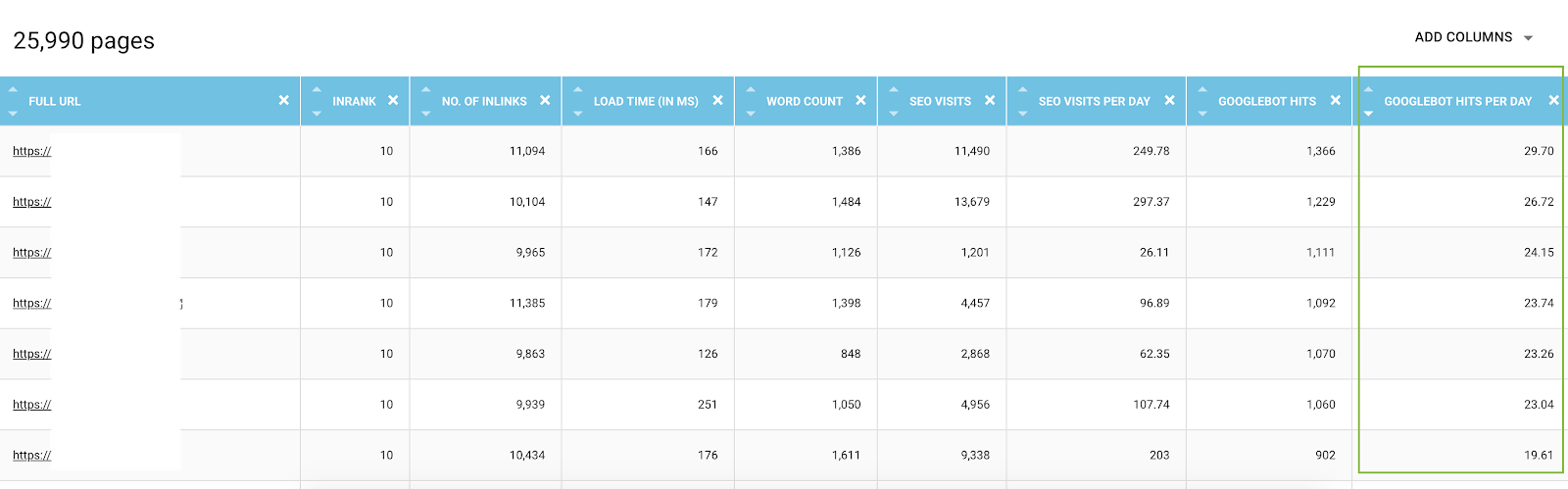

Liste de toutes les URLs depuis le Data Explorer avec les métriques de crawl et filtrées par passages de bots par jour

2# Découvrez quelles URLs consomment le plus (ou le moins) de budget de crawl

Toutes les actions provenant des visites des bots de Google sont connues par la data platform d’Oncrawl. Cela vous permet de savoir – pour chaque URL – toutes les données compilées et classées dans le temps.

Dans le Data Explorer, vous pouvez ajouter pour chaque URL des colonnes résumant les passages de bots (sur une période de 45 jours) et les passages par jour et par bots, ce qui correspond à une valeur moyenne par jour. Ces informations sont précieuses pour évaluer la consommation du budget de crawl de Google. Vous découvrirez souvent que ce budget n’est pas uniforme sur tous les sites.

Liste de toutes les URLs depuis le Data Explorer avec les métriques de crawl et filtrées par passages de bots par jour

En fait, certains facteurs peuvent amorcer ou réduire le budget de crawl. Nous avons donc établi une liste des métriques les plus importantes dans cet article à propos de la page importance de Google. La profondeur, le nombre de liens qui pointent vers une page, le nombre de mots-clés, le vitesse de la page ou encore l’InRank (popularité interne) influencent le crawl des bots. Vous en apprendrez plus dans le paragraphe suivant.

3# Apprenez à connaître vos meilleures et pires pages SEO et déterminez les facteurs de succès de ces pages

Lorsque vous utilisez le Data Explorer, vous avez accès à des métriques clés à propos des pages – mais il peut être compliqué de comparer des centaines de lignes et de métriques ensemble. Utiliser des colonnes pour segmenter les passages de bot et les visites SEO par jour est d’une grande aide dans l’exploration de vos données.

- Téléchargez les fichiers JSON CS – Passages de bot par jour et CS – Visites SEO par jour ;

- Ajoutez-les en tant que nouvelles segmentations.

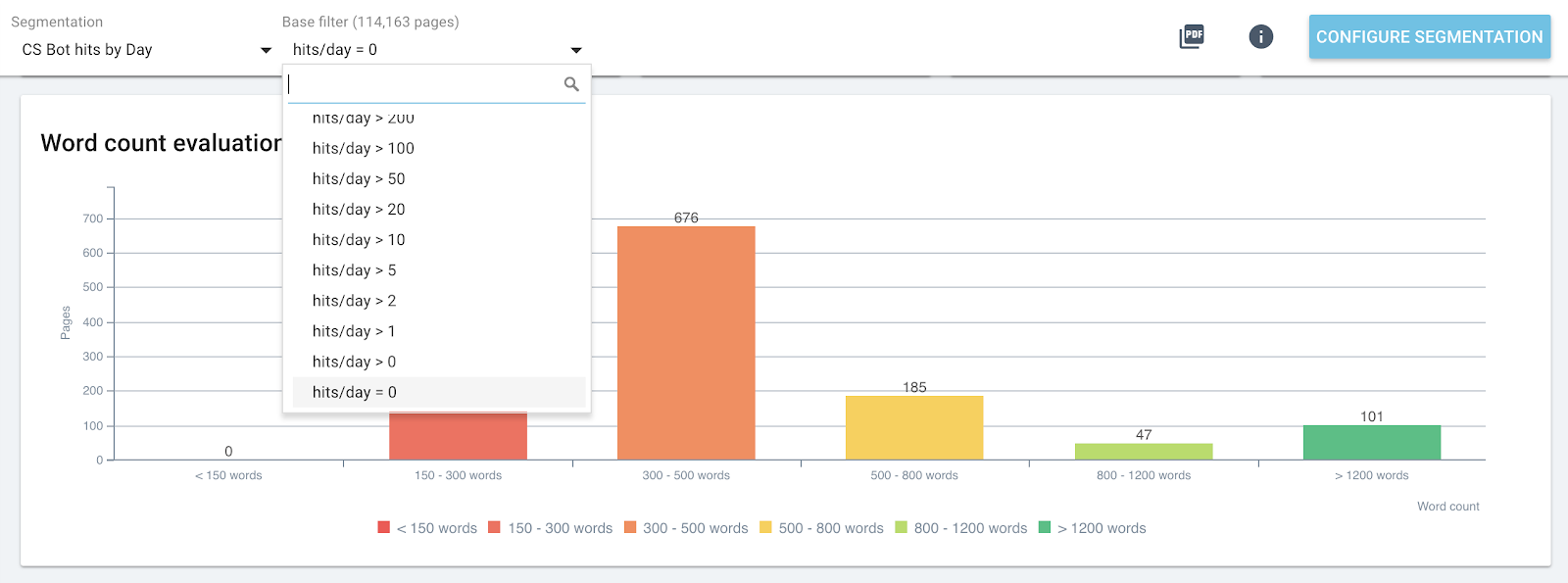

En fait, vous pouvez créer des segmentations basées sur ces deux valeurs résultant de l’analyse de logs pour avoir une première distribution de vos pages par groupes. Mais vous pouvez aussi filtrer chaque groupe de ces segmentations pour rapidement détecter – dans chaque rapport Oncrawl – quelles pages n’atteignent pas les valeurs attendues.

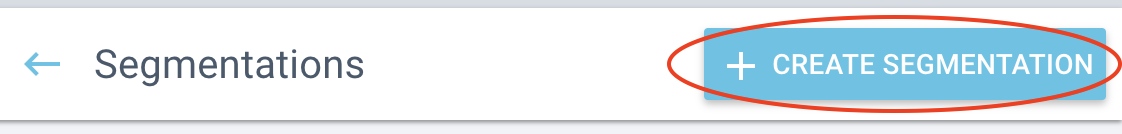

Sur la page d’accueil de votre projet, cliquez sur le bouton “Configure Segmentation”.

Puis “Create a new segmentation”

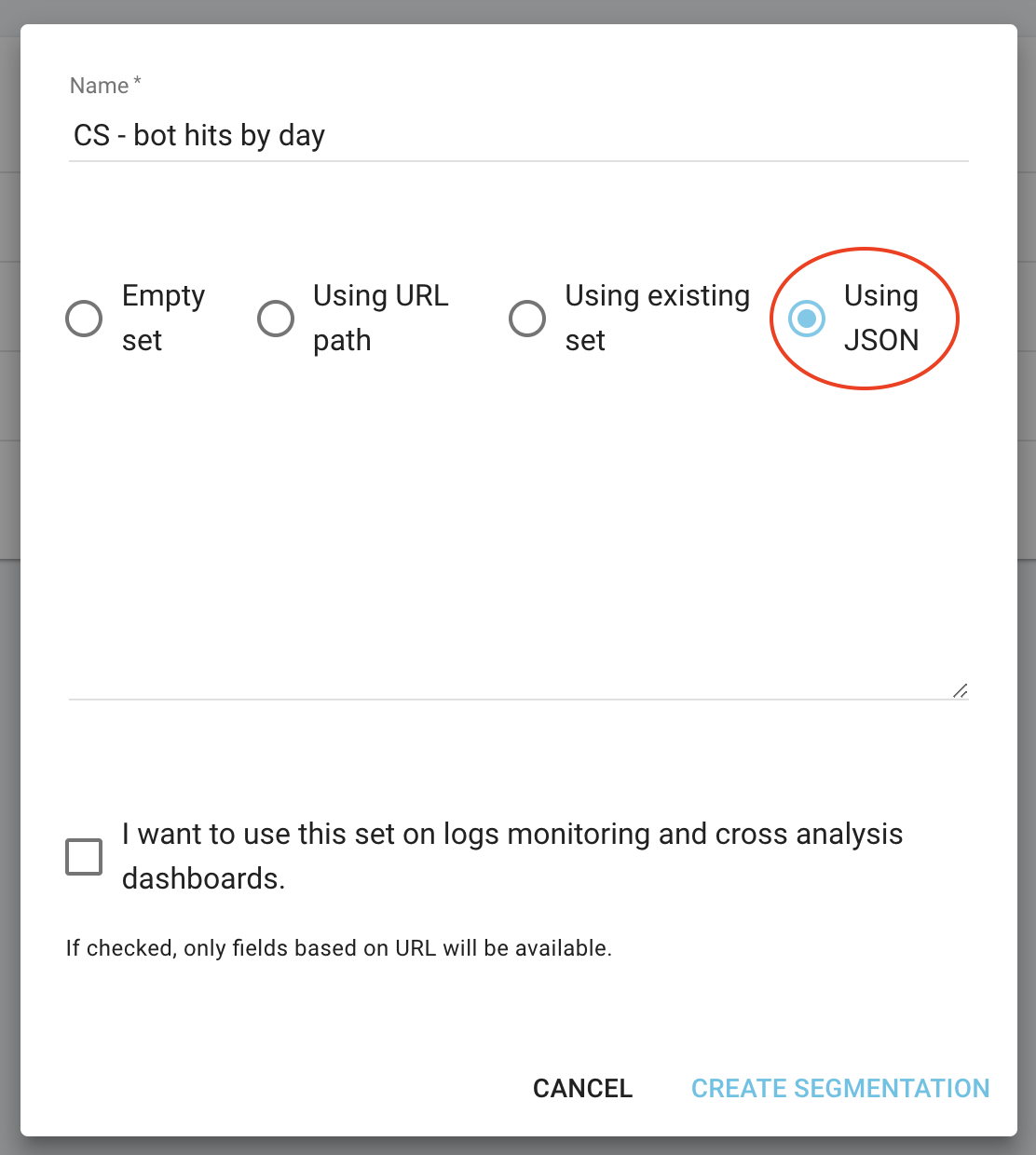

Utilisez l’import JSON en choisissant l’option “Using JSON” et copiez/collez les fichiers que vous avez téléchargés.

Maintenant vous pouvez échanger les segmentations en utilisant le menu en haut de chaque rapport.

Changement en direct de la segmentation dans tous les rapports Oncrawl

Cela va vous donner dans chacun des graphiques l’impact des métriques que vous analysez par rapport aux pages groupées par passages de bot ou de visites SEO.

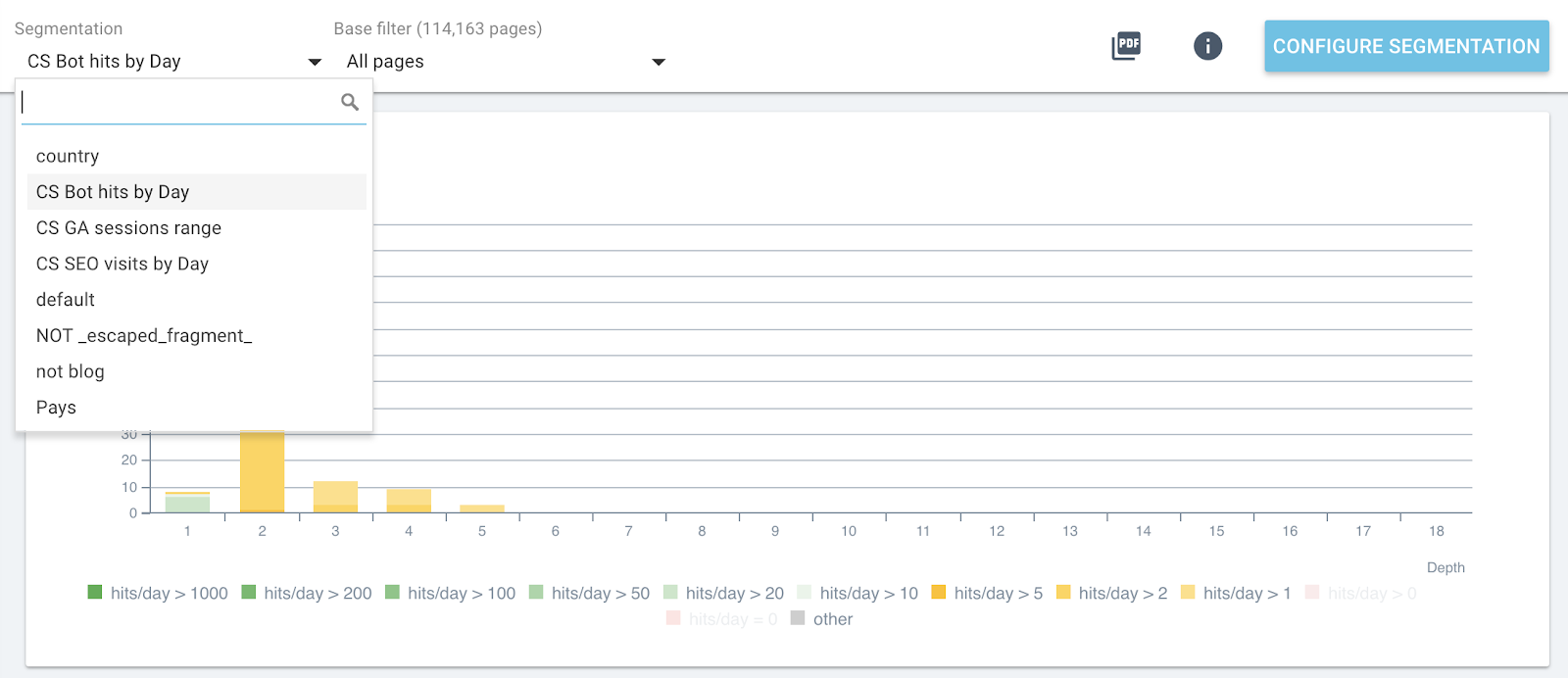

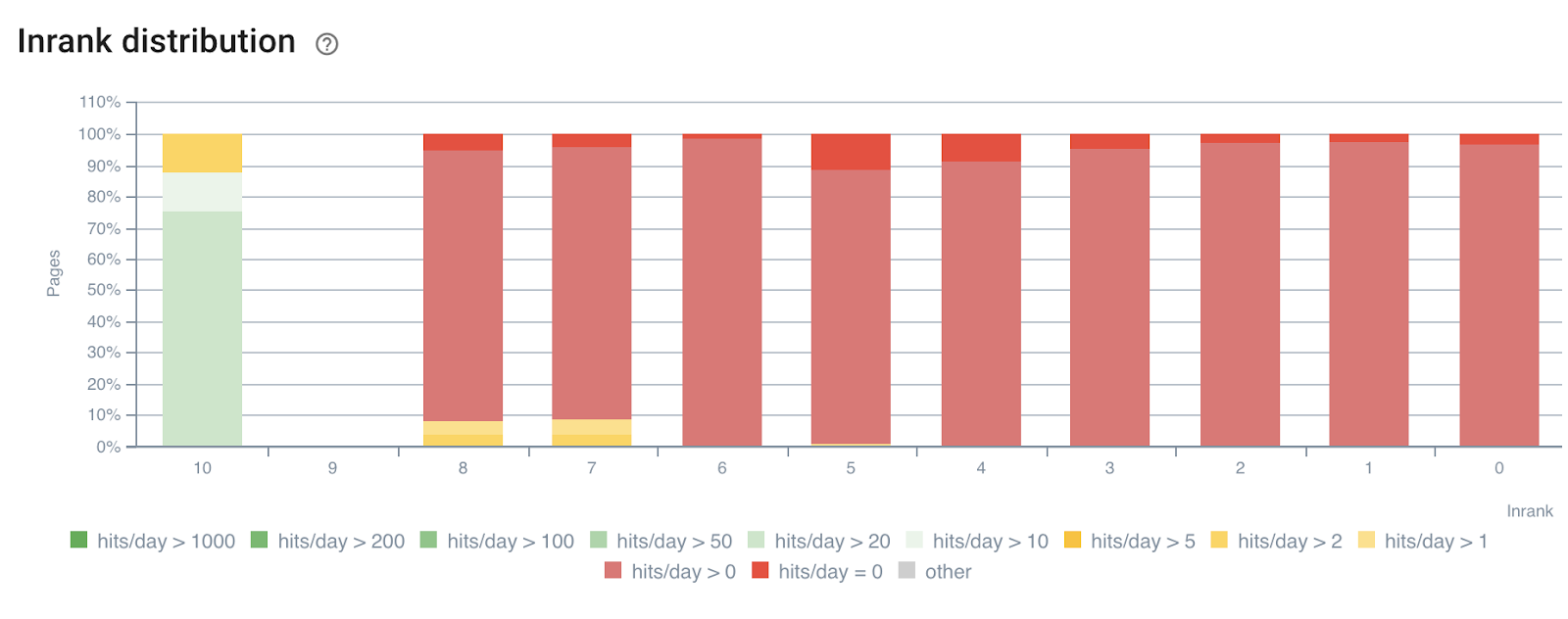

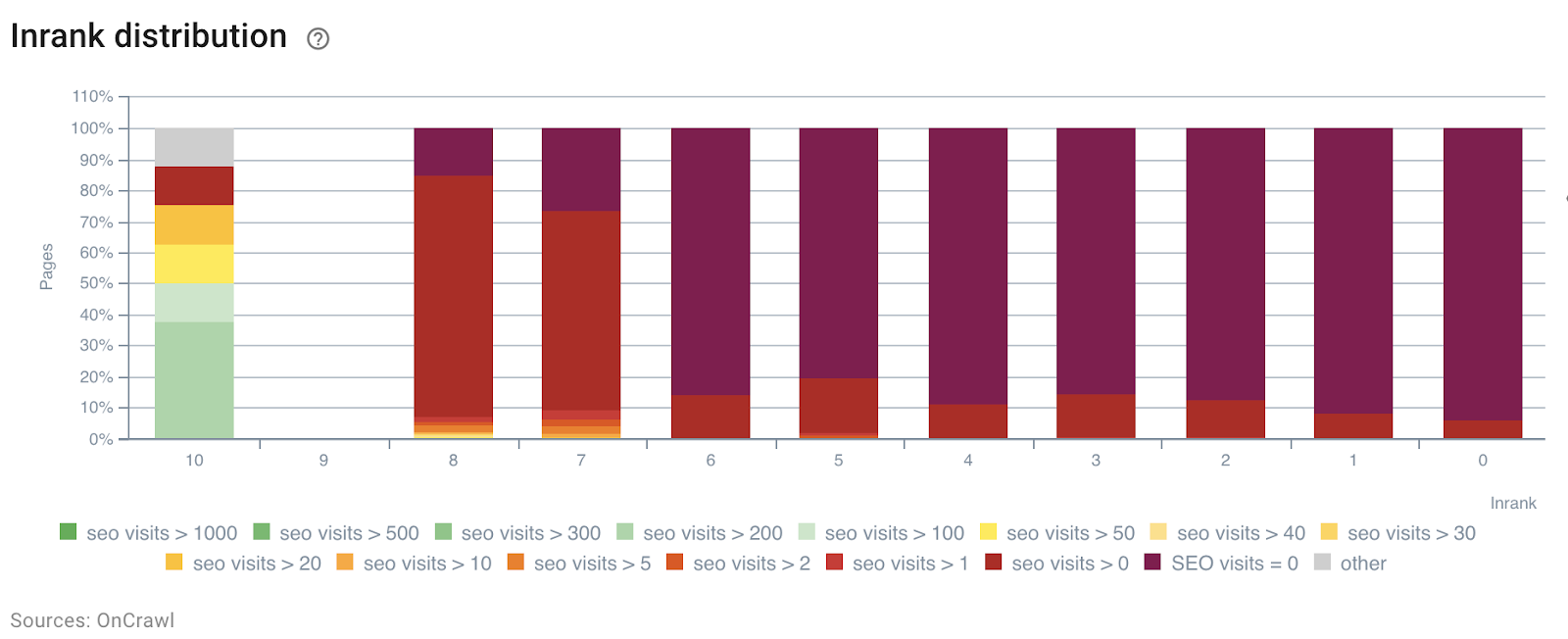

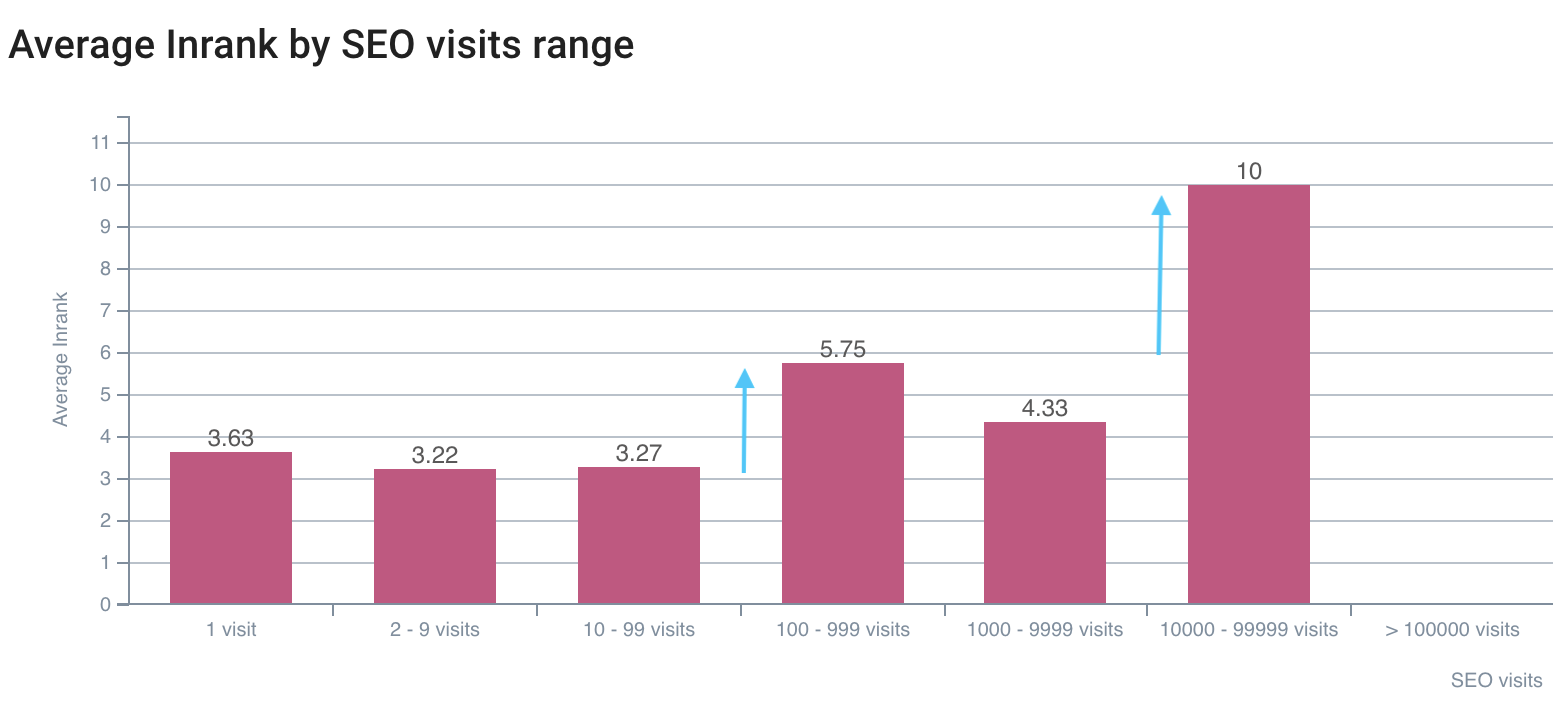

Dans l’exemple suivant, nous avons utilisé ces segments pour comprendre l’impact de la popularité interne – l’InRank- basée sur le pouvoir des liens par profondeur. De plus, les passages de bot et les visites SEO sont corrélés sur le même axe.

Distribution de l’InRank par passages de bot par jour

Distribution de l’InRank par visites SEO par jour

La profondeur (le nombre de clics depuis la page d’accueil) a clairement un impact sur les passages de bots et sur les visites SEO.

De la même manière, chaque groupe de page peut être sélectionné indépendamment pour mettre en avant les données depuis les pages les plus visitées par les bots ou les utilisateurs.

Cela permet de détecter rapidement les pages qui pourraient générer de meilleures performances si elles étaient optimisées, en modifiant le nombre de mots de la page, la profondeur ou le nombre de liens entrants par exemple.

Choisissez simplement la bonne segmentation et le groupe de pages que vous voulez analyser.

Distribution des mots dans la page pour le groupe contenant 0 passage de bot par jour

4# Déterminez des valeurs limites pour maximiser le budget de crawl et les visites SEO

Pour aller plus loin, le rapport SEO Impact – une analyse combinant les données de crawl et de logs – peut détecter des valeurs limites qui aident à augmenter les visites SEO, la fréquence de crawl ou les pages découvertes.

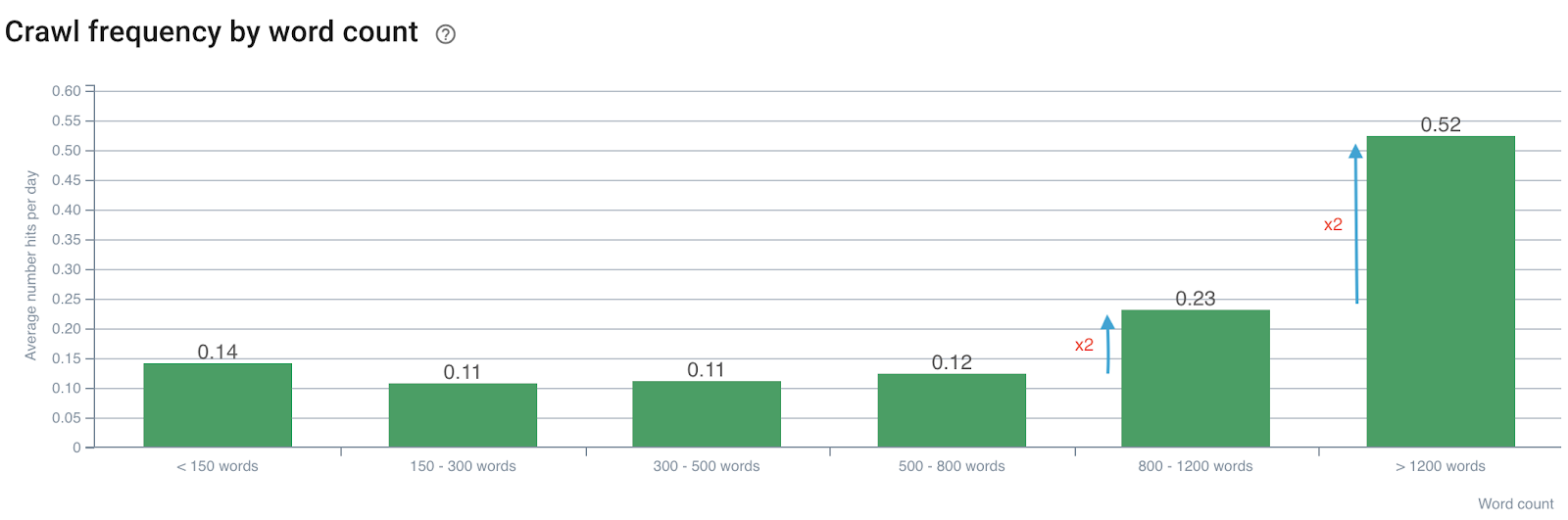

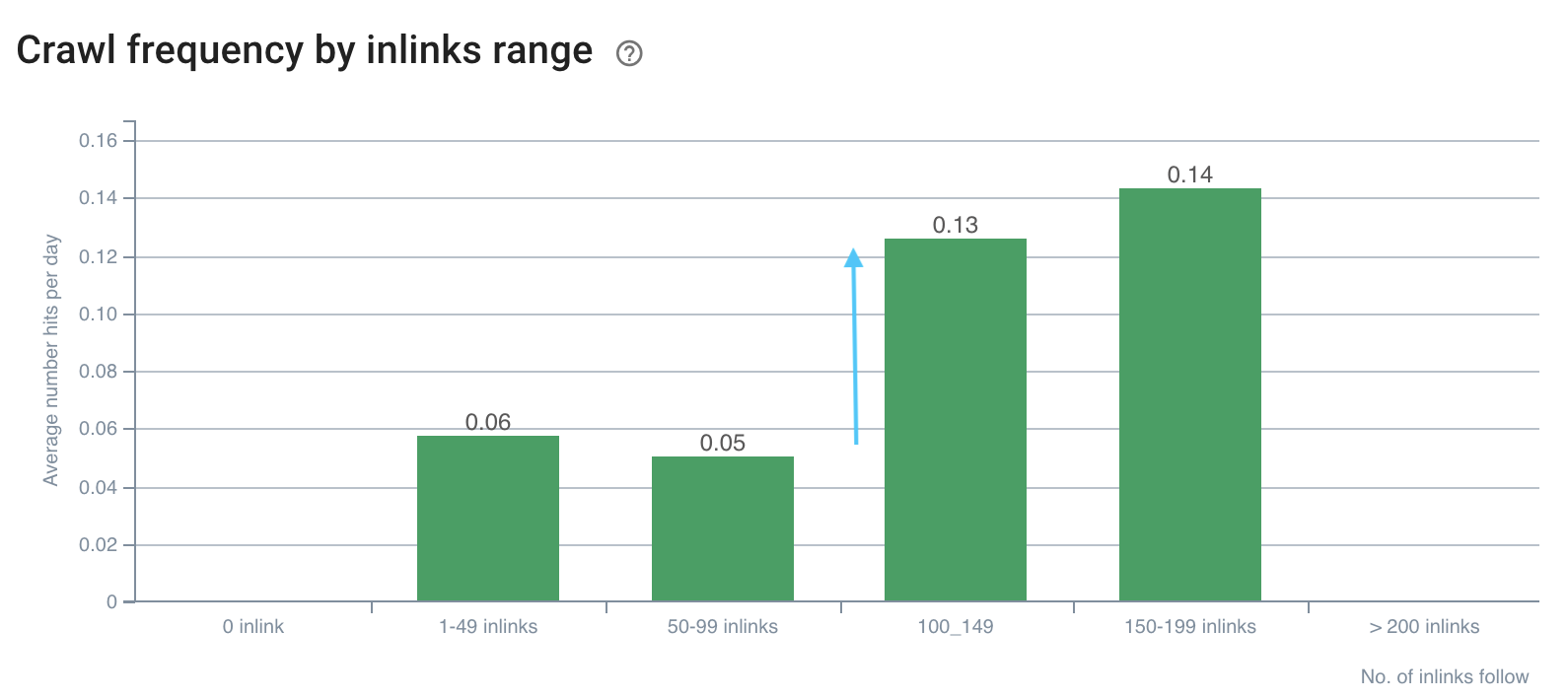

L’impact du nombre de mots sur la fréquence de crawl

Fréquence de crawl par nombre de mots

Nous remarquons que la fréquence de crawl est doublée lorsque le nombre de mots excède 800. Il est également doublé lorsque le nombre de mots dans la page dépasse les 1200 mots.

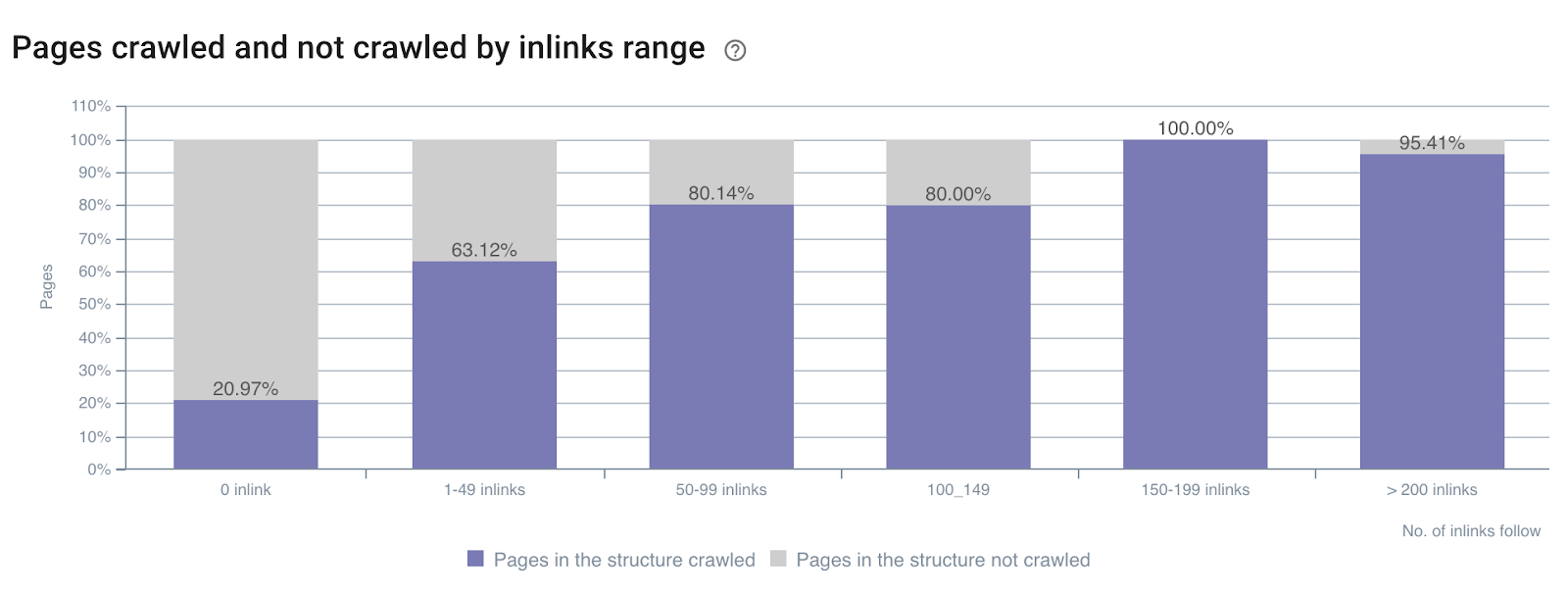

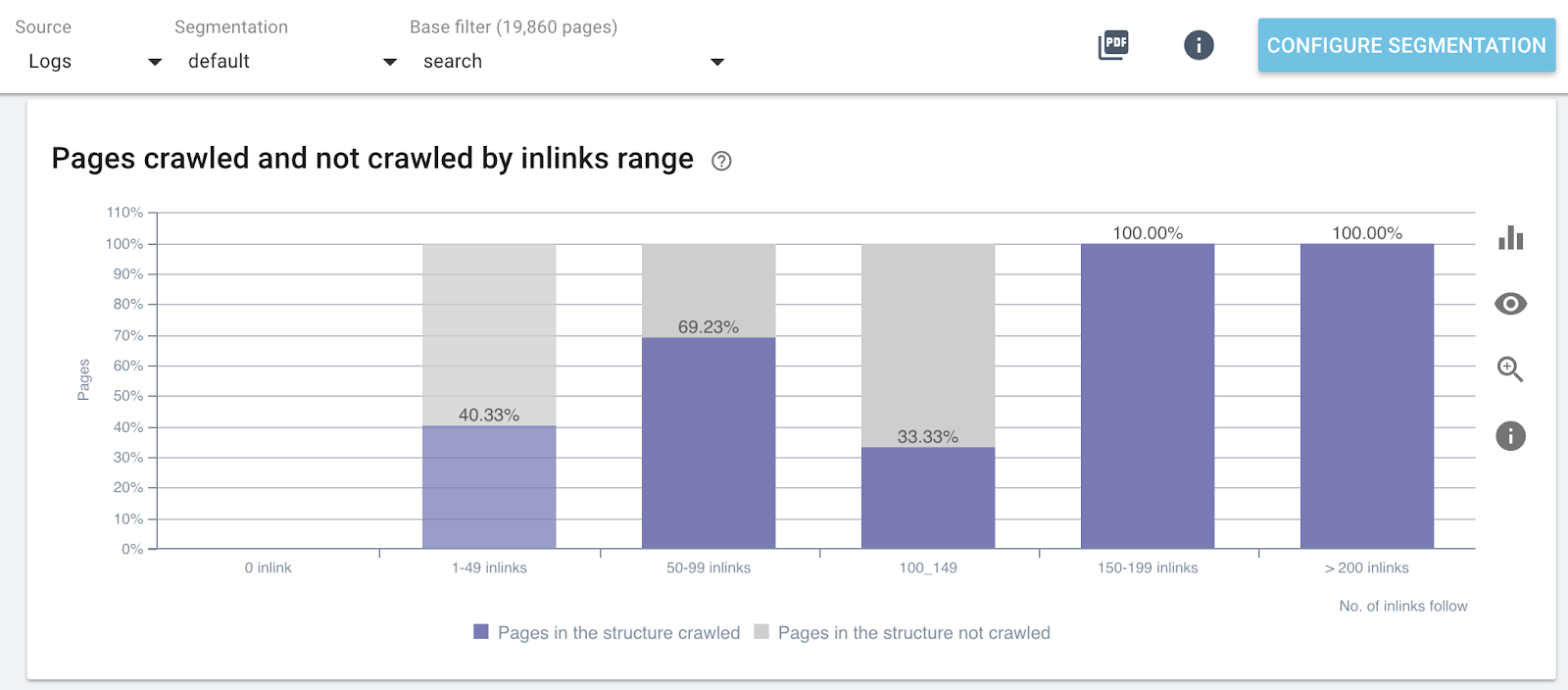

Impact du nombre de liens internes sur le ratio de crawl

Ratio de crawl par nombre de liens entrants à travers tout le site

Ratio de crawl par nombre de liens entrants sur des parties spécifiques du site web (Search Pages)

L’impact de la profondeur sur le taux de page active

Pages générant des visites SEO (ou non) par profondeur

Vous pouvez voir qu’utiliser les bonnes métriques de site pendant un crawl et que combiner les données de logs vous permet de détecter immédiatement ce dont les optimisations SEO ont besoin pour manipuler le crawl de Google et améliorer vos visites SEO.

5# Déterminez comment les facteurs de classement SEO influencent votre fréquence de crawl

Imaginez si vous pouviez savoir quelles valeurs cibler pour maximiser votre SEO ? C’est l’utilité même des analyses de données croisées ! Elle vous permet de déterminer précisément, pour chaque métrique, à quel niveau votre fréquence de crawl, votre taux de crawl ou votre activité sont maximisées.

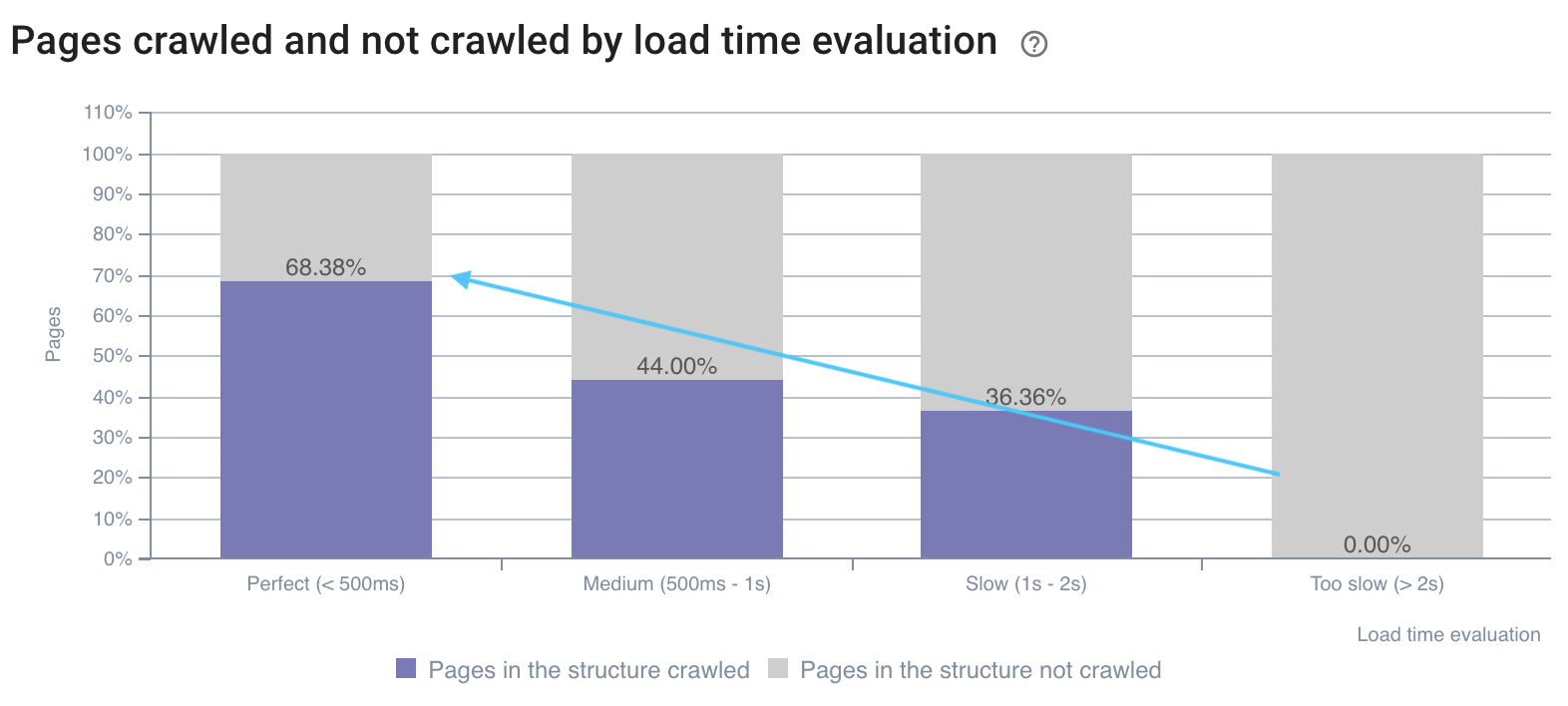

Nous voyons ci-dessous – sur l’exemple à propos du nombre de mots par page et la fréquence de crawl – qu’il y a des valeurs déclencheuses dans la fréquence de crawl. Ces écarts doivent être analysés et comparés pour chaque type de page afin de trouver des pics dans l’activité des bots ou des visites SEO.

Comme ceux présentés ci-dessous :

La fréquence de crawl indique un écart sur les liens internes supérieurs à 100

Le taux de crawl est meilleur sur les pages rapides

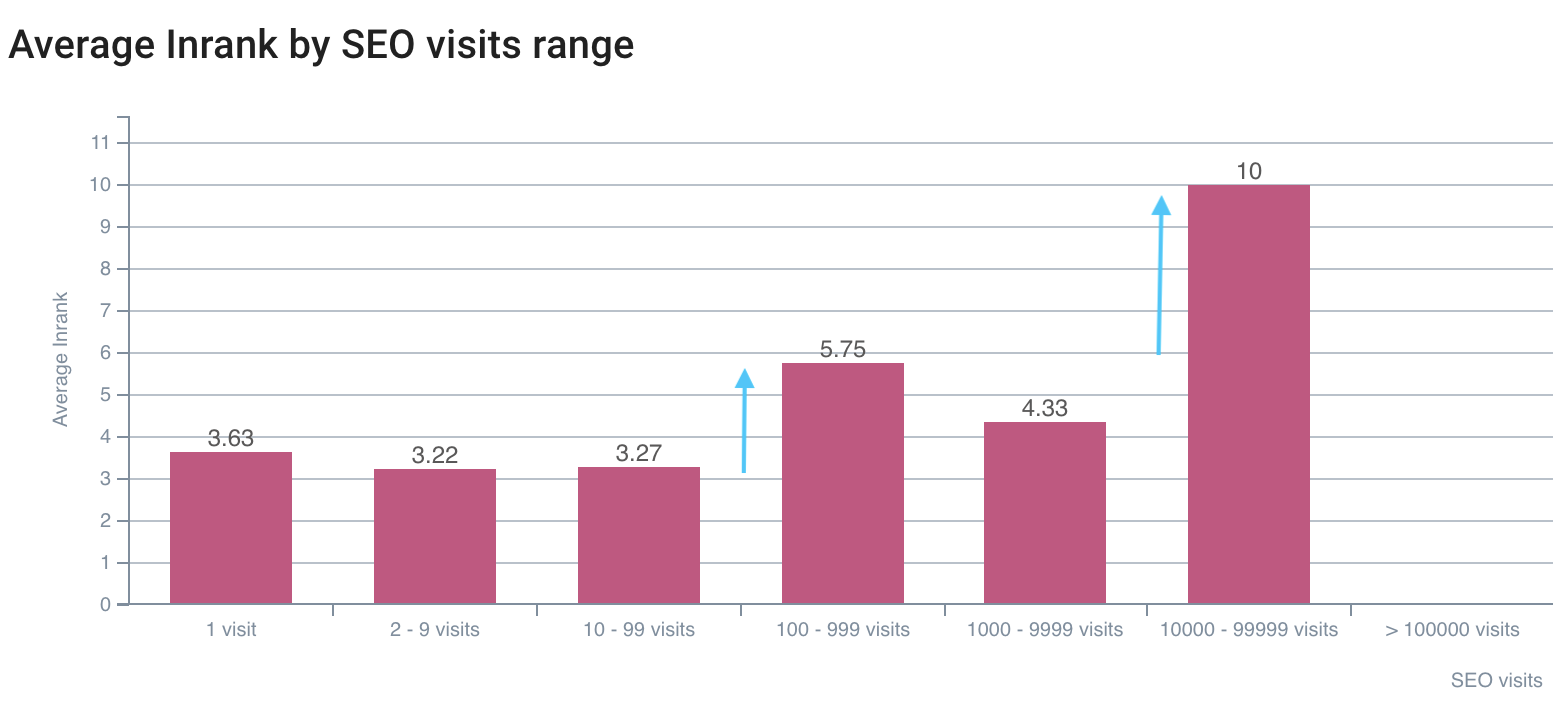

Le premier écart sur les visites SEO est sur l’InRank 5,75, le meilleur est sur l’InRank 10 (page d’accueil)

Combiner les données de crawl et de logs vous permet d’ouvrir la boîte noire de Google et de déterminer exactement l’impact de vos métriques sur le crawl des bots et les visites SEO. Lorsque vous implémentez vos optimisations sur ces analyses, vous pouvez améliorer votre SEO à chacune de vos sorties. Cet usage avancé est durable dans le temps, car vous pouvez détecter les nouvelles valeurs à atteindre pour chacune des analyses de données croisées.

Avez-vous d’autres astuces concernant les analyses de données croisées que vous aimeriez partager ?