Le SEO implique, la plupart du temps, de travailler avec une grande quantité de données. Un seul site web peut avoir jusqu’à des milliers de sous-pages, de mots clés et de liens internes à gérer. Si ce site opère dans un secteur concurrentiel, il devra alors intégrer des liens externes provenant de milliers de domaines.

Pensez à ce qui se passe si vous optimisez plus d’un site web. La quantité de données augmente de façon exponentielle : on peut dire que l’on se retrouve avec de la véritable Big Data.

Maintenant, ajoutons au mélange la variabilité de l’algorithme de Google, les actions imprévues de vos concurrents et les backlinks qui disparaissent. Comment gérer toutes ces données ?

Avec l’évolution du secteur de référencement et la multiplication des informations à suivre, la réalisation régulière d’audits complets de sites appartient de plus en plus au passé.

Le temps et les ressources étant limités, les audits fréquents ont cédé la place au monitoring des sites, un processus désormais intégré dans un flux de travail plus automatisé. La différence entre l’audit et le monitoring est qu’avec l’audit, vous devez trier les informations à la main pour déterminer où votre site n’est pas performant ou s’il y a des erreurs à corriger. Avec le monitoring, ces informations vous sont fournies directement, ce qui vous permet de gagner du temps et de créer un processus plus efficace.

Photo de Luke Chesser sur Unsplash

Le monitoring

Le marché n’aime pas que rien ne se passe, et ce n’est pas différent dans l’industrie du SEO. Toutes les caractéristiques et tous les indicateurs pertinents du point de vue du SEO peuvent être monitorés grâce à l’application d’outils spécialisés.

Malheureusement, il n’existe pas d’outil unique permettant de tout monitorer. Cependant, avec l’aide de quelques logiciels, vous pouvez suivre ce qui est important. Vous pouvez également combiner les données provenant de plusieurs sources, mais nous y reviendrons plus tard. Pour l’essentiel, les outils de monitoring vous permettent de recevoir les informations les plus importantes par le biais de rapports et d’alertes.

[Étude de cas] Suivre et optimiser la refonte d’un site web suite à une pénalité

Les rapports

Les rapports vous permettent d’analyser la variabilité des valeurs individuelles dans le temps et ils vous permettent de démontrer la valeur de vos efforts de SEO. Aussi importants soient-ils, votre valeur ajoutée en tant que SEO réside dans l’élaboration et la mise en œuvre d’une stratégie, et pas nécessairement dans la création des rapports.

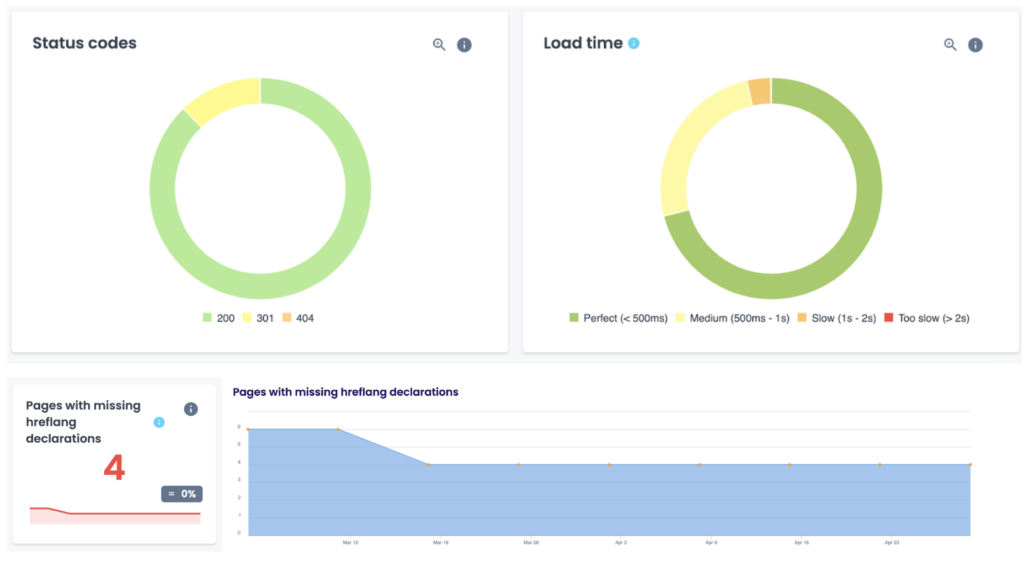

Des plateformes comme Oncrawl peuvent vous aider à produire des rapports personnalisés pour suivre l’état de santé de votre site, gérer les migrations de sites ou surveiller le trafic et le comportement des robots des moteurs de recherche. Vous trouverez ci-dessous quelques-uns des rapports spécifiques que vous pouvez trouver dans Oncrawl :

Les tendances pour un indicateur ou un KPI donné

Suivez et signalez les métriques qui comptent pour votre entreprise et comment elles varient dans le temps, qu’il s’agisse de la croissance des backlinks, du trafic organique, des codes de statut ou du contenu dupliqué. Vous pouvez sélectionner les indicateurs que vous souhaitez suivre et personnaliser les rapports de votre tableau de bord.

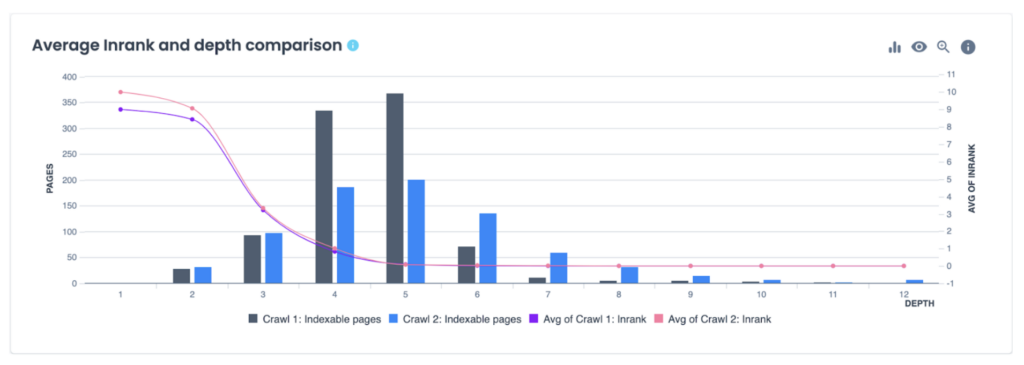

Une comparaison à deux moments donnés

Une comparaison à deux moments donnés

Un crawl over crawl vous permet de comparer les résultats de deux crawls pour vous montrer l’impact des changements apportés à votre site. Il peut être extrêmement utile pour suivre les changements au fil du temps, pour les migrations de sites ou pour le monitoring des modifications du site.

Les rapports agrégés

Pour assurer un monitoring complet du SEO on-page et off-page ainsi que de l’infrastructure de votre site, il est bénéfique d’utiliser plusieurs outils (outils que nous examinerons plus en détail ci-dessous). En configurant des alertes dans chacun des outils que vous avez choisis, vous vous assurez de ne pas manquer des changements importants sur votre site web.

Mais qu’en est-il des rapports ? Se connecter à plusieurs applications différentes jour après jour et comparer les données dans des fenêtres distinctes peut s’avérer extrêmement fastidieux. Heureusement, la plupart des applications de monitoring partagent leurs données via une API — et vous pouvez combiner, ou agréger, plusieurs sources de données dans un format de tableau de bord.

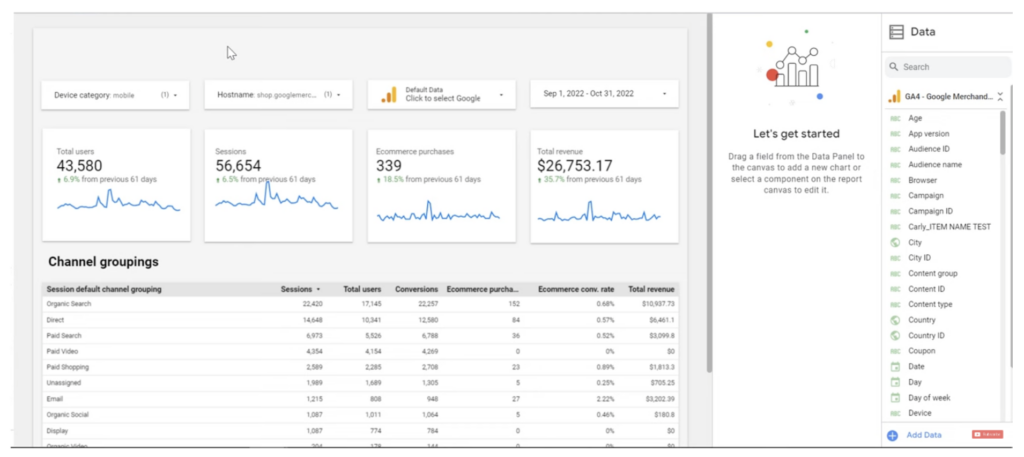

L’un des endroits les plus courants pour agréger des données est Google Looker Studio.

Les alertes

Les alertes sont importantes pour le monitoring car elles vous informent immédiatement de tout changement significatif apporté aux fonctionnalités et indicateurs que vous avez sélectionnés. Rester à jour sur les changements qui peuvent avoir un impact sur vos positionnements SERP ou sur l’expérience de vos clients est crucial pour votre succès en matière de SEO.

L’importance des seuils d’alerte

Comme votre entreprise et votre site Web sont uniques, les paramètres que vous choisissez de monitorer le seront également, ainsi que la sensibilité de l’alerte. Les seuils vous permettent d’ajuster la sensibilité d’une alerte. Par exemple, vous souhaiterez peut-être être alerté si plus d’un certain nombre de vos pages clés présentent des problèmes de vitesse de chargement, alors qu’une seule page se chargeant plus lentement que d’habitude n’est peut-être pas un motif d’inquiétude.

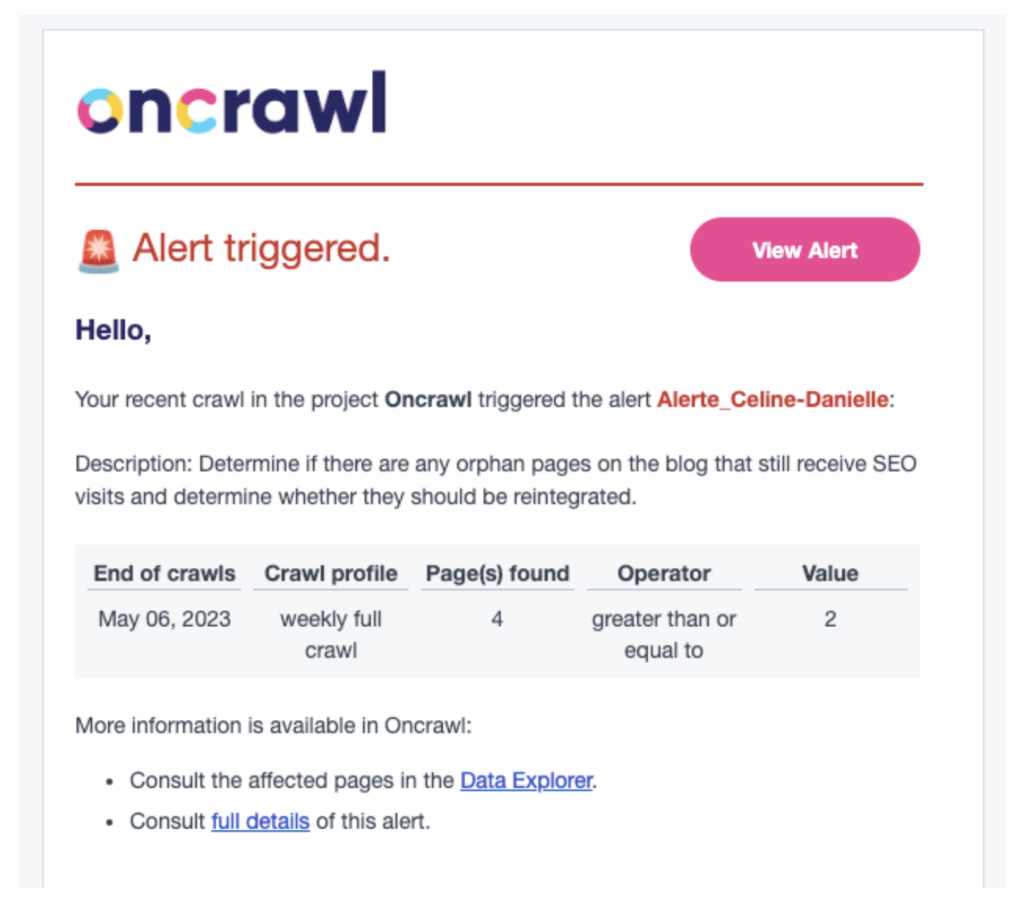

Si vous utilisez Oncrawl, les alertes dans l’application se déclenchent en fonction de conditions entièrement personnalisables. Vous avez la main pour choisir ce que vous surveillez et pour définir un seuil qui ajuste la sensibilité des alertes comme vous en avez besoin.

Qui peut recevoir des alertes ?

Envoyez des alertes aux bonnes personnes, même s’il y en a plusieurs qui doivent être informées. Quelle que soit la taille de votre équipe, les principales parties prenantes, voire les développeurs, doivent être tenus informés de ce qui se passe sur votre site web.

Les canaux d’alerte

Les alertes peuvent être envoyées via plusieurs canaux, tels que des outils de communication comme Slack ou Microsoft Teams, afin que les groupes reçoivent une seule notification.

La fréquence des alertes

La fréquence de vos alertes peut faire une grande différence dans votre capacité à réagir à temps ou non. Affinez la fréquence du monitoring que vous mettez en place ; vous pourriez vouloir recevoir des alertes deux fois par jour, tous les jours, toutes les semaines… selon ce qui est logique pour les KPIs que vous suivez, pour votre équipe et pour vos objectifs.

Qu’est-ce qui peut (et doit) faire l’objet d’un monitoring en SEO ?

Infrastructure du site web

Le fait que vous soyez propriétaire d’un site web (ou que votre client en soit propriétaire) et que vous ayez accès au CMS et à toutes les configurations ne signifie pas que vous sachiez tout ce qu’il y a à savoir à ce sujet. Il est très facile pour vous de passer à côté de problèmes importants qui ont un impact sur bien plus que le SEO.

La disponibilité (temps de fonctionnement)

Si le site web ne fonctionne pas, vous savez ce qui se passe : il ne convertit personne et peut même décourager un utilisateur de choisir une marque donnée. Si les problèmes persistent, ils peuvent même entraîner une désindexation.

Le bon fonctionnement

Un problème dans une fonction importante d’un site web est un tueur silencieux de conversion. Supposons par exemple que votre site web soit opérationnel, mais qu’il soit impossible de passer une commande parce que le bouton de la dernière étape du processus d’achat ne fonctionne pas. Certes, vous en verrez les effets sous la forme d’une baisse des ventes, mais il est préférable de détecter un problème et de le résoudre avant de commencer à perdre de l’argent.

L’expiration du domaine et du certificat SSL

Comme nous le savons tous, les bureaux d’enregistrement de noms de domaine et les émetteurs de certificats SSL sont très heureux de vous rappeler que vous devez renouveler votre abonnement. Cependant, il peut se passer des choses, surtout si vous utilisez plusieurs boîtes mail et alias. Il peut arriver que vous manquiez une telle notification : un rappel supplémentaire de la part d’une ressource de monitoring externe ne fera de mal à personne.

Une présence sur les blacklists

Un écran d’avertissement rouge affiché par le navigateur au lieu du site web lui-même est une situation que tout le monde préférerait éviter. Cela signifie le plus souvent qu’un site web a été infecté par un logiciel malveillant et qu’il est devenu une menace pour les utilisateurs. Dans une telle situation, vous devez réagir immédiatement afin que le moins d’utilisateurs possible soient confrontés à un tel message.

Les bloqueurs de robots

Si vous n’en avez jamais fait l’expérience, n’hésitez pas à me jeter la première pierre. Imaginez que la version préliminaire d’un site web soit transférée en production, avec le fichier robots.txt comprenant le blocage des robots des moteurs de recherche. Ou peut-être la balise X-Robots dans l’en-tête HTTP, qui est invisible à première vue. Il est préférable de détecter une telle erreur avant que Google ne mette à jour l’indexation conformément à notre propre « demande ».

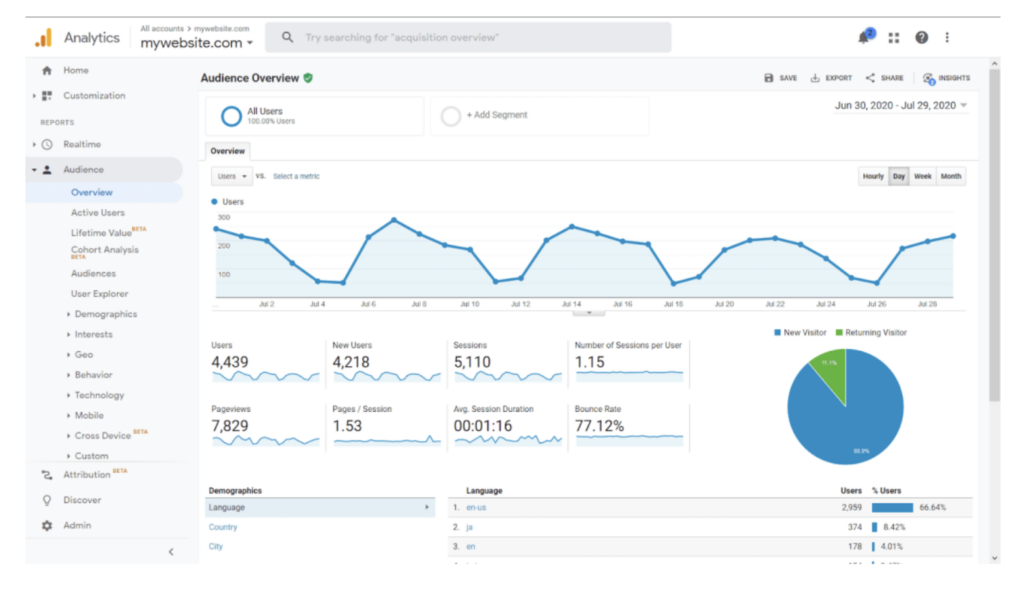

Google Analytics

Le monitoring du SEO technique on-site

Le SEO technique doit être le fruit d’un travail de collaboration ; repérez les signaux d’alerte lorsque d’autres personnes travaillent sur votre site web et évitez les régressions.

Les pages renvoyant un status code 404

Une erreur 404 indique que le serveur n’a pas pu trouver du contenu correspondant à ce qui était demandé. Cela se produit généralement lorsque le contenu d’un site a été supprimé ou déplacé vers une autre URL. Les liens brisés peuvent nuire à l’expérience de l’utilisateur et créer un taux d’erreur élevé pour votre site s’ils sont trop nombreux.

Les erreurs 5xx

Une erreur 5xx est un code qui apparaît sur les navigateurs Internet lorsque le serveur n’a pas réussi à répondre à une demande. Il existe différents codes de serveur 5xx qui identifient des problèmes spécifiques, par exemple 500 = Internal Server Error (erreur interne du serveur). Il est essentiel de rectifier rapidement les erreurs 5xx, car elles peuvent nuire au positionnement d’une page ou la faire disparaître de l’indexation.

Une page d’accueil en noindex

Une balise noindex est une directive de page qui indique aux moteurs de recherche de ne pas indexer une page particulière. Si les moteurs de recherche ne peuvent pas indexer votre page d’accueil, celle-ci ne sera pas positionnée dans les SERPs. Si personne ne peut trouver votre site dans les résultats de recherche, ce n’est pas bon pour les affaires.

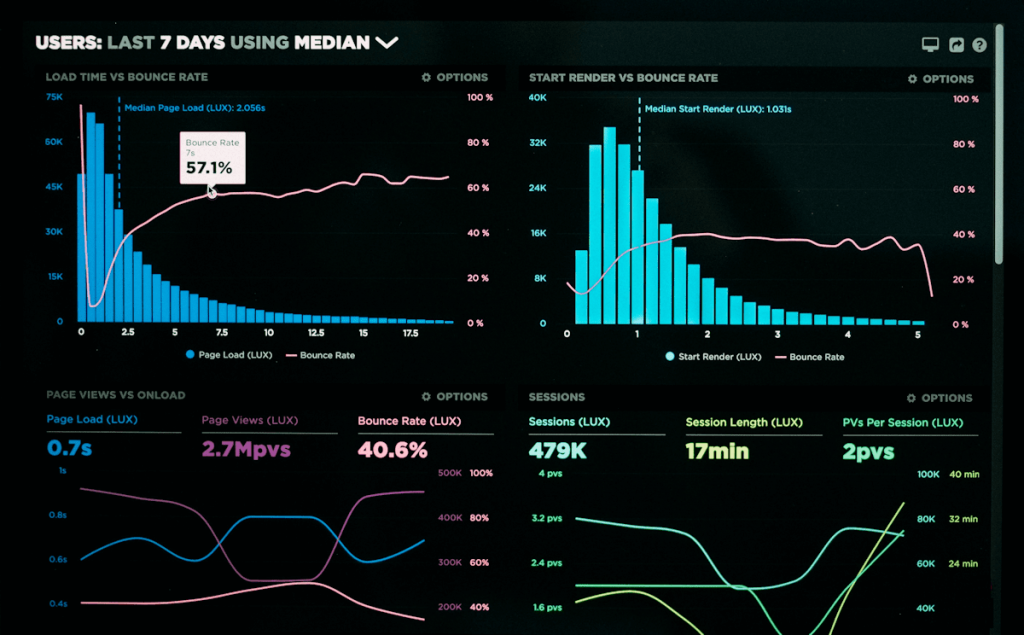

La vitesse de chargement

Après avoir optimisé la vitesse d’un site web, vous ne pouvez pas l’oublier et passer à autre chose. En effet, il suffirait qu’une personne publie un énorme bitmap sur la page principale pour ruiner tout votre travail. Vous devez détecter rapidement de telles situations afin d’y remédier le plus tôt possible.

Le trafic organique sur le site web

Vous êtes probablement déjà attentif au flux de trafic organique, en particulier au taux de rebond et au taux de conversion. Cependant, en faites-vous un monitoring régulier ?

Les pages orphelines

Les pages qui existent ou qui sont indexées, mais qui ne sont pas intégrées dans la structure du site web, envoient des signaux contradictoires aux moteurs de recherche quant à leur importance. Cela leur fait souvent rater des opportunités de positionnement et de trafic. L’existence ou la création de pages orphelines est un élément clé à surveiller pour de nombreux spécialistes SEO.

Le monitoring off-site

Vous observez probablement les résultats externes de vos actions, mais l’observation n’est pas la même chose que le monitoring. Une bonne pratique consiste à vérifier régulièrement les rapports et à recevoir des alertes à des moments clés – au lieu de regarder les résultats en permanence. Quelles sont les mesures que vous devriez surveiller ?

La position dans les SERPs

La base pour déterminer les effets des activités de SEO, et souvent — du montant de la rémunération pour les services de SEO. Il est très difficile de suivre cette évolution par soi-même, non pas tant parce que de nombreuses requêtes répétitives sont bloquées par Google, mais plutôt en raison de la personnalisation poussée des résultats de recherche et de l’apparition constante de nouveaux snippets qui modifient l’aspect des SERP.

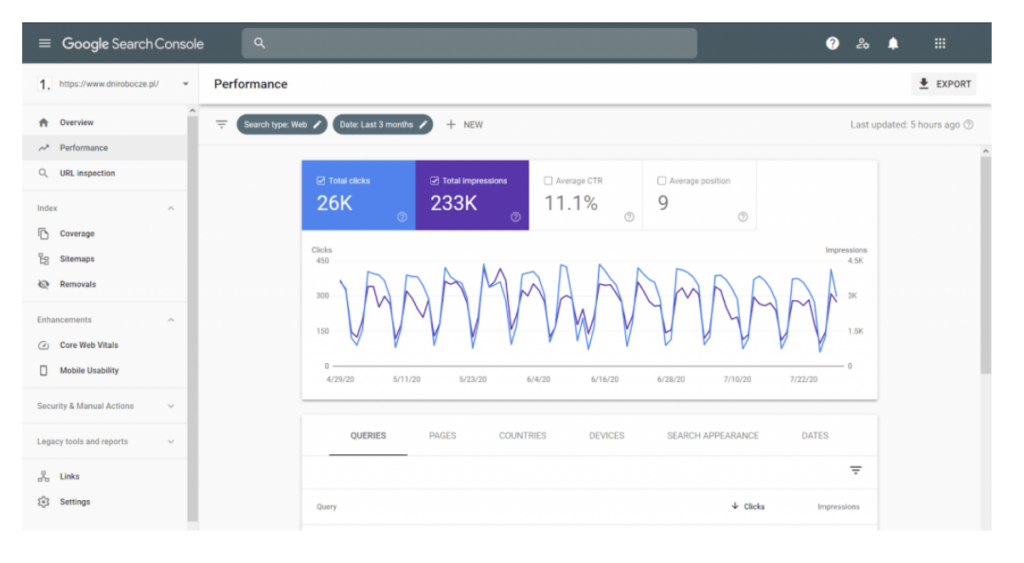

L’efficacité de Google

Le nombre de vues dans les SERPs, le CTR et les clics, la vitesse de crawl et les erreurs. Des données de première main, c’est-à-dire des données provenant directement de Google et de la Google Search Console.

L’autres indicateurs

Le Trust Flow (TF) ou le Citation Flow (CF) sont principalement utilisés pour déterminer la valeur des sites web en tant qu’emplacements de liens potentiels. Mais, dans ce cas, il est également intéressant de monitorer les performances du site web optimisé.

Les backlinks

La » monnaie » du SEO, résultat direct du marketing de contenu et de nombreuses autres activités. Certains valent leur pesant d’or, d’autres moins. La nécessité de monitorer les backlinks se manifeste à deux niveaux :

- Le général – numérique/qualitatif.

- Le détail – qui consiste à suivre les liens spécifiques acquis – s’ils n’ont pas été supprimés ou modifiés (par exemple en ajoutant l’attribut « nofollow »).

Google Search Console

Les outils

L’outil le plus important pour suivre les effets des activités SEO est la Google Search Console mentionnée plus haut. Malheureusement, il ne propose pas d’alertes configurables – notifiant, par exemple, une baisse des positions dans les SERP. Bien sûr, la GSC envoie différents types d’alertes, mais elle le fait de manière totalement indépendante.

Google Analytics est également très important – ou tout autre logiciel utilisé pour suivre le trafic et le comportement des utilisateurs sur le site web. Vous pouvez définir vos propres alertes et recevoir des notifications lorsque quelque chose d’inhabituel se produit au niveau du trafic sur votre site web.

Majestic est une source de données très précieuses concernant un site web optimisé pour le SEO (y compris les liens qui y mènent) qui dispose de sa propre indexation construite exactement de la même manière que l’index de Google.

Certaines plateformes de référencement avancées — comme Oncrawl par exemple — offrent un monitoring continu de la santé globale et du SEO technique d’un site web. Le service suit diverses métriques collectées par le crawl et l’analyse des logs. Le système d’alerte d’Oncrawl offre beaucoup de flexibilité et de personnalisation autour de la définition de métriques précises ou complexes, de seuils, de notifications et de la fréquence des alertes.

Le monitoring : une nécessité pour un SEO efficace ?

Avec autant de données à suivre, le monitoring est devenu un élément essentiel de toute stratégie SEO. Le monitoring est le moyen le plus efficace pour vous aider à déterminer ce qui fonctionne actuellement pour vous et ce que vous devez améliorer afin d’obtenir de meilleurs positionnements et d’optimiser l’expérience de l’utilisateur.

Il est important de prendre le temps de trouver la bonne combinaison d’outils pour surveiller votre site, mais vous devriez surveiller et utiliser des alertes pour les principaux éléments de l’infrastructure de votre site, les performances techniques du SEO et le SEO hors site. Travaillez plus intelligemment et recevez l’information directement.