L’ingestion de données d’Oncrawl est une nouvelle fonctionnalité qui vous laisse intégrer n’importe quel fichier CSV provenant d’autres outils ou d’exports tierces. Que ce soit des outils orientés SEO ou n’importe quel type de données pertinentes que vous voudriez ajouter à vos URLs dans Oncrawl, les possibilités sont illimitées. Des données issues d’Adwords, de CRMs, de Semrush ou de n’importe quel autre outil peuvent être intégrées.

L’ingestion de données d’Oncrawl vous permet d’ajouter de nouveaux champs à vos URLs, puis d’enrichir vos analyses SEO. Dans cet article, nous allons nous concentrer sur 5 cas pratiques pour optimiser votre SEO en utilisant l’ingestion de données.

Ainsi, vous pourrez utiliser les données pour :

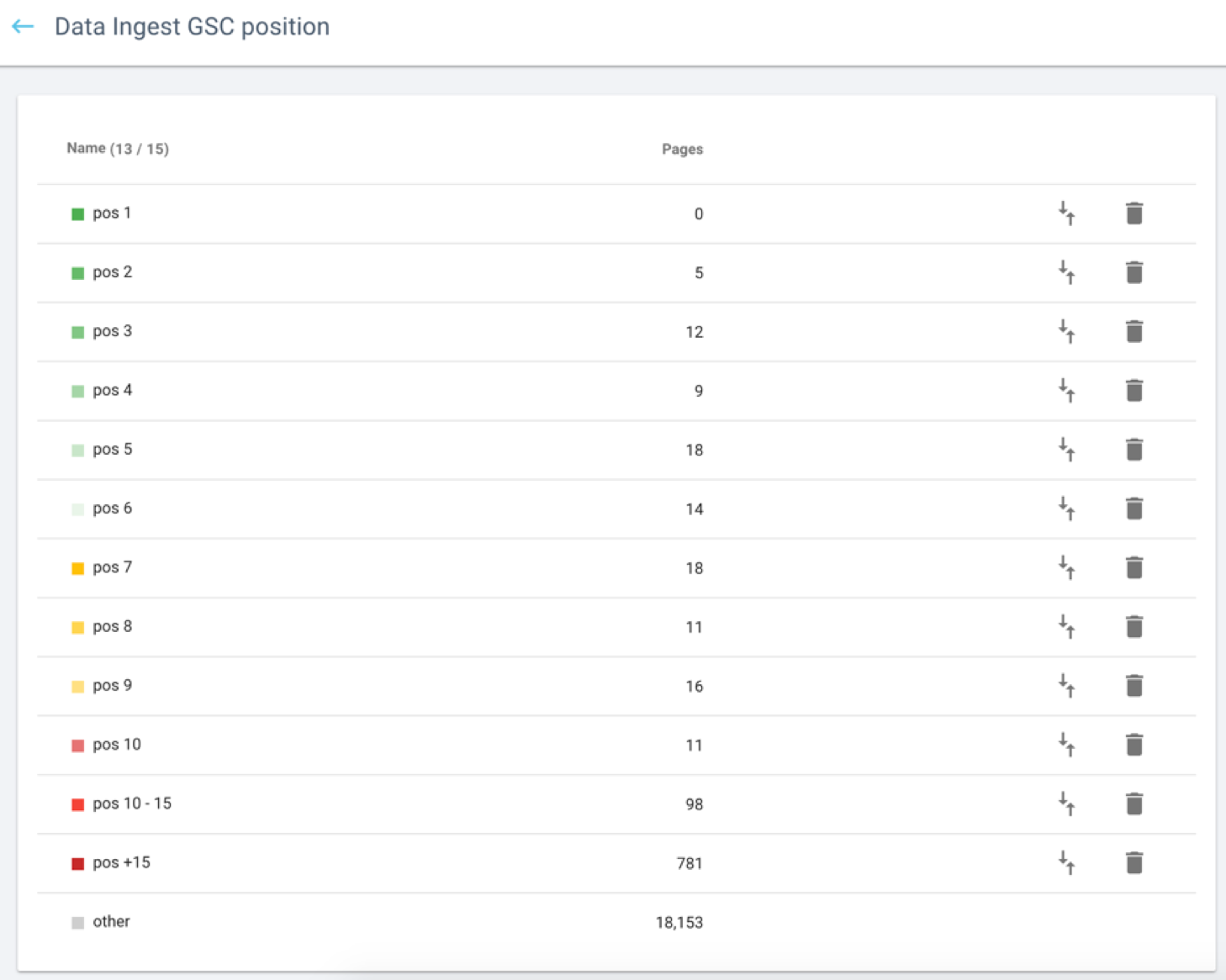

- Segmenter vos pages par positions, impressions, revenus, etc…

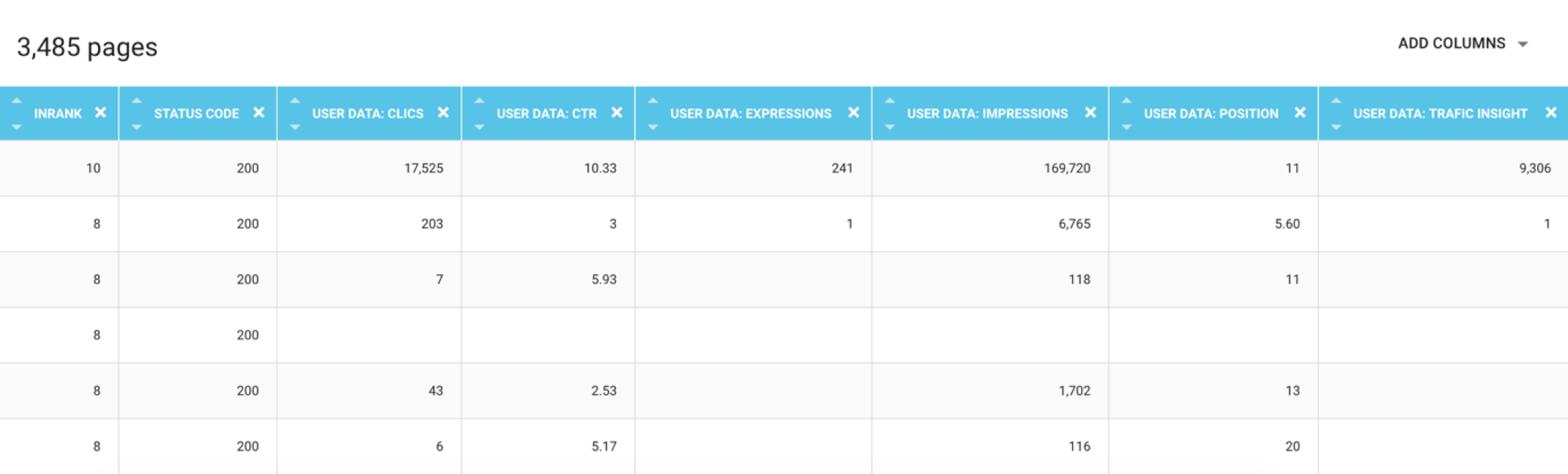

- Les utiliser dans le Data Explorer

- Ajouter des colonnes dans le Data Explorer et les exporter

Comment cela fonctionne ?

L’ingestion de données d’Oncrawl vous permet d’ajouter des champs personnalisés provenant d’un jeu de données tierces à toutes les URLs d’un rapport de crawl.

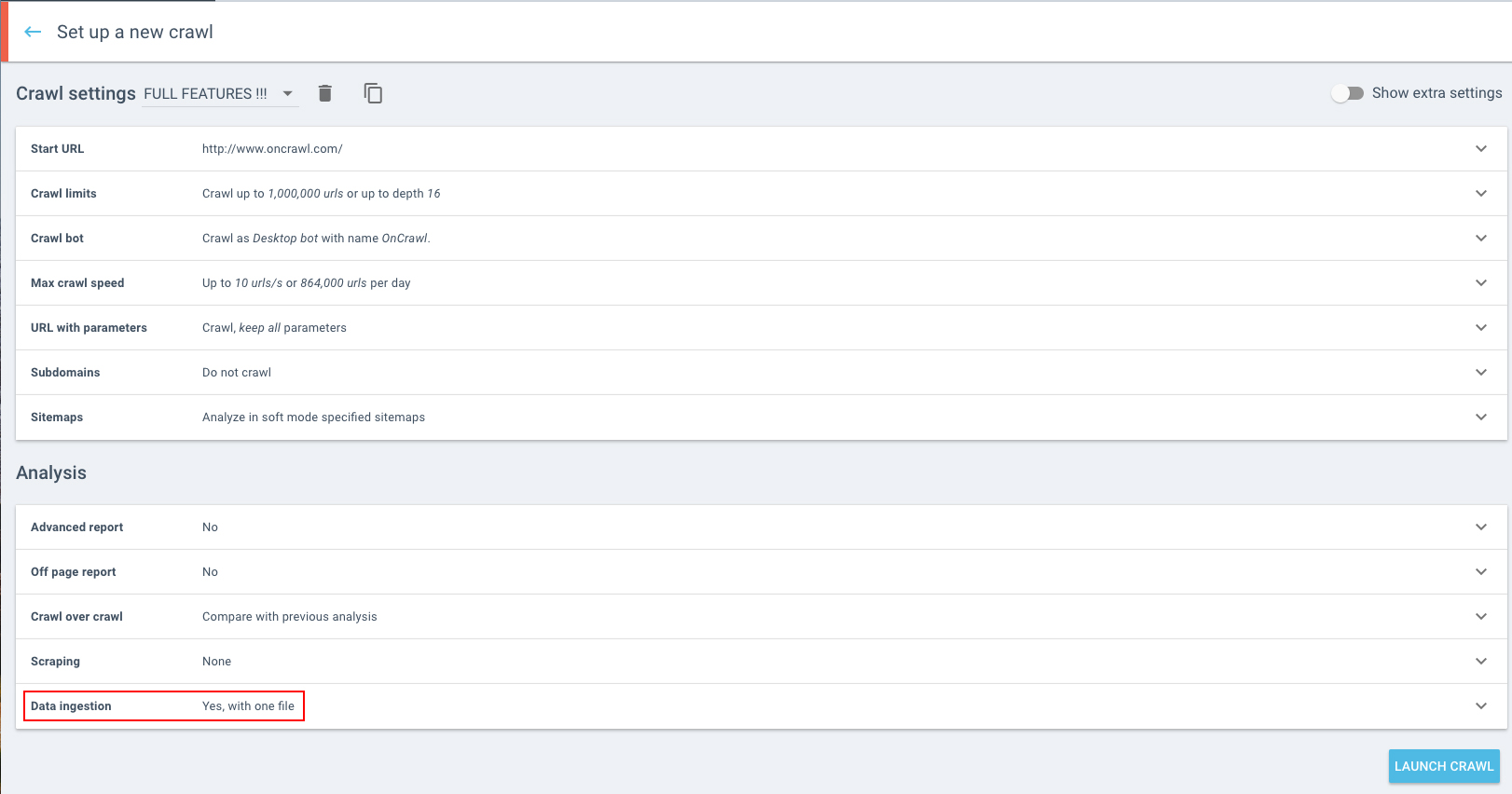

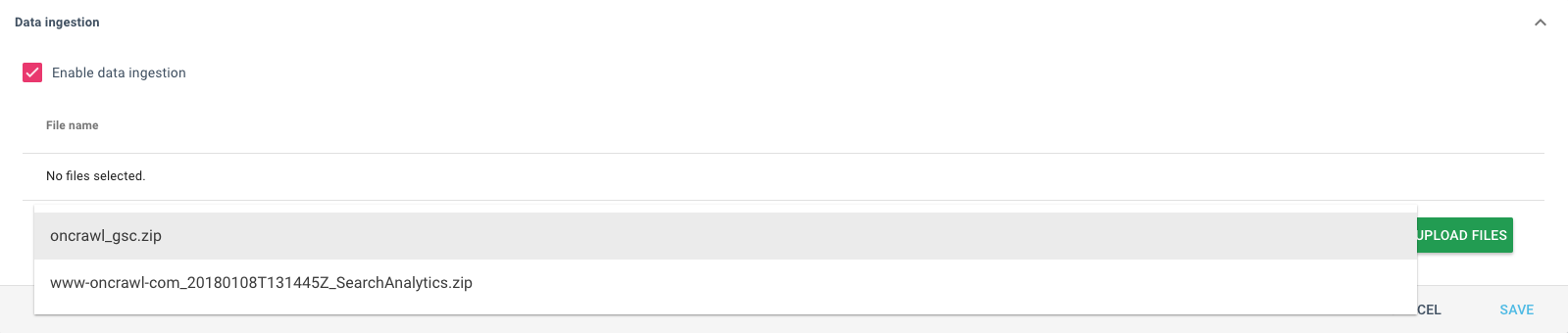

Avant de lancer un nouveau crawl, vous pouvez télécharger un ou plusieurs fichiers contenant les champs de données tierces que vous souhaitez ajouter à vos analyses. Revenez sur la page d’accueil de votre projet et sélectionnez “Launch a new crawl”. Puis, si vous avez activer cette option, cliquez sur “Data Ingestion” à la fin de votre section ‘Analysis’.

Cochez la case “Enable data ingestion” et téléchargez votre fichier .zip.

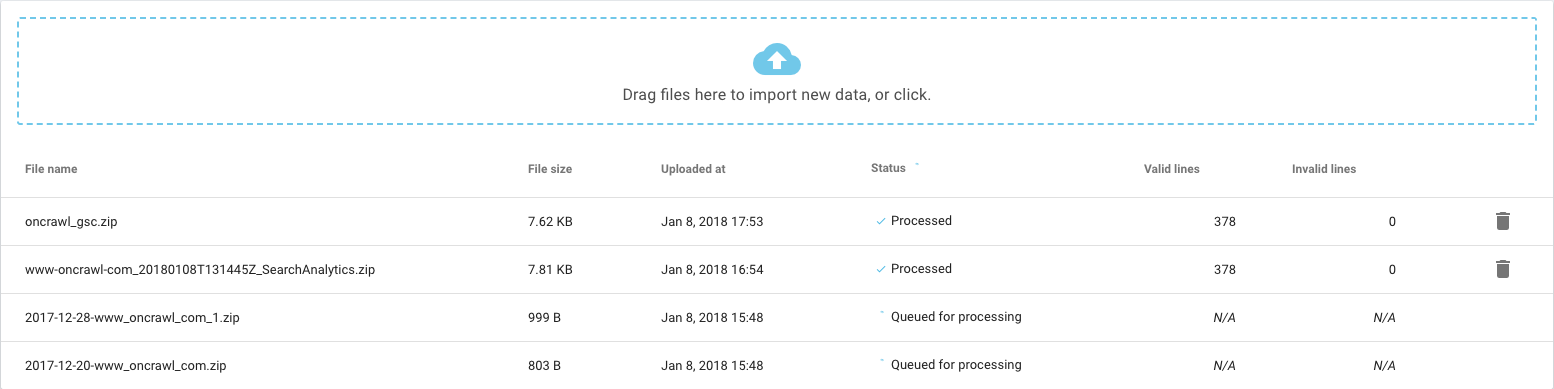

Ensuite, le fichier est traité et analysé. Vous pouvez suivre le nombre de lignes analysées et leurs statuts à tout moment.

À la fin du crawl, les nouvelles données sont fusionnées dans le champ URL appartenant au crawl. Il est très important de vérifier que le champ URL dans les données ingérées correspond bien aux URLs utilisées dans le rapport de crawl (Crawl report: les URLs récupérées par le oncrawlbot).

Pour en savoir plus à propos des formats de fichiers requis, n’hésitez pas à consulter notre tutoriel.

5 Quick Wins grâce à l’ingestion de données d’Oncrawl

1# Analysez le nombre d’expressions classées vs le nombre de mots par page

Pour cet exemple, nous avons utilisé Yooda Insight. Cette solution vous permet de facilement surveiller vos mots-clés et positions.

Entrez simplement l’URL du domaine, choisissez les pages qui se positionnent pour obtenir un rapport de vos expressions classées et une évaluation du trafic associé.

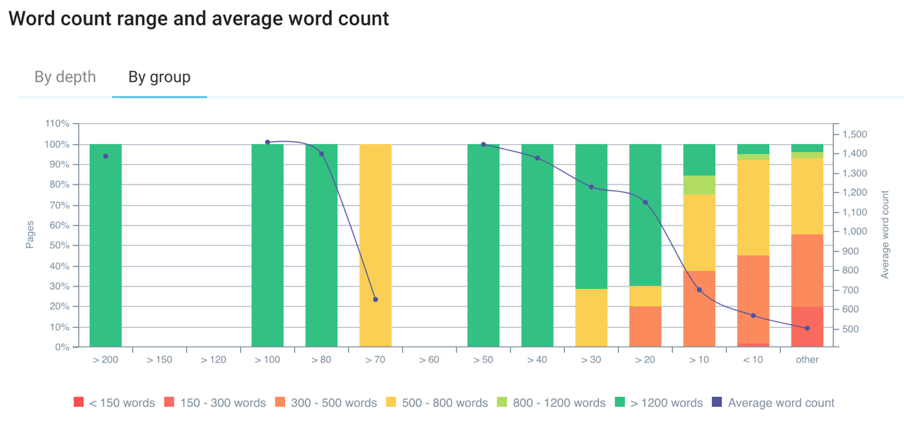

En créant une segmentation basée sur l’export du nombre d’expressions par “pages classées”, vous pouvez comprendre sur quelles pages vous devriez travailler en fonction du contenu.

Moins il y a de contenu sur une page, moins elle se positionne sur un large nombre d’expressions. Cette information est très intéressante pour savoir si vous devez ou non enrichir certaines de vos pages pour les positionner sur des expressions clés.

Pour chaque groupe, vous pouvez cliquer sur le graph pour accéder à plus de détails. Vous pouvez ainsi mettre en avant des pages avec moins de 10 positions et moins de 300 mots par exemple.

2# Comprendre l’impact des campagnes Adwords sur le trafic

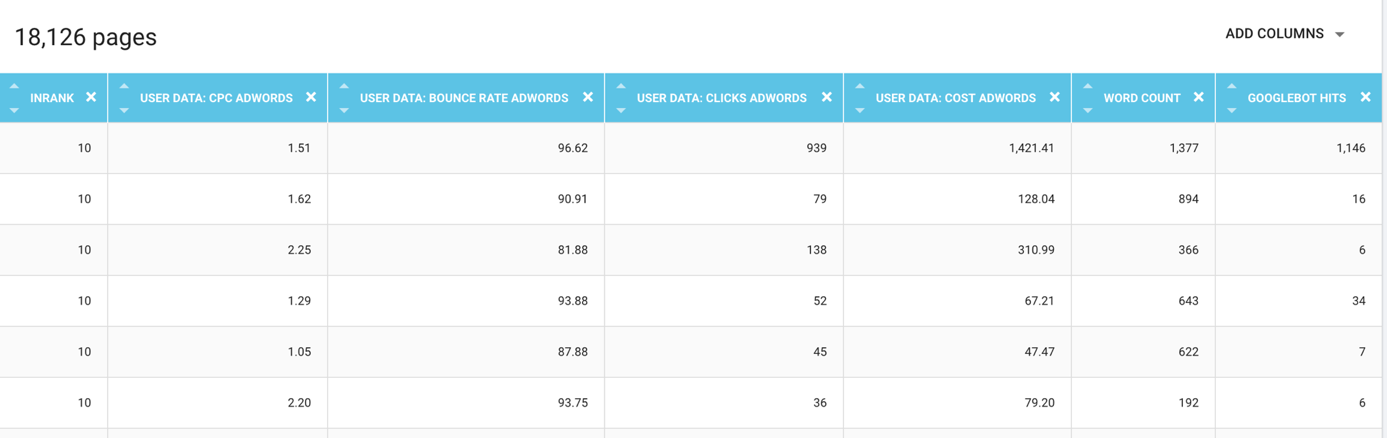

Vous pouvez ingérer des données d’Adwords pour comprendre quelle est la capacité de vos campagnes à générer du trafic ou bien même pour optimiser le coût d’URLs spécifiques.

Dans cet exemple, les URLs ont été cachées mais vous pouvez voir le coût Adwords et le nombre de mots, ce qui est important pour définir un score qualité. Vous pouvez aussi accéder aux données concernant les clics et même aux visites des bots depuis vos fichiers de log.

Comme ces données sont intégrées dans la plateforme de données d’Oncrawl, vous pouvez les fusionner et/ou les exporter ou directement consulter le rapport.

Ce cas pratique peut être très utile pour optimiser vos coûts et contrôler la performance de vos campagnes payantes.

3# Intégrer des données de CRM

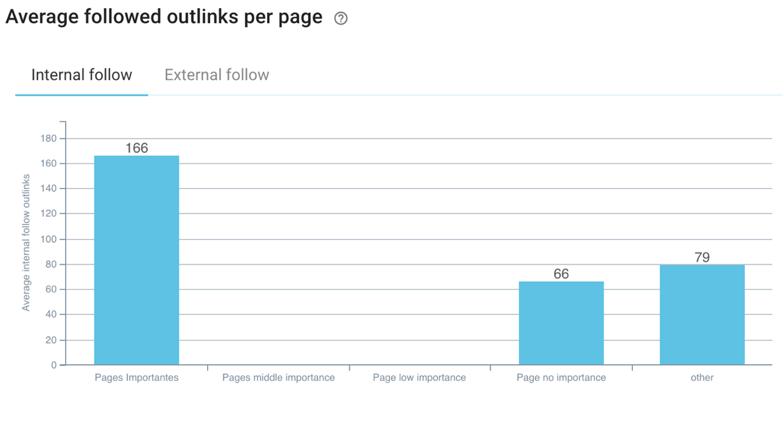

Dans votre CRM, vous pouvez marquer vos pages par niveau d’importance et les ingérer dans Oncrawl. Ce faisant, il est intéressant de vérifier si elles reçoivent suffisamment de popularité interne.

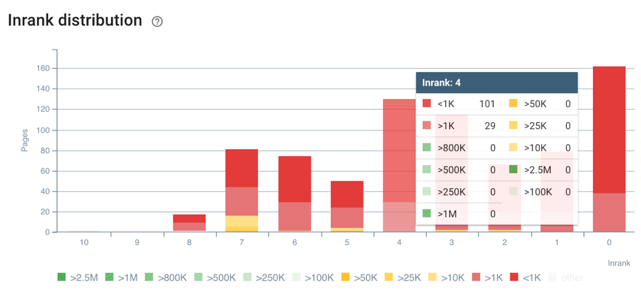

Dans cet exemple, les pages de moyenne et de faible importance reçoivent moins de liens internes que les pages qui n’ont pas d’importance. Vous pouvez vérifier si elles sont correctement liées dans l’architecture et si elles reçoivent suffisamment d’InRank.

Plus votre page est importante pour votre ROI, plus elle doit bénéficier de liens et de popularité provenant de votre site.

4# Déterminer le trafic depuis des domaines référents

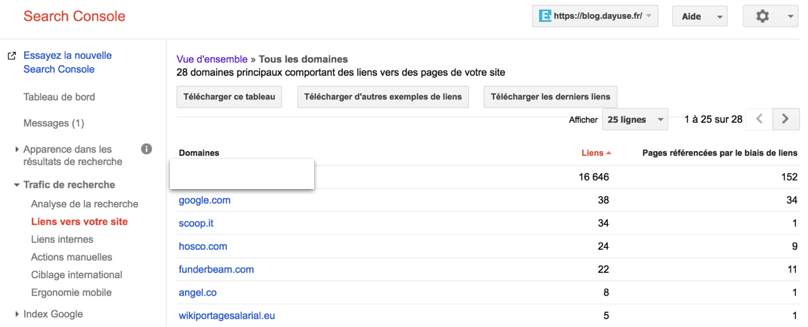

Nous avons un connecteur intégré avec Majestic pour analyser vos backlinks. Mais il est aussi intéressant de savoir quel site web envoie le plus de trafic ou de liens.

En exportant les liens pointant vers votre site depuis la Search Console, vous pourrez les segmenter dans Oncrawl en fonction du nombre de domaines référents.

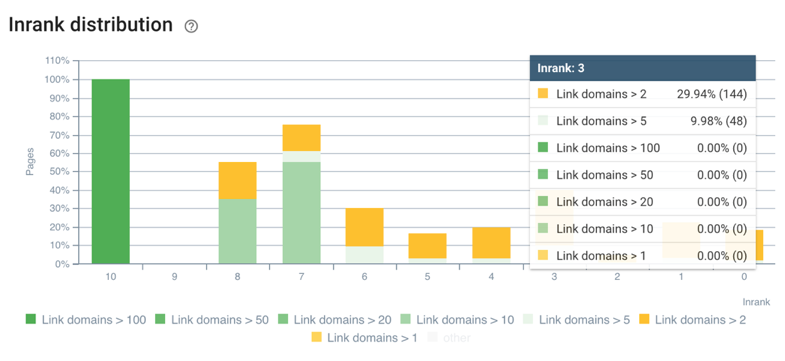

Il est intéressant de comprendre où sont vos pages classées sur des sites externes et quel Inrank elles reçoivent.

Les pages recevant beaucoup de domaines de lien pourraient être optimisées en envoyant une partie de ce jus de popularité vers d’autres pages importantes.

5# Analyser l’impact des impressions, CTR ou positions sur la profondeur et l’Inrank

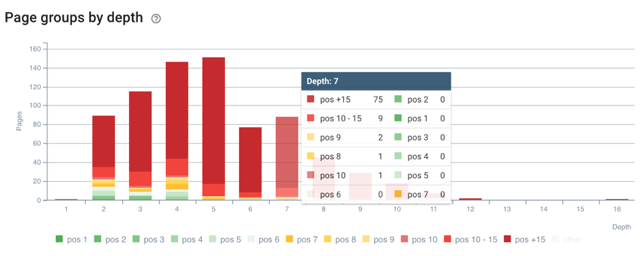

Vous pouvez comparer l’Inrank de vos pages et la profondeur avec vos positions, CTR ou impressions en ingérant les données de votre Search Console.

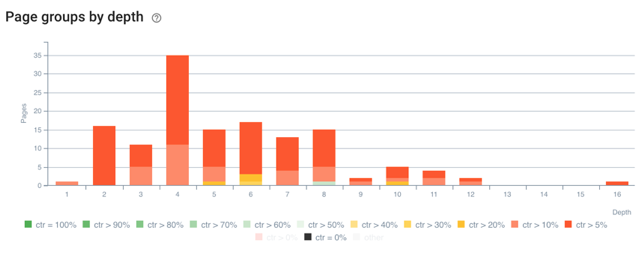

Ici, vous pourrez voir où sont situées vos pages dans l’architecture de votre site web par positions et comprendre où sont localisées vos meilleures pages par profondeur.

Vous pouvez aussi contrôler à quel point vos pages recevant le plus d’impressions sont populaires. Les pages qui reçoivent moins de 1k visites sur une période de 90 jours et qui disposent d’un Inrank pauvre devraient être re-optimisées en terme de maillage interne.

Il en est de même pour la relation entre le CTR et la profondeur associés à vos pages.

5bis# Aller plus loin en combinant votre Search Console avec vos fichiers de log

Vous pouvez analyser vos pages actives et inactives en fonction de vos groupes de pages et de leurs positions. Les pages actives sont des pages qui génèrent du trafic organique depuis les SERPs.

Dans nos exemples, les pages inactives en position 5 ont une faible fréquence de crawl. Peut-être qu’elles ne sont pas suffisamment attrayantes depuis les SERPs et pourraient être optimisées au niveau de leur titre ou description.

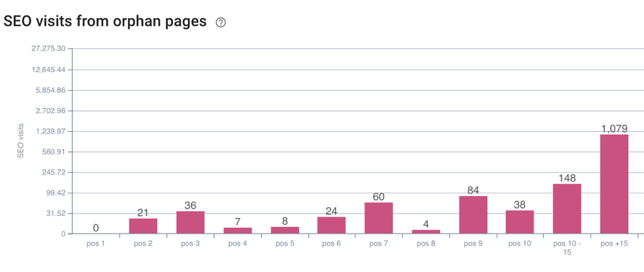

Vous pouvez aussi analyser vos visites SEO depuis vos pages orphelines. Avoir des pages orphelines qui sont classées peut être compromettant. Dans ce cas, vous pouvez réaliser une analyse combinée de vos visites SEO depuis vos pages orphelines en fonction de leurs positions. Avec ces données, vous pouvez agir sur les pages orphelines qui génèrent des visites depuis les SERPs en position 2 par exemple en optimisant leur maillage.

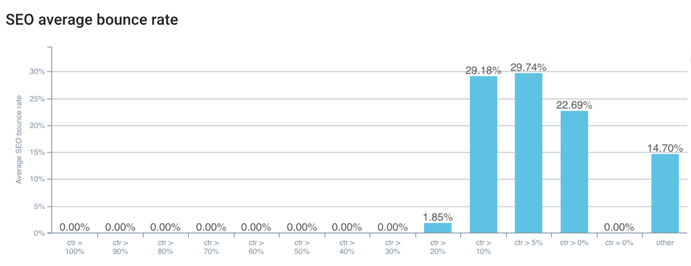

Enfin, vous pouvez aussi combiner vos données analytics et CTR. Ici, il est clair que les pages avec un CTR inférieur à 10 % disposent d’un taux de rebond proche de 30 %.

RankBrain prend en compte le taux de rebond ainsi que le CTR pour classer vos pages. Vous avez maintenant un moyen pour savoir quelles pages surveiller et améliorer.

Pour résumer, les possibilités procurées par l’ingestion de données d’Oncrawl sont très variées. Nous espérons que vous aimerez utiliser cette fonctionnalité et construire votre propre segmentation. Comme vous l’aurez compris, l’ingestion de données d’Oncrawl est votre meilleure alliée pour obtenir une vue détaillée de votre performance en search.