Les données prennent de plus en plus d’importance grâce à l’évolution des méthodologies de collecte de données et de la puissance de calcul. Le marketing digital et le SEO ont vu cette montée en puissance des nouvelles technologies grâce aux efforts de certains SEOs qui ont été les premiers à employer certaines de ces techniques.

Les outils de traitement du langage naturel (NLP) en sont un exemple car ils s’attaquent à des problèmes tels que le regroupement de mots-clés et même la reconnaissance d’entités dans les documents. La génération de texte est un autre sujet brûlant en ce moment et c’est grâce à ce domaine du machine learning que nous pouvons tester et utiliser ces nouveaux outils.

Dans cet article, j’aimerais aborder les raisons pour lesquelles l’intégration de ces nouvelles compétences peut être extrêmement pratique, surtout si vous êtes un SEO novice et que vous êtes fatigué de lire les conseils habituels.

Ci-dessous, nous allons parcourir une liste de tâches et d’exemples qui expliquent comment les données peuvent améliorer votre stratégie de référencement et vous faire gagner beaucoup de temps.

Disons, par exemple, que vous venez de créer un script qui automatise une tâche qui vous prend une heure en moyenne. S’il vous faut une minute pour exécuter le script et cinq heures pour l’écrire, vous n’aurez besoin de l’utiliser que six fois pour récolter la valeur de vos efforts.

L’analyse des données n’est pas différente. Certaines informations ne sont pas visibles à l’œil nu et Excel n’est ni assez puissant ni assez polyvalent pour résoudre certains problèmes.

Le clustering

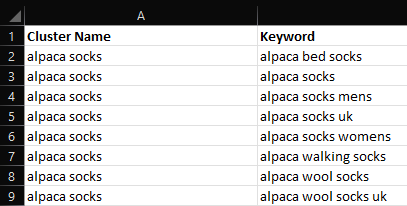

Le clustering est un ensemble de techniques visant à regrouper des objets. Ces techniques sont puissantes pour la recherche de mots-clés et la détection de problèmes à grande échelle, car le regroupement manuel des mots-clés peut être une grande perte de temps, surtout si vous avez affaire à 10 000 mots-clés ou plus.

Imaginez que vous deviez comprendre combien d’articles vous devez écrire à partir d’un ensemble de mots-clés. Vous devriez parcourir manuellement le fichier et créer des groupes, en espérant que vous avez raison. Cela représente une énorme quantité de travail et il n’y a aucune raison de faire cela, étant donné que le clustering peut résoudre ce problème et vous fournir une base solide pour commencer. Indéniablement, il y a un pourcentage de travail manuel impliqué dans la plupart des cas, mais ce n’est en aucun cas comparable.

Il existe de nombreux types de techniques de clustering, que je vais détailler ci-dessous ; cependant, je pense que les plus performantes sont les transformateurs de phrases. C’est mon premier choix car elle est capable de capturer la sémantique derrière les phrases et les mots.

Par le terme transformateur, nous faisons référence à un type spécifique d’architecture de réseau neuronal basé sur l’attention. En d’autres termes, l’attention est un mécanisme qui permet à ces modèles de connecter n’importe quelle partie de la séquence de texte qu’ils analysent. Il s’agit d’une caractéristique très pratique pour le langage parlé, car les mots que nous utilisons ont une signification différente selon le contexte.

Parmi les autres techniques courantes, citons K-means et DBscan, qui ne sont pas basées sur des réseaux neuronaux. Par conséquent, j’ai constaté qu’elles ne sont pas aussi performantes que les modèles de transformation.

Faire le bon choix pour vous dépend de la vitesse que vous souhaitez et du degré de précision. Dans les cas où la vitesse est importante, vous pouvez vous en tenir à K-means et utiliser TF-IDF comme métrique principale. Ne vous souciez pas trop de connaître tous les types possibles. Vous devez seulement vous concentrer sur ce qui fonctionne pour vous et ce qui peut augmenter l’efficacité de vos projets.

Avantages :

- Solution optimale pour l’automatisation

- Fort potentiel de retour sur investissement

Inconvénients :

- Il est facile de se tromper et d’obtenir de mauvais résultats

- Les outils payants sont chers

[Ebook] Crawling & les fichiers de logs : cas pratiques et conseils basés sur l’expérience

La visualisation de données (DataViz)

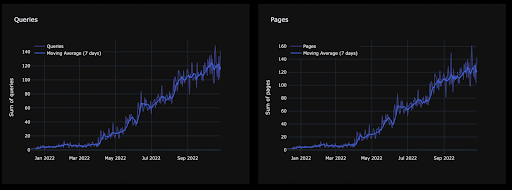

Il est presque toujours préférable de montrer que de dire, et les données ne font pas exception. Il y a des moments où vous voulez que les points soient clairs et ne laissent aucune place à l’erreur. Par exemple, montrer le nombre de requêtes pour lesquelles vous n’êtes plus classé est un bon exemple. Ou, si vous voulez montrer combien de revenus vous perdez au fil du temps, la visualisation de données serait un moyen efficace de le faire.

DataViz est plus un art qu’une science et il faut beaucoup de pratique et de connaissances du domaine pour créer des visualisations puissantes. En tant que spécialiste SEO, vous n’avez pas besoin d’être un maître, mais comprendre comment tracer des données et quoi présenter aux parties prenantes potentielles n’est pas une mince affaire.

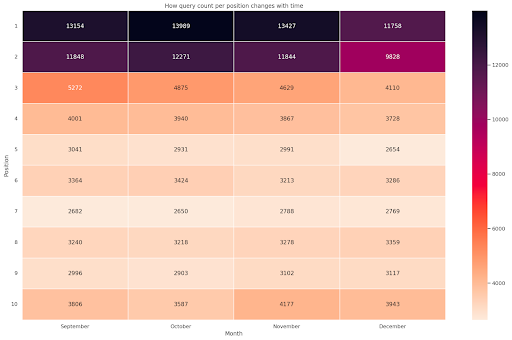

Prenons un exemple concret. Google Search Console ne vous montre pas beaucoup d’informations car l’interface est assez limitée et vous ne devriez pas rapporter des métriques de base comme les clics et les impressions sans contexte.

Après quelques jeux de pivot, vous pouvez facilement tracer une carte thermique pour montrer la progression dans le temps, ce n’est pas si difficile avec des connaissances de base d’Excel. J’ai déjà abordé le sujet dans mon article sur l’extraction des données de la GSC.

Ce qui est difficile, ce n’est pas le codage en soi, mais plutôt l’histoire que vous voulez raconter et la manière d’intégrer ce que vous produisez dans un contexte plus large.

Certains types de visualisation sont définitivement mieux adaptés à certains scénarios. Les cartes thermiques susmentionnées, par exemple, sont excellentes si vous traitez des dates et des variables de catégories, comme les fourchettes de position pour vos requêtes.

Le principal problème avec DataViz est que les utilisateurs inexpérimentés peuvent mal interpréter les informations. La visualisation n’est pas seulement une question de codage, il faut aussi un peu de théorie des couleurs et de bon sens. Les graphiques sont des armes puissantes si vous savez comment les utiliser, sinon, ils peuvent être dangereux.

Beaucoup de gens passent à côté du véritable intérêt des données, qui est de raconter une histoire et de communiquer efficacement. DataViz est la forme de formation idéale pour affiner vos compétences et en dire plus avec moins. C’est ce qui fait la différence entre un grand analyste SEO et la personne technique moyenne ayant quelques connaissances en code.

Avantages :

- Facilite la visualisation des modèles

- Arme puissante pour convaincre la direction

Inconvénients :

- Difficile à maîtriser

- Il est facile de se tromper et de tirer des conclusions trompeuses

Le scraping

Notre travail implique souvent le scraping de sites web pour vérifier s’il y a des erreurs ou pour rechercher des corrections techniques. Le scraping peut également être utilisé pour collecter des données et certaines des activités les plus valorisantes impliquent ce processus.

Les possibilités sont nombreuses. Vous pouvez :

- Scraper le sitemap de vos concurrents et obtenir leur taux de publication.

- Comprendre quels sont les mots ou les sujets les plus courants.

- Analyser leur texte pour rechercher des entités.

Vous n’avez pas besoin d’apprendre à coder pour exécuter cette tâche, car il existe de nombreux outils facilement disponibles. Les principales utilisations concernent la surveillance des prix, l’obtention quotidienne de nouveaux articles ou produits à partir d’une liste de sites Web, et l’analyse de votre concurrence. En général, le scraping peut vous donner accès aux meilleurs ensembles de données. C’est l’une des activités que je vous recommande d’apprendre car le potentiel est extrêmement élevé.

Les SEOs spécialisés en e-commerce ont beaucoup à y gagner car le scraping des prix dans des secteurs concurrentiels est un grand défi et vous permet de détecter rapidement les anomalies dans les politiques de prix.

Si vous êtes plus axé sur le contenu, cela reste essentiel car vous pouvez scraper les flux RSS à la recherche des derniers articles. Vous pouvez également obtenir une longue liste d’articles provenant d’autres sites Web, puis explorer ces URLs pour analyser leur texte.

Le scraping est la base pour commencer à rassembler vos données et à améliorer votre référencement. Je vous recommande vivement de commencer par là.

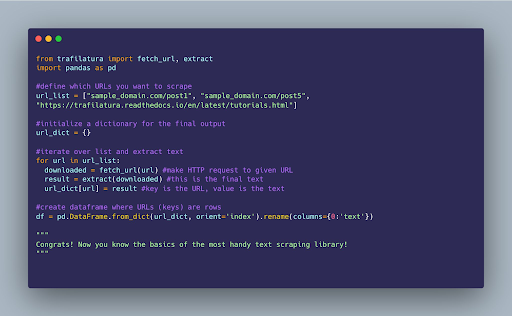

Ma bibliothèque préférée pour cette tâche est trafilatura si je dois scraper le texte des articles de blog, sinon c’est Scrapy sans aucun doute.

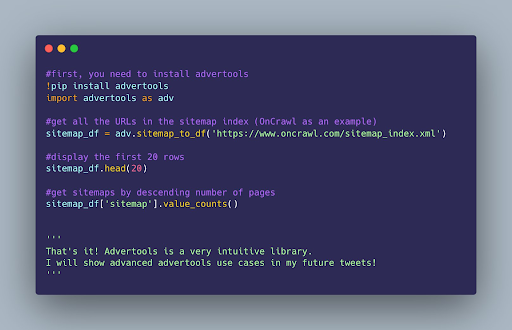

Comme Scrapy est assez difficile à utiliser la première fois, vous pouvez simplement utiliser advertools, qui est construit par-dessus. Vous pouvez utiliser une ligne de code pour réaliser quelque chose qui demanderait sinon beaucoup plus d’efforts.

Avantages :

- Le seul moyen d’obtenir certaines données qui ne peuvent être obtenues via des outils

- Flexibilité maximale

- Clé pour le SEO programmatique

Inconvénients :

- Demande beaucoup de ressources

- Ce n’est pas aussi facile qu’il y paraît

L’analyse de texte

Mon choix préféré et l’une des techniques de données les plus sous-estimées dans la communauté SEO est l’analyse de texte. On se concentre beaucoup sur l’automatisation, mais beaucoup moins sur l’analyse et la compréhension. L’analyse de texte, une forme d’automatisation intelligente, vous permet d’examiner une grande quantité de texte et de trouver des opportunités d’optimisation intéressantes. Ce processus, qui repose souvent sur des logiciels exploitant des algorithmes d’apprentissage automatique et de traitement du langage naturel, rend l’examen d’un grand nombre de données textuelles évolutif et cohérent.

Parmi les outils de SEO dont vous avez peut-être entendu parler figurent l’AutoML de Google ou l’API de langage naturel ou le Comprehend d’Amazon. Ces outils utilisent des techniques telles que la vérification des n-grams et des entités pour trouver des améliorations pertinentes et potentielles pour vos articles. Bien qu’il n’y ait pas toujours beaucoup d’informations utiles extraites, vous pouvez toucher le jackpot avec le bon état d’esprit.

Avantages :

- Peu de gens l’utilisent pour le SEO, facile d’obtenir des informations originales

- Optimisation de niveau supérieur

- Peut être utilisé pour trouver des plaintes de clients ou analyser des données scrappées

Inconvénients :

- Coûteux en termes de calcul

La modélisation des sujets

Il est parfois difficile de comprendre les sous-thématiques d’un site Web. Si vous travaillez sur un site de contenu, il y a de fortes chances que vous ne puissiez pas rivaliser avec les goliaths, vous devez cibler des sujets moins populaires et spécifiques. Les trouver peut s’avérer difficile si vous ne connaissez pas le secteur et devez les parcourir manuellement.

Une autre perspective sur le sujet consiste à considérer les sujets comme des éléments potentiels sur lesquels on peut juger un site Web. Vous pouvez obtenir des données textuelles à partir des sites Web de vos concurrents, puis modéliser les thèmes qu’ils proposent afin de comprendre comment ils pourraient être perçus par un moteur de recherche.

Ma bibliothèque préférée pour cela est BERTopic, la meilleure bibliothèque Python pour cette tâche. Le cas d’utilisation le plus courant consiste à comprendre les sites Web de vos concurrents à l’échelle et à vérifier où vous devez investir. Cette méthode est excellente pour l’analyse préliminaire et pour la sélection de niches.

Avantages :

- Imite la façon dont une machine pourrait interpréter votre site Web

- Trouver des sujets latents

Inconvénients :

- Coûteux en termes de calcul

- Pas toujours précis pour certains sujets

- Il est facile de se tromper

[Ebook] Data SEO : La prochaine grande aventure

L’extraction d’entités

La recherche d’entités est une tâche plutôt sous-estimée, car de nombreux SEOs l’ignorent encore. Nous savons avec certitude que Google et les moteurs de recherche modernes se basent sur la sémantique et différents critères pour indexer et classer les documents. Il est essentiel de savoir quelles entités sont populaires dans une certaine niche si vous voulez améliorer la qualité de votre contenu ou simplement trouver de nouveaux sujets que vous n’avez pas couverts.

Les choix les plus populaires consistent à scraper les SERPs avec une liste de mots-clés pour repérer les opportunités intéressantes ou à analyser le site d’un concurrent. Vous pouvez également vérifier votre site Web et effectuer une analyse des lacunes pour voir où vous en êtes.

En d’autres termes, vous pouvez simplement vérifier quelles sont les entités qui ne sont pas en commun entre votre site web et un autre. Celles qui manquent sont plus intéressantes et peuvent être intégrées à votre domaine.

L’une des API les plus connues pour effectuer cette tâche est Google NLP. Je ne l’utilise plus car elle a été entraînée sur un ensemble de données très « petit » et ancien, et elle échoue donc complètement dans des niches comme la fiction ou le e-commerce.

Cette API dispose cependant d’une bonne métrique, appelée saillance. Elle mesure l’importance des entités dans votre texte, ce qui signifie qu’une valeur élevée indique une plus grande pertinence. Néanmoins, la saillance n’est pas vraiment la mesure la plus importante, car vous pouvez préférer différentes interprétations. La bibliothèque spaCy est assez avancée et peut être entraînée avec de nouveaux textes pour être encore plus performante. Comment le machine learning affecte vos campagnes de marketing digital ?

L’exemple ci-dessus vous montre pourquoi il est nécessaire de former les modèles correctement. Certains noms fictifs sont reconnus avec le mauvais type et la seule façon de régler ce problème est de former un modèle personnalisé.

Les référenceurs n’ont pas besoin d’être des scientifiques ou des ingénieurs, mais si vous vous engagez dans cette voie, vous devez posséder des compétences de base pour traiter ces problèmes. Pensez en termes de domaines et d’industries, vous aurez probablement besoin de reconnaître des entités pour des sujets spécifiques.

Le seul problème avec cette approche est qu’il faut beaucoup de temps et de ressources pour le faire. Pour cette raison, je préfère utiliser d’autres services comme TextRazor pour l’extraction d’entités. Cette tâche n’est qu’une des nombreuses tâches NLP que vous pouvez effectuer aujourd’hui, et un exemple clé de la façon dont le machine learning affecte vos campagnes de marketing digital.

Avantages :

- Utile pour découvrir des manques dans les sujets

- Trouvez des entités et construisez un réseau de contenu autour d’elles

- Essentiel pour évaluer l’ensemble de votre site Web

Inconvénients :

- Vous avez besoin d’un bon extracteur d’entités

- Cela peut facilement coûter cher

L’automatisation

L’automatisation est l’une des tâches qui apporte le plus de valeur ajoutée et aussi celle qui peut vous faire gagner le plus de temps. L’automatisation des tâches ennuyeuses est un bon moyen de travailler sur la partie stratégique du SEO et d’éviter de perdre du temps sur des opérations de moindre importance. Vous pouvez automatiser à peu près toutes les tâches de référencement, et les exemples courants incluent la création de balises de titre, et de descriptions et même l’amélioration de la résolution des images.

Les langages de codage tels que Python et R sont les meilleurs choix, même si le premier a l’avantage parce qu’il s’agit d’un langage de programmation à usage plus générique et qu’il dispose de meilleures bibliothèques pour cette tâche.

Le principal problème de l’automatisation est que vous risquez de perdre le contrôle de certaines tâches pour lesquelles vous devez être vigilant et donner plus qu’une simple saisie.

La recherche de mots-clés, par exemple, peut être facilement automatisée, mais ma recommandation pour ce cas précis est d’utiliser des scripts pour vous aider dans votre travail, et non le remplacer complètement.

Par exemple, il est assez difficile et peu judicieux d’utiliser le volume comme mesure dans certains secteurs, car il ne vous dit rien sur l’intention d’une page. Il est possible d’automatiser même les tâches non-SEO, à condition que vous trouviez que cela en vaille la peine.

Avantages :

- Économisez du temps et des ressources pour les tâches fastidieuses

- Cela augmente votre productivité puisque vous travaillez moins sur certaines tâches

- Pas si difficile à réali

Inconvénients :

- Certaines solutions d’automatisation peuvent prendre des semaines entières

- L’automatisation de certains processus peut faire plus de mal que de bien

L’analyse générale des données

Il est difficile de définir ce qu’est réellement l’analyse des données, mais on peut dire essentiellement que l’analyse des mots fait référence à la simplification de quelque chose en ses composants de base. Maintenant, voyons comment nous pouvons appliquer ces connaissances au référencement.

Les sources de données les plus courantes sont Google Search Console, Google Analytics, les données de scraping et les métriques tierces. Un bon flux d’analyse de données est capable de vous donner suffisamment d’informations sur ce qu’il faut faire ensuite ou d’enquêter sur ce qui s’est passé ou ce qui se passe en ce moment.

L’importance de l’analyse des données découle de la nécessité de comprendre comment travailler dans des situations complexes. Devrais-je optimiser un certain sujet ? Ce produit m’apporte-t-il de bonnes pistes ? Vous ne pouvez le savoir qu’avec l’analyse.

En fait, l’analyse implique un certain degré d’abstraction et de connaissance du domaine.

Le point le plus important à retenir est que l’analyse n’est pas destinée à répondre aux questions. Si vous analysez quelque chose, vous voulez améliorer la qualité de vos questions. C’est-à-dire, à moins que vous n’ayez déjà la réponse ou que le scénario que vous traitez soit assez transparent.

Par exemple, vous ne pouvez pas appliquer les mêmes critères de B2B à un secteur B2C, car vous avez besoin de mesures différentes et vous avez également d’autres objectifs. Mesurer le trafic ou les impressions pour une marque B2B est utile pour le contenu, mais votre intérêt est d’obtenir des prospects et d’augmenter vos profits.

Un éditeur est généralement très intéressé par la quantité de trafic organique qu’il obtient pour vendre plus d’abonnements. Utiliser la simple augmentation du trafic pour un SaaS B2B est trompeur car il s’agit d’une mesure de vanité. Ces valeurs n’ont aucune signification réelle pour une entreprise et ne devraient pas être ce que vous présentez.

Néanmoins, il s’agit de l’une des pratiques les plus sous-estimées du marketing, car elle est souvent mal comprise et échangée par des vidages de données ou de simples options de tri Excel.

Avantages :

- C’est encore une niche dans la communauté SEO, vous pouvez l’utiliser pour découvrir beaucoup d’opportunités

- Vous pouvez obtenir des informations uniques que la majorité des outils SEO ne fournissent pas

Inconvénients :

- Vous devez connaître votre secteur d’activité, le codage ne suffit pas

- La mauvaise qualité des données peut nuire à vos résultats

La théorie des graphes

Les graphiques offrent un niveau de flexibilité que les autres structures de données ne peuvent offrir pour certains cas d’utilisation. Par exemple, ils peuvent représenter la structure de liens internes d’un site web et la manière dont les URLs interagissent entre elles.

La théorie des graphes est largement utilisée par les moteurs de recherche modernes pour évaluer les réseaux de liens retour et pour leur méconnu graphe de connaissances. Et, saviez-vous que vos phrases sont converties en un graphe pour être évaluées ? Google est vraiment un moteur de recherche intelligent, même si ses mises à jour et certains de ses comportements sont souvent « excentriques ».

Un graphe est composé de nœuds, d’arêtes et d’étiquettes/attributs. Appliquons ce concept au référencement :

- Les nœuds sont les URLs.

- Les arêtes agissent comme des connexions entre les nœuds, ce sont donc des liens.

- Une étiquette peut être la chaîne URL réelle ou toute autre information que vous souhaitez ajouter à un nœud.

Les SEOs peuvent utiliser certaines connaissances de base pour auditer les sites Web et repérer les scénarios anormaux.

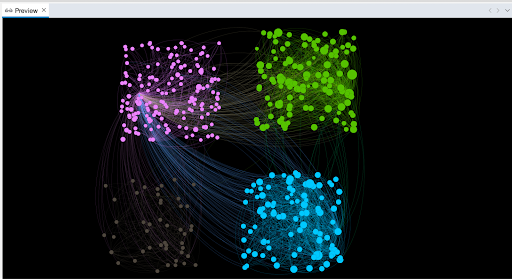

Mon outil préféré pour la visualisation de graphiques est Gephi, un logiciel libre qui peut gérer à peu près tout ce dont vous avez besoin. Python n’est pas adapté à la visualisation de ce type de données et mon flux de travail habituel en tient compte.

D’abord, je scrape et récupère les données avec son aide, puis j’enregistre le graphique généré dans un format Gephi lisible. À partir de là, je passe à Gephi et je commence à travailler sur mon graphique. Vous pouvez exécuter plusieurs statistiques que vous utiliserez plus tard pour filtrer ou mettre en évidence vos données. Sur cette base, vous pouvez visualiser des modèles intéressants ou voir si certaines URLs sont si importantes dans la structure de votre site Web.

L’exemple ci-dessous vous montre quatre clusters au sein d’un site Web. La taille du nœud (URL) est exprimée par la métrique du hub, ce qui signifie que les pages présentant des valeurs élevées peuvent être qualifiées de « hubs » dans le jargon du SEO.

Ce qui est étrange ici, c’est que le groupe vert présente de nombreux cercles de taille similaire, ce qui signifie que les liens sont équidistribués. Et ce n’est pas le meilleur résultat pour ce que j’ai prévu car il devrait y avoir deux hubs visibles dans ce groupe.

Le groupe gris concerne un sujet secondaire, il est donc possible de le laisser tel quel.

Si vous savez comment raconter une histoire avec ces données et comment les présenter, aucun SEO ne se mettra en travers de votre chemin. Une communication efficace des données est la meilleure compétence que vous puissiez souhaiter.

Avantages :

- Le meilleur pour présenter les données et les audits

- Je ne connais pas de meilleure alternative pour vérifier les liens

Inconvénients :

- Se tromper est plus facile que vous ne le pensez

- Vous devez avoir une bonne maîtrise des graphiques

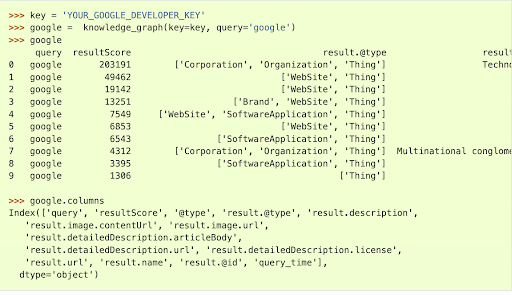

Les graphes de connaissances et SPARQL

Comme nous l’avons déjà dit en parlant du SEO sémantique, les graphes de connaissances jouent un rôle clé dans les moteurs de recherche modernes. En gros, il s’agit d’un réseau qui relie des entités (nœuds), et les connexions elles-mêmes sont appelées arêtes. Chaque page de votre site Web peut être considérée comme un nœud, relié à d’autres pages par des liens, vos bords.

Mais cela s’applique également aux mots de votre texte, car la syntaxe est une forme d’ordre par définition. Cela signifie que la façon dont vous écrivez vos phrases a un certain effet sur les moteurs de recherche. Les graphes de connaissances vous permettent de comprendre et de visualiser votre structure « latente ». Il est assez facile de comprendre les liens internes d’un sous-ensemble de pages si vous pouvez les voir.

Normalement, cette structure de données est représentée sous la forme de RDF, un format standard basé sur des triples. En termes simples, la structure suit le modèle sujet-prédicat-objet.

Paul (SBJ) mange (PRD) une pomme (OBJ).

Dans la phrase ci-dessus, vous avez deux entités reliées par la relation spécifiée par le verbe. Les graphes de connaissances combinés aux balises syntaxiques vous permettent d’identifier ces modèles.

L’utilisation réelle de ces données est très faible et je préfère des tâches plus pratiques comme l’évaluation de la validité des liens internes ou la visualisation.

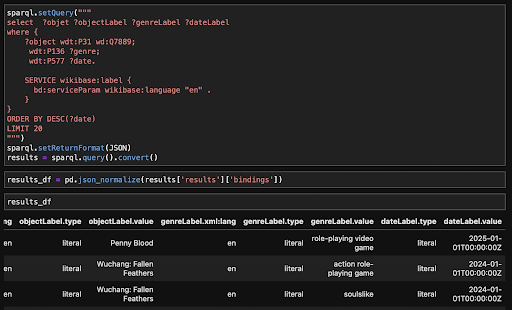

À ce propos, de nombreuses sources de données utilisées par Google pour alimenter son graphe de connaissances utilisent des données RDF. Le langage query permettant de récupérer ces données s’appelle SPARQL, un dialecte SQL. Il est possible d’obtenir des données de Wikidata et d’IMDB ainsi que leurs relations sémantiques.

Voyez-vous la différence avec le scraping ? Les données RDF possèdent ces informations sémantiques qui peuvent être utilisées pour connecter des concepts.

Ceci est extrêmement bénéfique pour le SEO programmatique ou même les bases de données en ligne. Le scraping traditionnel n’a pas la capacité de donner du sens à votre texte et ces informations sémantiques supplémentaires peuvent changer la façon dont vous construisez vos pages.

Je suis actuellement en train de l’étudier et je n’ai donc pas encore beaucoup d’expérience pratique dans l’écriture de requêtes complexes. Néanmoins, le potentiel est énorme et je vois que c’est un must pour quiconque travaille avec une grande masse de données.

Avantages :

- C’est la direction que prend l’industrie

- Structures évolutives pour les grands sites Web

Inconvénients :

- Ce n’est pas toujours ce que vous voulez, restez simple

- Il y a très peu de cas d’utilisation