Le 25 septembre dernier, Oncrawl a eu l’honneur de recevoir Bill Hartzer pour un webinaire sur l’analyse des fichiers de log et l’importance que cela a pour les audits SEO. Il a parcouru son propre site pour montrer l’impact des optimisations sur l’activité des bots et la fréquence de crawl.

Qui est Bill Hartzer ?

Bill Hartzer est un consultant SEO et un expert en noms de domaine avec plus de 20 ans d’expérience. Bill est internationalement reconnu dans son domaine et a récemment été interviewé sur CBS News pour partager son point de vue sur le search..

Au cours de ce webinaire, Bill nous a présenté ses fichiers de log et nous a montré comment il les utilisait dans le contexte d’un audit de site. Il a détaillé les différents outils qu’il utilise pour vérifier la performance de son site et le comportement des bots.

Enfin, Bill a répondu aux questions des participants sur la manière dont il utilise Oncrawl pour dégager des résultats significatifs et fournir des conseils aux autres SEOs.

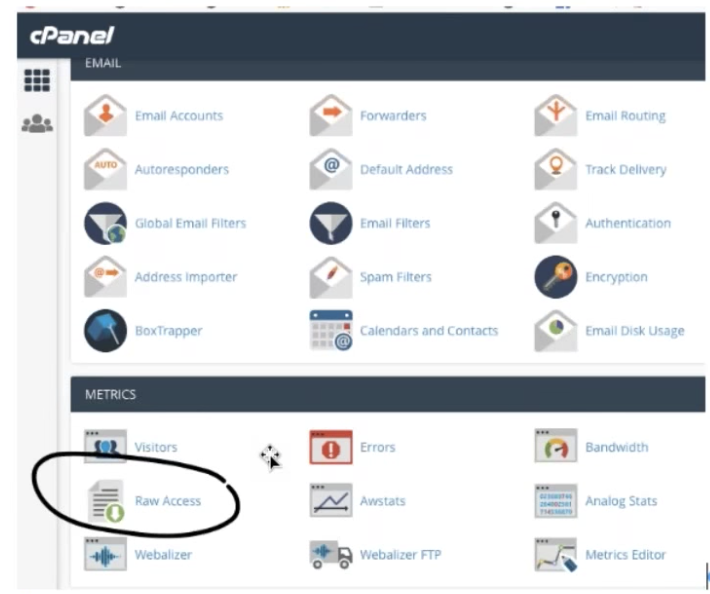

Comment accéder aux fichiers de log à travers le plugin cPanel pour WordPress ?

Si votre site a été construit avec WordPress et que vous utilisez le plugin cPanel, vous pourrez trouver vos logs directement dans l’interface WordPress.

Naviguez depuis les “Metrics” vers “Raw Access”. Ainsi, vous pourrez télécharger quotidiennement vos fichiers de log depuis le file manager et zipper des archives de fichiers plus anciens.

Examinez les contenus d’un fichier de log

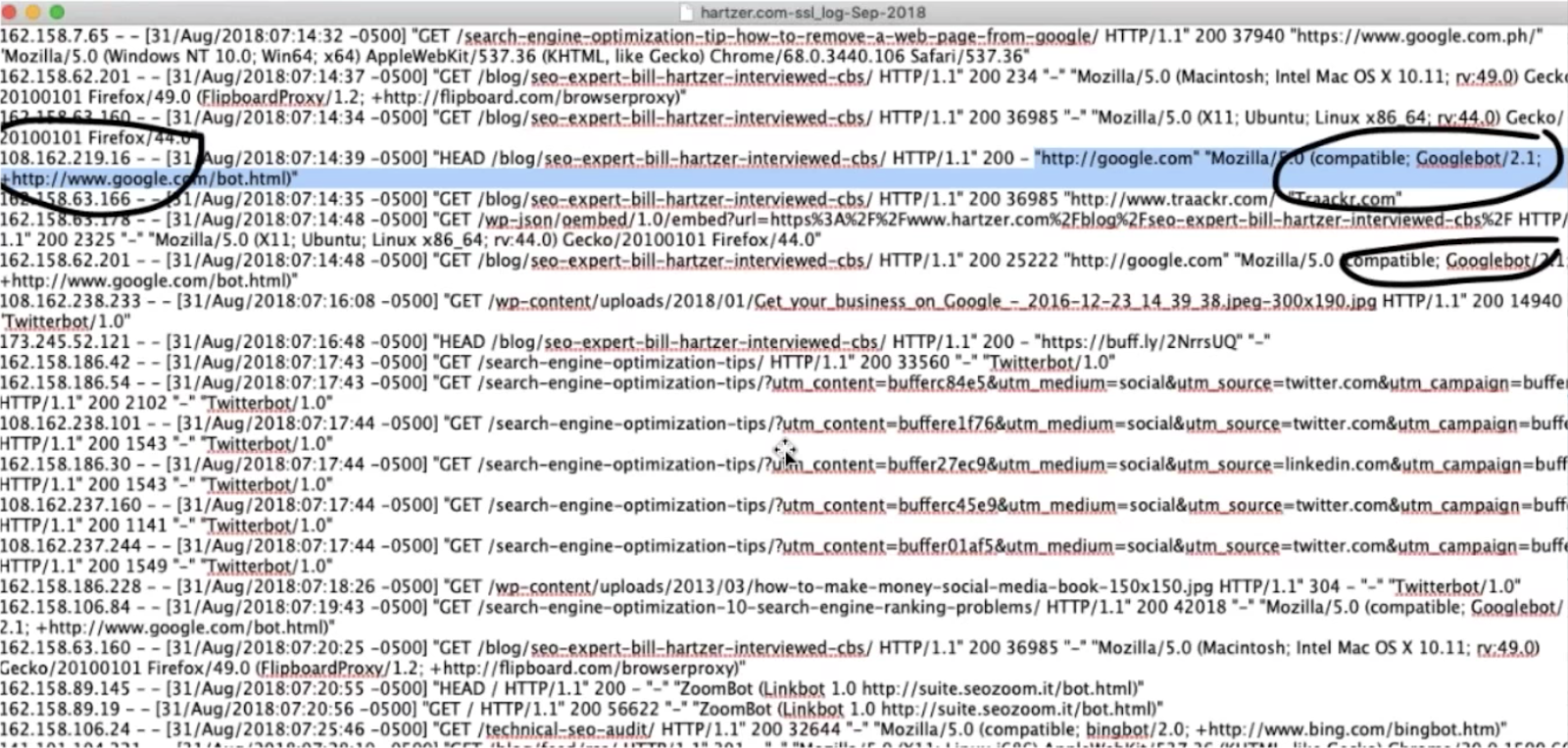

Un fichier de log est un large fichier de texte qui contient des informations sur les visiteurs de votre site, dont les bots. Vous pouvez l’ouvrir dans un éditeur de texte basique.

Ce n’est pas difficile de repérer les potentielles visites du googlebot ou de Bing (identifiables via les fichiers de log), mais il est tout de même mieux de confirmer l’identification du bot en utilisant IP lookups.

Vous pourriez également trouver d’autres bots qui crawlent votre site, mais qui ne sont pas vraiment utiles pour vous. Vous pouvez empêcher ces bots d’accéder à votre site.

Oncrawl va procéder à l’analyse de vos fichiers de log pour vous donner une vue claire et précise des bots qui visitent votre site.

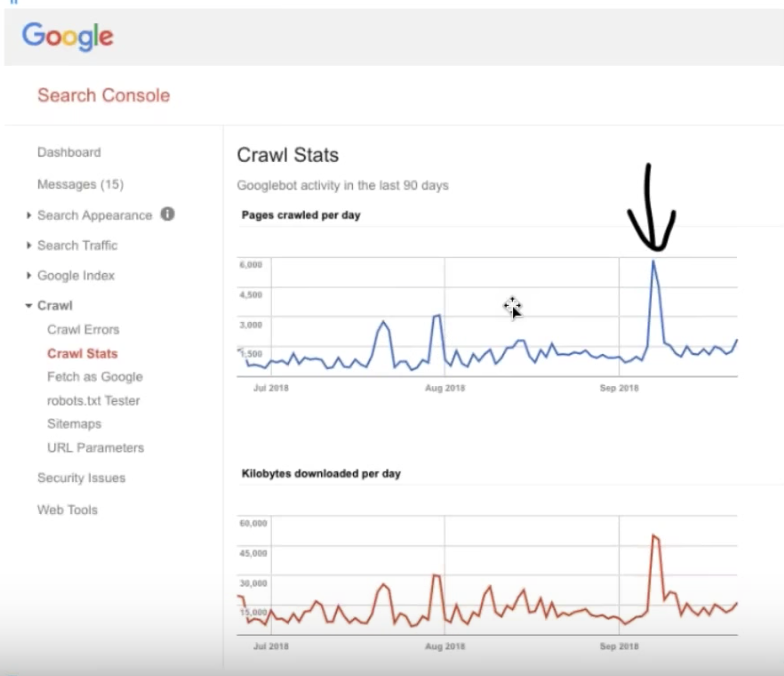

Utilisez vos fichiers de log pour plus d’information sur les Crawl Stats

Les informations sur les Crawl Stats sont disponibles dans l’ancienne version de la Google Search Console dans Crawl > Crawl Stats. Elles vous apporteront de nouvelles perspectives lorsque vous les comparerez aux données de vos fichiers de log.

Les données montrées dans la Google Search Console ne sont pas limitées aux bots SEO Google (elles contiennent tous les bots dont ceux Adsense par exemple) et peuvent donc être moins exactes que les informations que vous trouverez en analysant les fichiers de log.

Détection d’activité de crawl inhabituelle

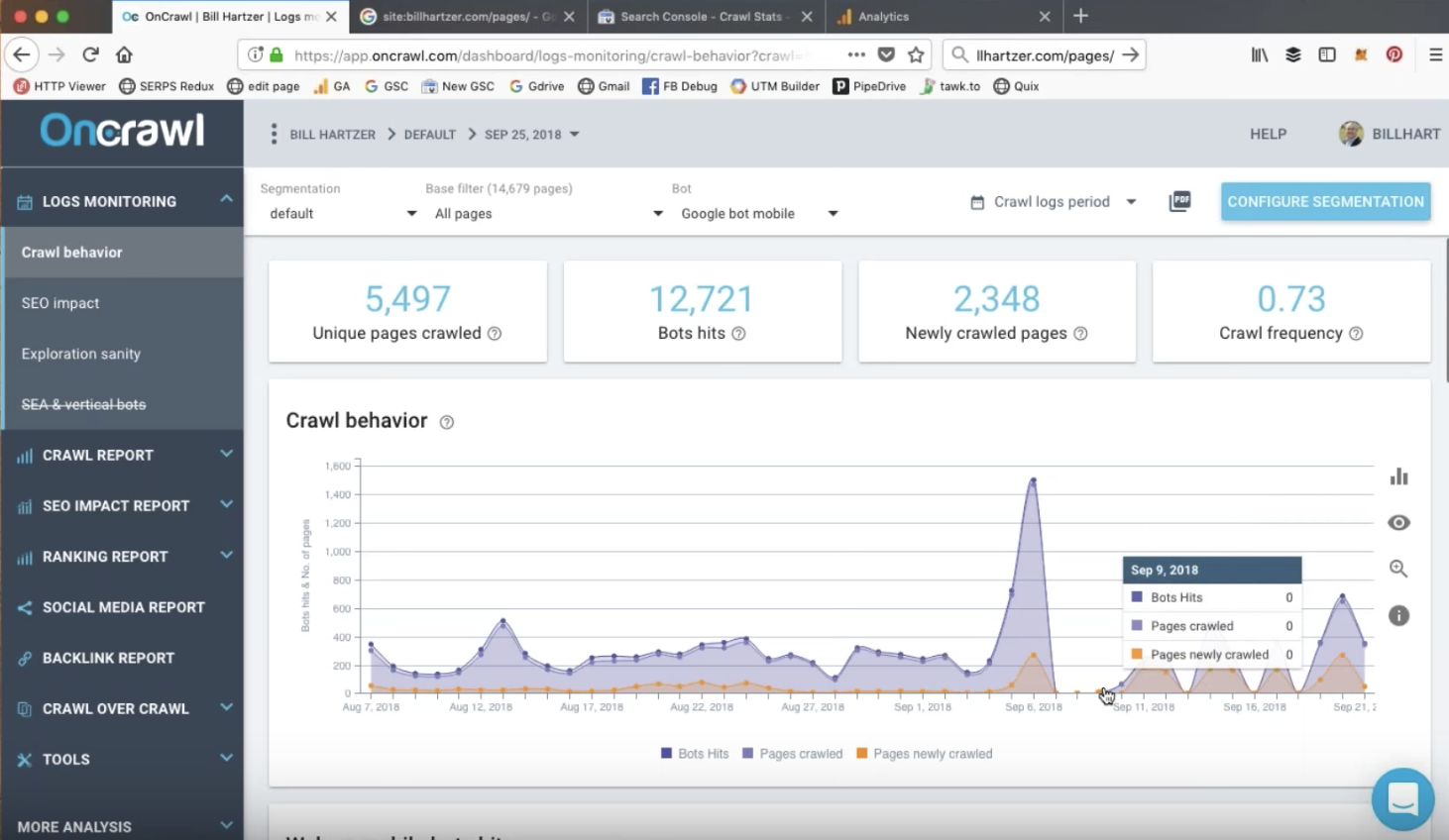

Bill a observé 3 pics récents visibles dans les statistiques de crawl de la Google Search Console. Ils correspondent à des événements importants qui ont déclenché l’augmentation de l’activité de crawl.

Pic d’indexation Mobile First

À première vue, le pic du 7 septembre dans la Google Search Console peut sembler sans rapport avec les événements sur le site. Cependant, un coup d’oeil aux analyses de logs dans Oncrawl fournit des indices :

L’analyse des fichiers de log nous permet de voir la répartition des différents bots que Google a utilisé pour crawler la page. Il est clair que l’activité du Googlebot desktop a brusquement décliné avant cette date. Ce pic, à la différence des précédents qui étaient plus faibles, est composé presque entièrement de visites sur des pages uniques et déjà indexées par le Googlebot mobile.

Une augmentation de 50 % dans le trafic organique enregistrée par Google Analytics confirme que ce pic correspond à l’indexation Mobile First du site en septembre, des semaines avant l’alerte officielle envoyée par Google !

Modification de la structure de l’URL pour le site

Mi-août, Bill a réalisé des changements dans la structure de son URL pour la rendre plus SEO-friendly.

La Google Search Console a enregistré 2 grands pics juste après cette modification, confirmant que Google identifie les événements majeurs sur un site et les utilise comme signaux pour recrawler les URLs d’un site web.

Lorsque l’on observe la répartition de ces visites dans Oncrawl, on voit que le second pic est moins aigu mais que le taux de crawl reste élevé durant plusieurs jours. Il est clair que Google a repéré les changements, Bill peut le confirmer en observant les différences dans l’activité de crawl au fil des jours suivant ses modifications.

Les rapports et les fonctionnalités Oncrawl utiles pour conduire un audit technique

Les visites SEO et les pages actives SEO

Oncrawl traite vos données de logs pour fournir des informations précises sur vos visites SEO ou les visiteurs humains arrivant des SERPs de Google.

Vous pouvez suivre le nombre de visites, ou analyser les pages SEO actives qui sont des pages individuelles de votre site recevant du trafic organique.

L’un des items que vous devez analyser lors d’un audit est la raison pour laquelle certaines pages indexées ne reçoivent pas de trafic organique (ou, en d’autres termes, ne sont pas des pages SEO actives).

Fresh Rank

Le Fresh Rank, une métrique Oncrawl, fournit des informations essentielles. Dans ce cas : le délais moyen entre le moment où Google crawle la page pour la première fois et où la page reçoit sa première visite SEO.

The #FreshRank helps you know how many days a page needs to be crawled for the first time and to gets its first #SEO visit #oncrawlwebinar pic.twitter.com/WVojWXKStC

— Oncrawl (@Oncrawl) September 25, 2018

Les stratégies de promotion de contenu et de développement des backlinks peut vous aider à gagner du trafic plus rapidement pour une nouvelle page. Quelques pages de cet audit, comme les articles de blog promus sur les réseaux sociaux, disposent d’un Fresh Rank plus bas.

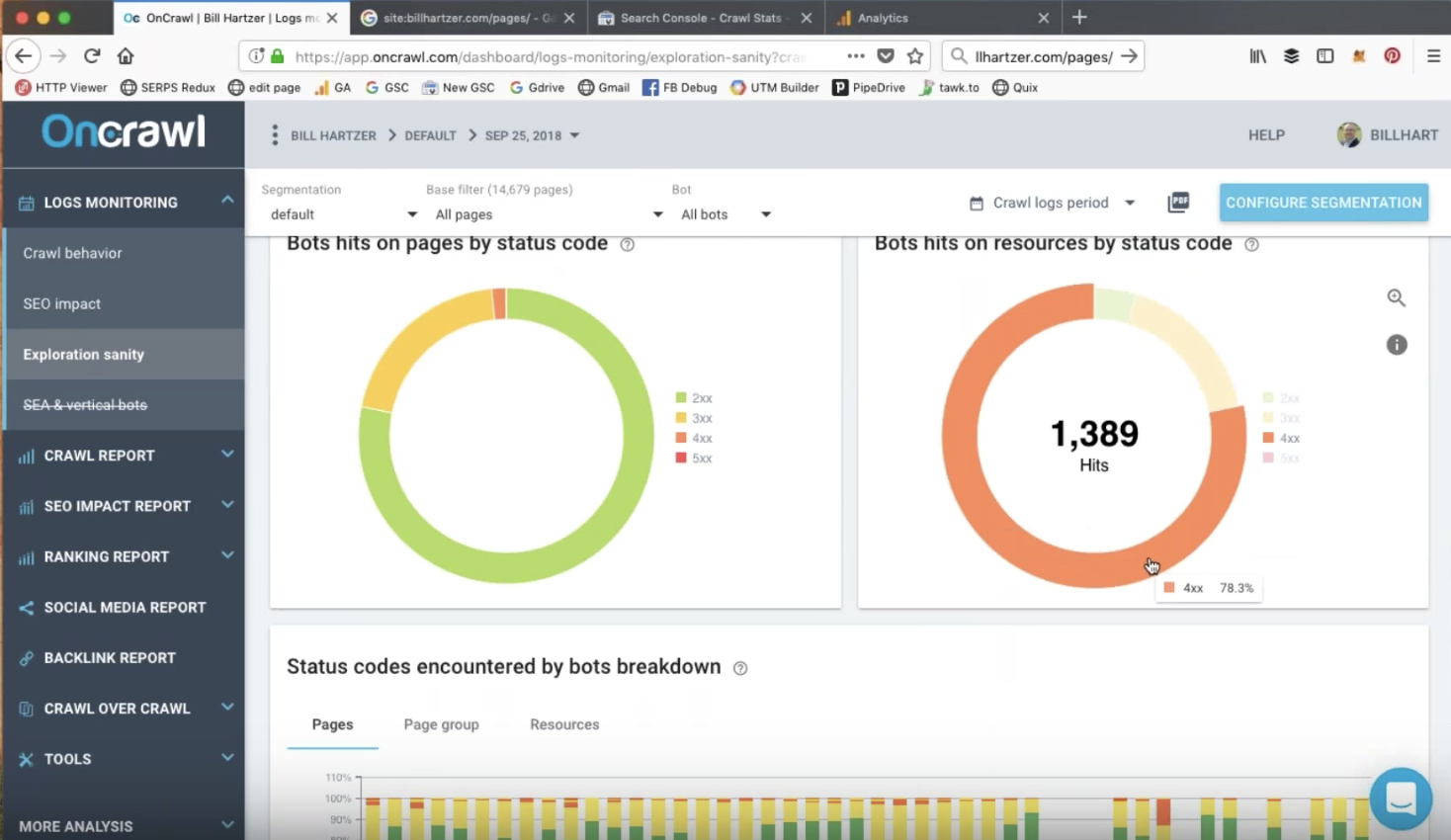

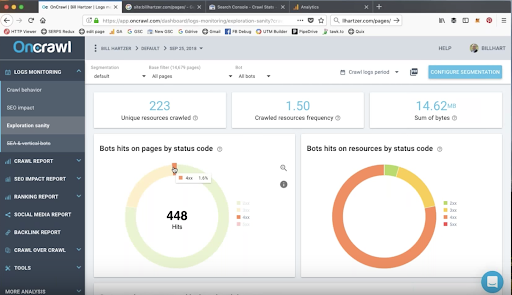

Les visites de bot sur les pages et les ressources par status code

Les bots peuvent visiter des URLs qui renvoient des erreurs 404 ou 410. Cela peut concerner les ressources comme le CSS, le JavaScript, les PDFs ou les images.

Vous devez absolument analyser ces éléments durant votre audit. Rediriger ces URLs et retirer les liens internes peut générer des résultats positifs.

Au cours d’un audit, il peut être utile de garder des notes sur les éléments qui doivent être traités, comme les URLs qui renvoient des erreurs de status aux bots.

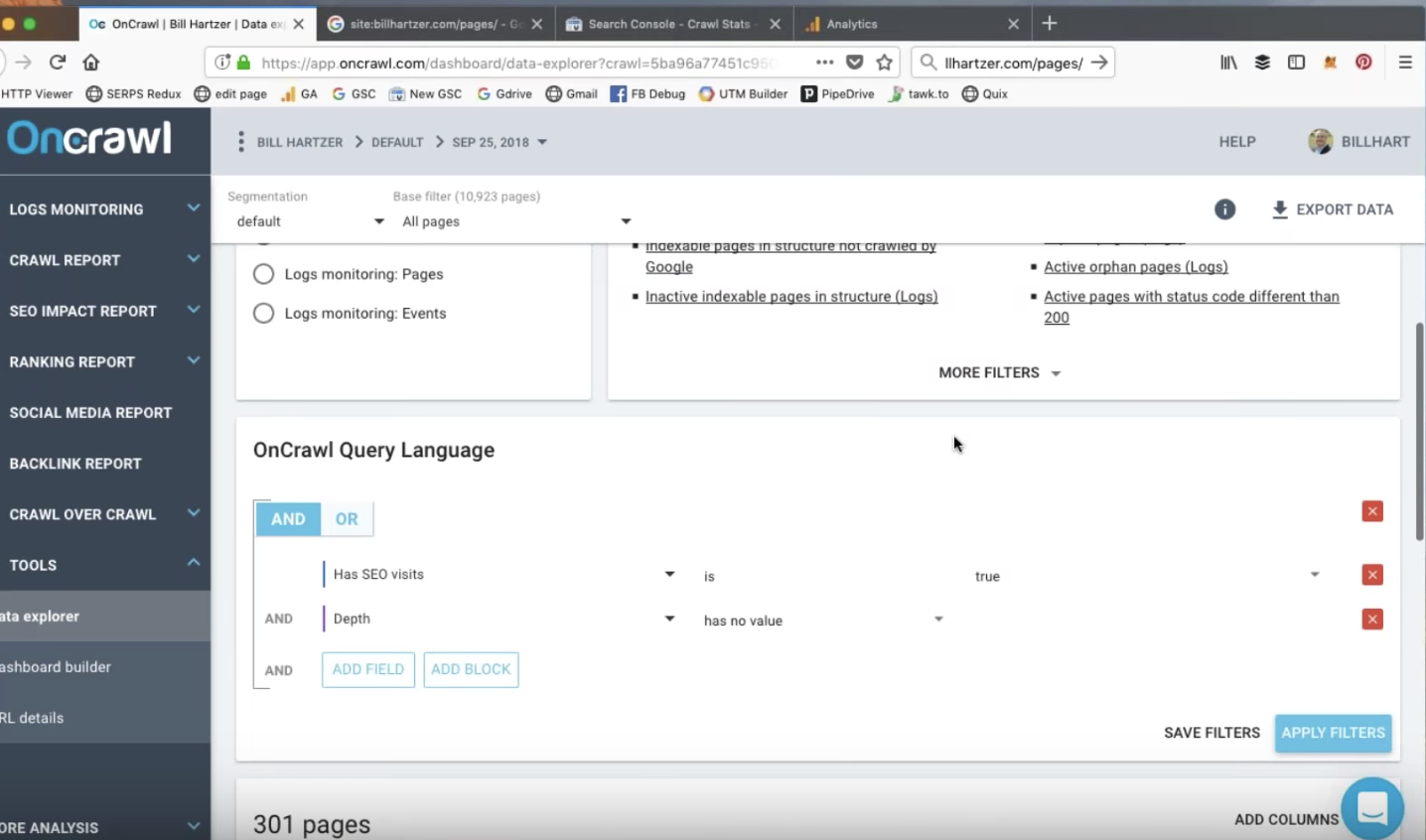

Rapports de Data Explorer : rapports personnalisés

Le Data Explorer d’Oncrawl offre des quick filters pour produire des rapports qui pourraient vous intéresser. Vous pouvez aussi générer vos propres rapports basés sur les critères qui vous sont utiles. Par exemple, vous pourriez vouloir enquêter sur vos pages SEO actives avec des rebonds et un fort temps de chargement.

Rapports du Data Explorer : pages orphelines actives

En combinant vos données analytics, de crawl et de logs, Oncrawl peut vous aider à découvrir les pages générant des visites organiques et humaines qui n’apportent pas toujours de la valeur à votre site. L’avantage d’utiliser les données de vos logs est que vous pouvez détecter toutes les pages de votre site qui ont été visitées, dont les pages qui pourraient ne pas disposer de code Google Analytics.

Bill a pu identifier les visites SEO organiques sur les feed RSS des pages, probablement par le biais des liens de sources externes. Ces pages sont des pages orphelines du site, elles n’ont pas de pages “parentes” qui renvoient vers elles. Ces pages n’apportent pas de valeur ajoutée à sa stratégie SEO, mais elles reçoivent toujours quelques visites depuis le trafic naturel.

Elles représentent de très bonnes candidates pour commencer les optimisations.

L’analytics search pour les classements de mots-clés

Les données des classements peuvent être tirées de la Google Search Console. Dans l’ancienne version de Google Search Console, vous pouvez aller dans Search Traffic, puis Search Analytics et voir les clics, impressions, CTR et positions des derniers 90 jours.

Oncrawl fournit des rapports clairs sur la manière dont ces données sont liées à l’ensemble de votre site. Ainsi, vous pouvez comparer le nombre total de pages sur le site, le nombre de pages classées et le nombre de pages qui reçoivent des clics.

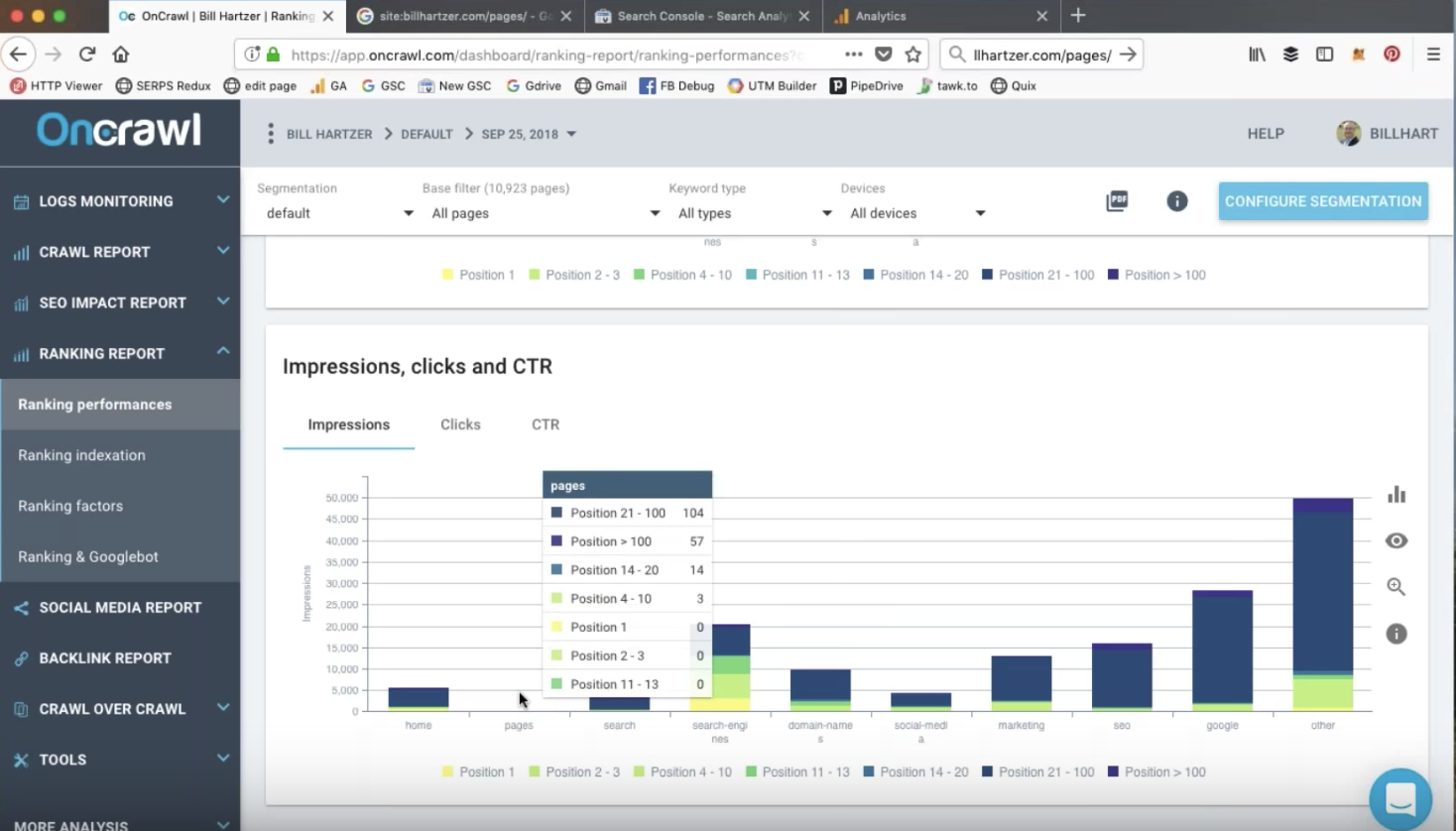

Impressions, CTRs et clics

La segmentation de votre site vous permet de confirmer, en un seul regard, quels types de groupes de pages sont classés et à quelles positions.

Dans cet audit, Bill utilise les métriques d’Oncrawl pour repérer les types de pages qui tendent à bien se classer. C’est le type de pages qu’il doit continuer à produire afin d’augmenter le trafic du site.

Les clics sur les pages classées sont fortement liées à la position de classement : les positions au-delà de 10 ne sont plus sur la première page des résultats de recherche. Le nombre de clics va donc chuter brusquement pour la plupart des mots-clés.

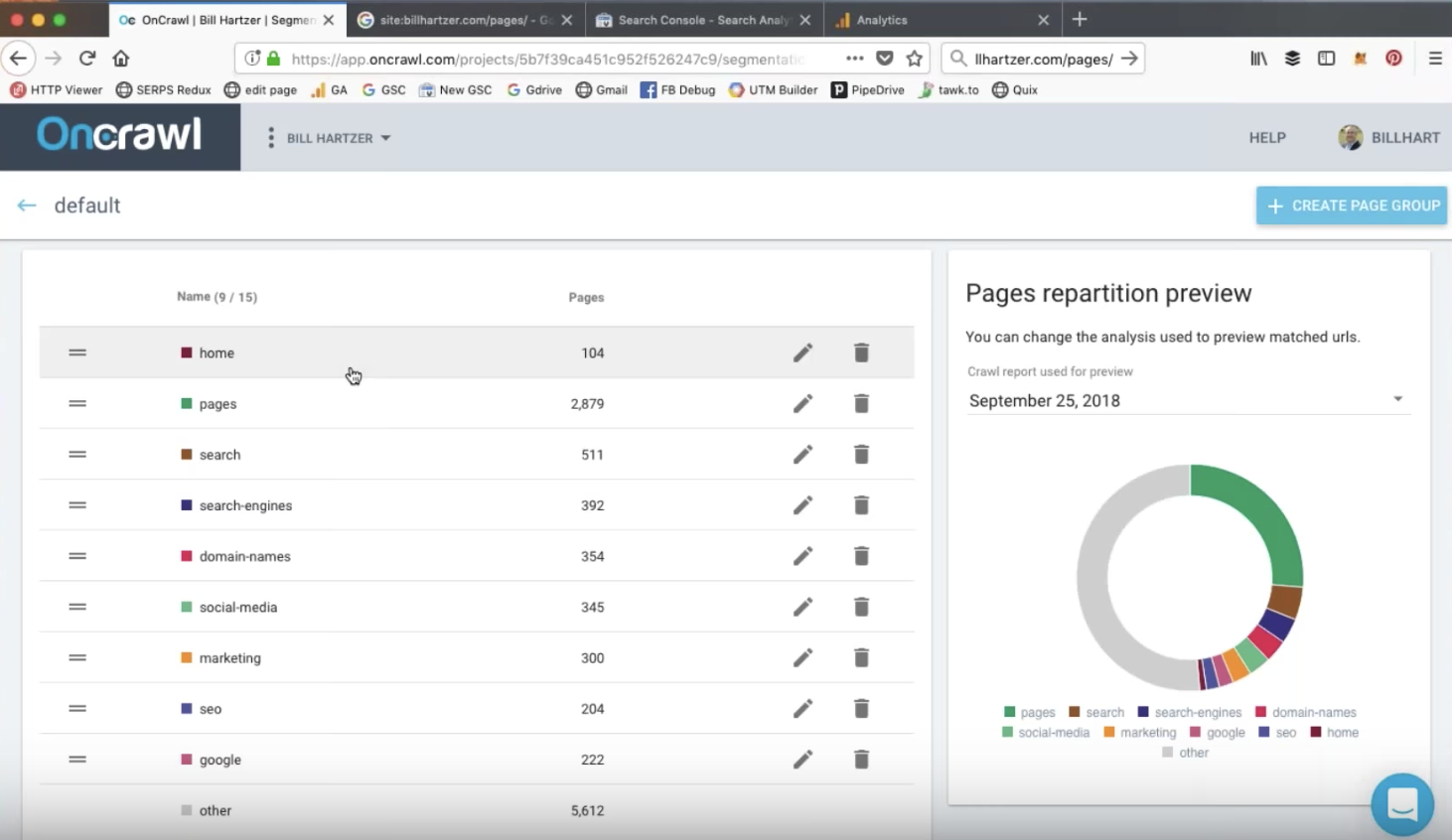

Segmentation d’un site web

La segmentation Oncrawl est une technique pour grouper vos pages dans des ensembles pertinents. Bien qu’une segmentation automatique soit fournie, vous pouvez éditer les filtres, ou créer vos propres segmentation. En utilisant les filtres Query Languages d’Oncrawl, vous pourrez inclure ou exclure les pages d’un groupe en vous basant sur différents critères.

Sur le site que Bill analyse dans le webinaire, la segmentation est basée sur les différents répertoires du site.

Les pages dans la structure > Crawlées > Classées > Actives

Dans le rapport Oncrawl Ranking, le graphique “Pages in structure > crawled > ranked > active” peut vous alerter des problèmes que rencontrent vos pages classées et visitées.

Ce diagramme vous montre :

- Les pages dans la structure : le nombre de pages qui peuvent être atteintes à travers les différents liens de votre site ;

- Crawlées : les pages que Google a crawlées ;

- Classées : les pages qui sont apparues dans les SERPs de Google

- Actives : les pages qui ont reçu des visites organiques.

Durant votre audit, vous voudrez comprendre les raisons qui ont causé des différences entre les barres du diagramme.

Cependant, les différences entre le nombre de pages dans la structure et le nombre de pages crawlées peuvent être intentionnelles. Par exemple, si vous empêchez Google de crawler certaines pages en interdisant les robots dans le fichier robots.txt. Vous devez être vigilants sur ce sujet lors de votre aduit.

Vous pouvez en savoir plus sur ces données dans Oncrawl, en cliquant sur le diagramme.

Points clés

Log files analysis helps you detect spikes in bot hits and monitor bots activity on a daily basis #oncrawlwebinar

Today’s webinar with @bhartzer pic.twitter.com/3DAC5d36j9— Oncrawl (@Oncrawl) September 25, 2018

Les principaux points clés de ce webinaire sont :

- Les grands changements dans la structure d’un site peuvent produire des variations dans l’activité de crawl.

- Les outils gratuits de Google rapportent des données qui sont agrégées, pondérées ou arrondies et qui peuvent être inexactes.

- Les fichiers de log vous permettent de voir le véritable comportement du bot et les visites organiques. Combinés avec les données de crawl et une surveillance quotidienne, ils représentent un outil puissant pour détecter des pics.

- Des données fiables sont nécessaires pour comprendre pourquoi et comment des changements se sont produits. Pour cela, il vous suffit de croiser les analyses d’analytics, de crawl, de classements et des données de logs extraites d’un outil comme Oncrawl.

Vous avez loupé le live du webinaire ? Regardez le replay !

Si vous n’avez pas eu la chance d’assister au live du webinar, ou si vous ne pouviez pas rester jusqu’à la fin, vous pouvez toujours regarder la version complète juste ici :