Savez-vous ce qui se passe sur votre site web chaque jour ? La première partie de la réponse à cette question qui viendrait spontanément à l’esprit serait d’utiliser des outils de suivi d’audience et de comportement. Beaucoup sont disponibles sur le marché: At Internet, Matomo, Fathom Analytics, Simple Analytics et bien d’autres qui représentent une alternative à Google Analytics.

Ils nous permettent d’avoir une bonne vision d’ensemble, mais l’éthique de ces outils, plus particulièrement Google Analytics, est remise une nouvelle fois en question.

Ce qui laisse penser qu’il existe d’autres sources de données qui ne sont pas suffisamment exploitées par tous les propriétaires de sites web: les logs.

Les outils d’analyse et la RGPD (focus Google Analytics)

Les données personnelles sont devenues un sujet sensible en France depuis la mise en vigueur du Règlement Général sur la Protection des Données (RGPD), création de la Commission nationale de l’informatique et des libertés (CNIL). La protection des données est devenue une priorité.

Alors, êtes-vous toujours “RGPD friendly” aujourd’hui ?

Si l’on regarde l’ensemble des sites web, beaucoup sont malins et détournent leur bandeau de récolte de données des utilisateurs (cookies), d’autres jouent le jeu à 100%.

À travers ces récoltes, des outils d’analyse de données nous permettent d’analyser d’où provient l’audience sur les pages et le comportement des visiteurs.

Ce genre d’analyses ont besoin d’un plan de taggage irréprochable pour récolter les données les plus fiables et précises possibles.

Les données récoltées sont le fruit de chaque mouvement, évènement sur un site.

Suite à des plaintes, la CNIL a décidé de mettre en demeure la solution de Google Analytics en la rendant illégale en France pour le moment. Une fois récoltée avec consentement, l’outil d’analyse d’audience fait l’état d’un manque d’encadrement sur le transfert des données personnelles vers les services de renseignement des États-Unis. Affaire à suivre.

Dans ce contexte, il serait intéressant de se focaliser sur la base historique d’un site. Plutôt simples à récupérer, ce sont les logs qui font ce travail.

Malgré un historique intéressant à analyser grâce aux logs, nous ne pourrons afficher de valeurs business ou le comportement réel d’un utilisateur sur votre site, tel que son parcours jusqu’à qu’il valide un panier ou quitte le site. L’aspect comportemental reste propre aux outils précédemment cités. Mis à part ça nous pouvons aller loin avec l’analyse des logs.

La connaissance des logs, une alternative à Google.

Qu’est-ce que sont les logs ? Ils désignent un type de fichier dont la mission principale consiste à stocker un historique des événements.

De quels genres d’événements parle-t-on ? Des visiteurs et des robots qui viennent chaque jour sur votre site.

La Google Search Console peut également le faire, mais pour plusieurs raisons, elle applique un filtre bien spécifique, notamment pour des raisons de confidentialité.

(Source : https://support.google.com/webmasters/answer/7576553. « Écarts entre la Search Console et d’autres outils ».)

Vous n’aurez donc qu’un échantillon de cette analyse. Avec les logs, vous avez accès à 100% des données !

L’analyse de ces lignes de logs vous permettra de prioriser des actions futures.

Voici quelques exemples de visite de robots différents passés sur le site de Oncrawl :

FACEBOOK :

66.220.149.10 www.oncrawl.com - [07/Feb/2022:00:18:35 +0000] "GET /feed/ HTTP/1.0" 200 298008 "-" "facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)"

SEMRUSH :

185.191.171.20 fr.oncrawl.com - [13/Feb/2022:00:18:27 +0000] "GET /infographie/mises-jour-2017-algorithme-google/ HTTP/1.0" 200 50441 "-" "Mozilla/5.0 (compatible; SemrushBot/7~bl; +http://www.semrush.com/bot.html)"

BING :

207.46.13.188 www.oncrawl.com - [22/Jan/2022:00:18:40 +0000] "GET /wp-content/uploads/2018/04/url-detail-word-count.png HTTP/1.0" 200 156829 "-" "Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)"

GOOGLE BOT:

66.249.64.6 www.oncrawl.com - [21/Jan/2022:00:19:12 +0000] "GET /product-updates/introducing-search-console-integration-skyrocket-organic-search/ HTTP/1.0" 200 73497 "-" "Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Attention, certaines visites de bots peuvent être fausses. Il faut bien penser à vérifier les IP pour savoir si ce sont de réelles visites de Googlebot, Bingbot etc. Derrière de faux user agent, il y a des professionnels qui lancent parfois des robots pour venir vérifier vos prix, vos contenus etc. Pour les reconnaître seul l’IP est utile !

Voici quelques exemples de visites d’internautes sur le site de Oncrawl :

En provenance de Google.com :

41.73.11x.xxx fr.oncrawl.com - [13/Feb/2022:00:25:29 +0000] "GET /seo-technique/predire-trafic-seo-prophet-python/ HTTP/1.0" 200 57768 "https://www.google.com/" "Mozilla/5.0 (Linux; Android 10; Orange Sanza touch) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.98 Mobile Safari/537.36”

En provenance de Google Ads grâce aux utm :

199.223.xxx.x www.oncrawl.com - [11/Feb/2022:15:18:30 +0000] "GET /?utm_source=sea&utm_medium=google-ads&utm_campaign=brand&gclid=EAIaIQobChMIhJ3Aofn39QIVgoyGCh332QYYEAAYASAAEgLrCvD_BwE HTTP/1.0" 200 50423 "https://www.google.com/" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.110 Safari/537.36"

De Linkedin grâce au referer :

181.23.1xx.xxx www.oncrawl.com - [14/Feb/2022:03:54:14 +0000] "GET /wp-content/uploads/2021/07/The-SUPER-SEO-Game-Building-an-NLP-pipeline-with-BigQuery-and-Data-Studio.pdf HTTP/1.0" 200 3319668 "https://www.linkedin.com/"

Pourquoi analyser le contenu des logs ?

Maintenant que l’on sait ce que contiennent concrètement les logs, que pouvons-nous faire avec ? Les analyser, comme n’importe quel alternative à Google Analytics.

Les bots ou robots

Ici, nous pouvons nous poser la question suivante : Quels sont les robots qui passent le plus de temps sur mon site internet ?

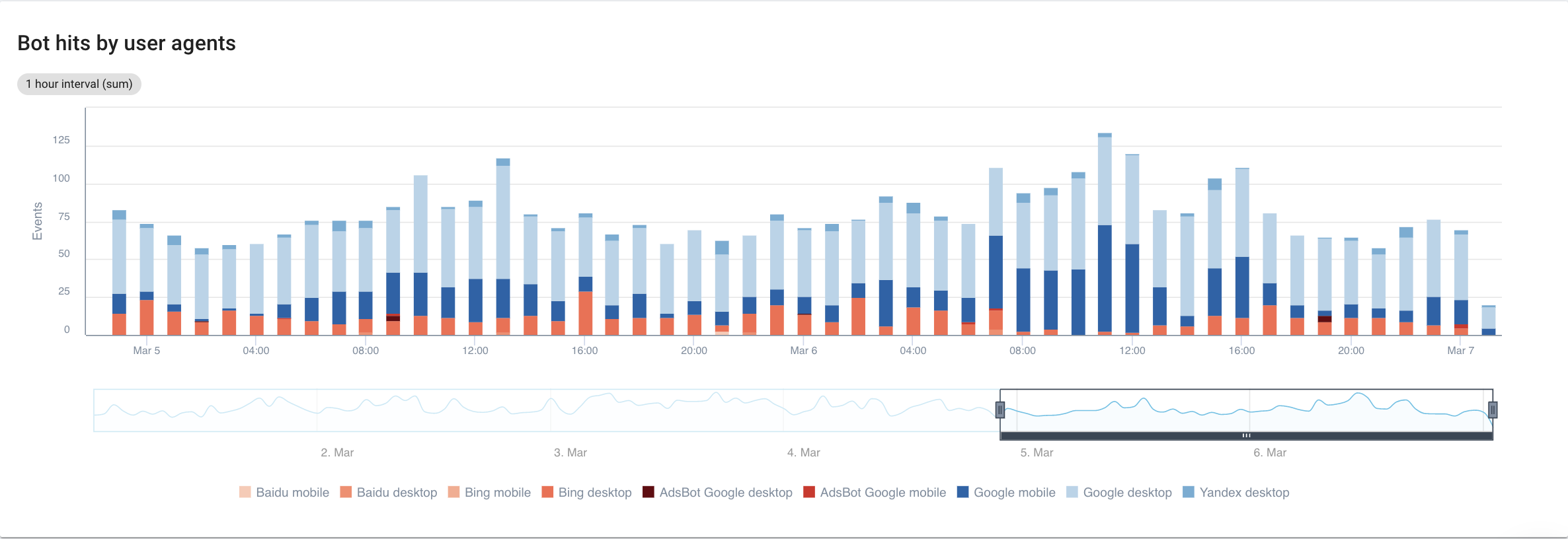

Si on se concentre sur les moteurs de recherche, avec une vue détaillée de chaque bot, voici que nous pouvons afficher :

Source : Oncrawl application

En clair, Google Mobile et Desktop passent beaucoup plus de temps que les bots de Bing ou Yandex. Googlebot a une part de marché supérieure à 90% au niveau mondial.

Si Google passe sur mes pages, sont-elles indexées ? Non, pas forcément.

Si nous retournons quelques années en arrière, Google avait ce vieux réflexe, d’indexer directement les pages après les avoir visitées. Aujourd’hui ce n’est plus le cas face au volume de pages qu’il doit traiter. Une bataille SEO se met alors en place autour du crawl budget.

Vous me direz, mais quel intérêt de savoir que tel ou tel bot passe plus de temps qu’un autre ?

Cela dépend déjà de l’algorithme de chacun des bots. Ils sont un peu différents parfois et ne reviennent peut-être pas pour les mêmes raisons.

Chaque moteur de recherche à son propre budget crawl qu’il partage en fonction de ces bots. Pour être plus clair, Google partage son budget de crawl avec l’ensemble de ces bots. Il est donc tout à fait logique de s’intéresser à ce que fait GooglebotAds. Surtout si nous avons des 404 qui trainent, les nettoyer c’est du budget de crawl optimisé au même titre que pour le SEO.

Croiser les données de Googlebot avec celle du Crawler Oncrawl

Pour aller plus loin dans l’analyse du comportement de Googlebot, Oncrawl croise les données de logs avec celles du crawl pour en tirer le meilleur.

L’idée est également d’affirmer ou d’infirmer des hypothèses liées à plusieurs KPIs comme la profondeur, le contenu, la performance etc.

Dans cette logique, posez-vous les bonnes questions :

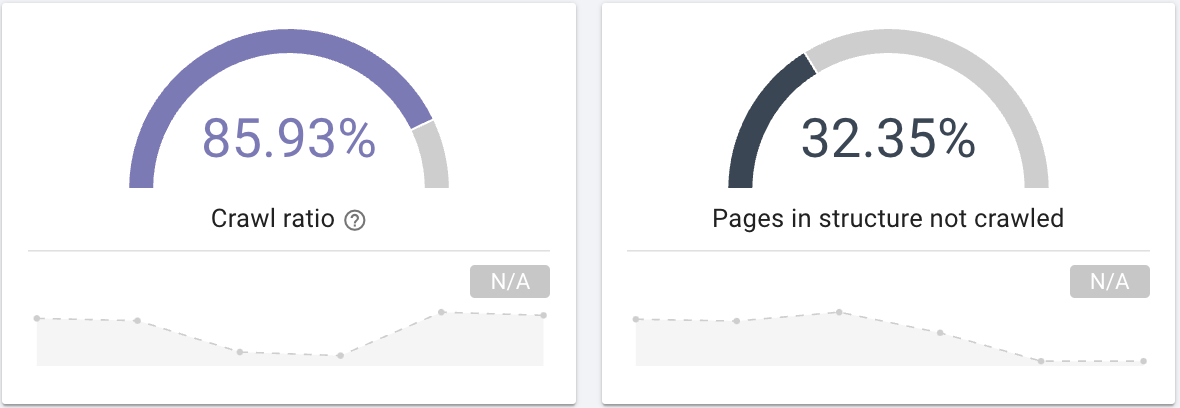

- Googlebot crawl-t-il toutes les pages de votre site ? Intéressez-vous au crawl ratio qui vous donne clairement cette information que vous pouvez par ailleurs filtrer avec une segmentation de vos pages.

Source : Oncrawl application

Source : Oncrawl application

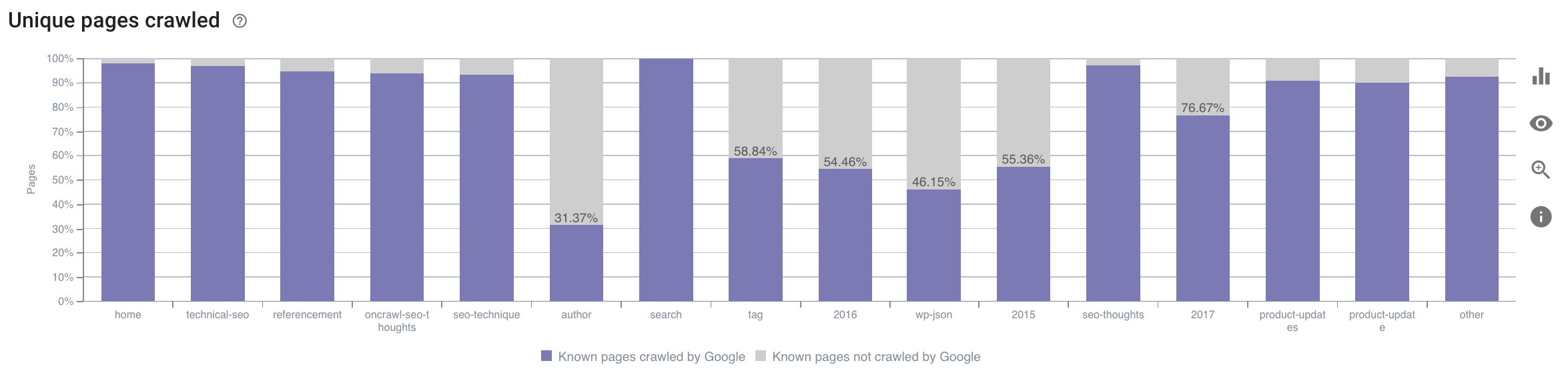

- Sur quelle catégorie Googlebot passe-t-il son temps ? Est-ce du budget de crawl optimal ? Ce graphique dans le SEO Impact Report d’Oncrawl croise les données et vous donne l’information.

Source : Oncrawl application

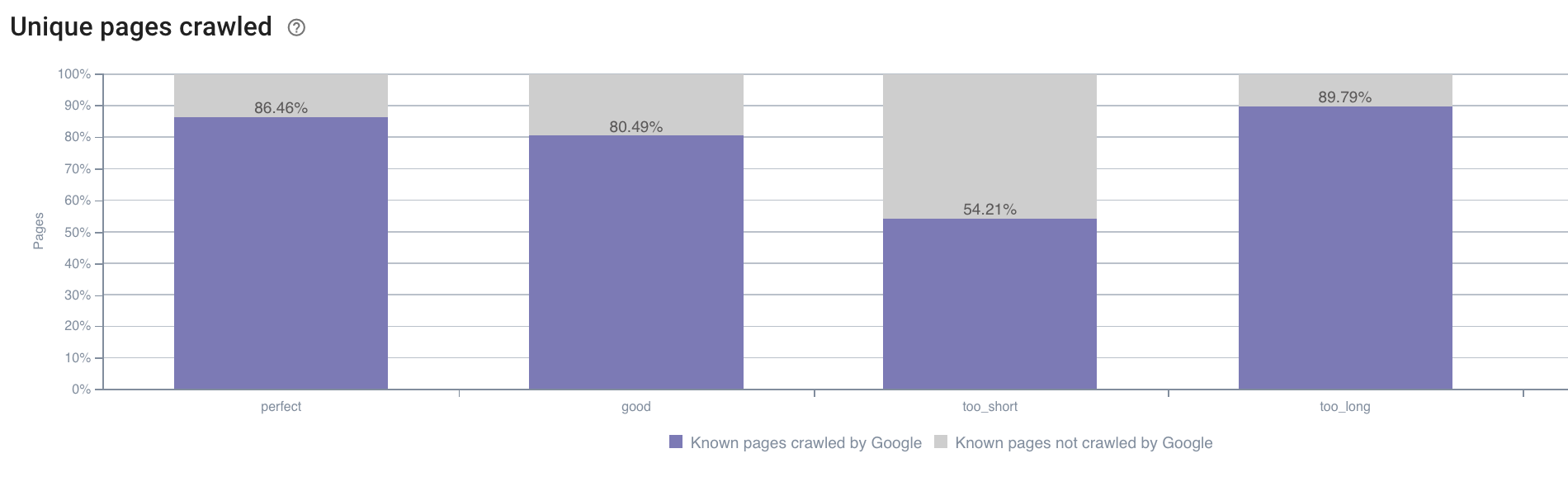

- Nous pouvons aussi avoir des idées en dehors de ce que propose par défaut Oncrawl. Par exemple, la longueur de la description a-t-elle un impact sur le comportement de Googlebot ? Nous avons la donnée à ce sujet grâce au crawl, nous pouvons donc l’utiliser pour créer une segmentation comme ci-dessous :

Source : Oncrawl application

Les descriptions trop courtes sont beaucoup moins crawlées que celles qui ont la taille idéale désignée en “perfect” ou “good” ici (entre 110 et 169 caractères).

Si la description répond aux critères de pertinences, de taille etc. Googlebot se fera un plaisir d’augmenter son budget de crawl sur les pages pertinentes.

Nota bene : celles qui sont considérées comme trop longues sont parfois réécrites par Google.

Analyser les visites d’un site web grâce aux logs

Ensuite, si nous prenons l’exemple du SEO, puisque c’est ce que nous cherchons à analyser avec Oncrawl, je vous propose de vous poser une autre question :

- Quelles corrélations entre le comportement de Googlebot et les SEO visites ?

Oncrawl dispose des mêmes graphiques pour croiser les données entre celles du crawl et des visites SEO récupérer dans les logs.

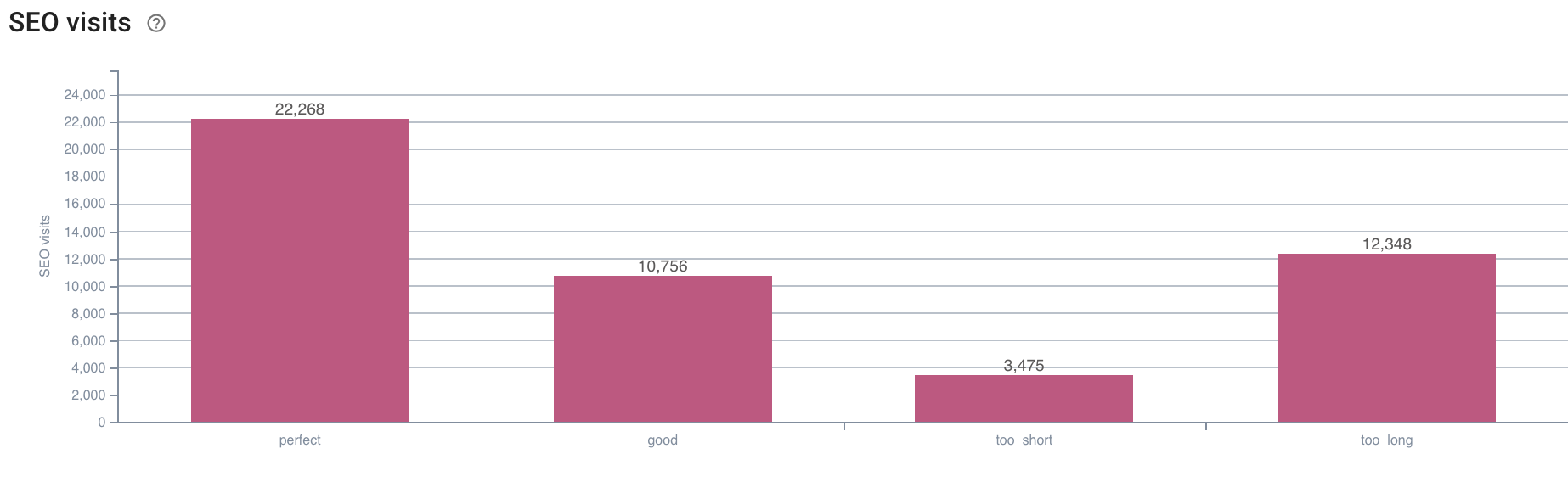

Source : Oncrawl application

Le constat est évident ici. Les pages qui ont une longueur de description “perfect” sont celles qui semblent générer le plus de SEO visites. Il faut donc concentrer ses efforts sur cet axe. En plus de “nourrir” Googlebot, les utilisateurs paraissent conquis par la pertinence de la description.

Ces constats peuvent-être fait pour de nombreux autres KPIs disponibles dans l’app. N’hésitez pas à vérifier vos hypothèses !

En résumé

Maintenant que vous connaissez la possibilité d’explorer ce qui se passe chaque jour sur votre site grâce aux logs, je vous invite à étudier les visites des internautes et des robots afin de trouver diverses opportunités d’optimisation. Elles peuvent être techniques ou liées au contenu. La bonne segmentation est la clef d’une bonne analyse.

Ce genre d’analyse n’est pas possible avec toutes les alternatives de Googles Analytics, mais leurs données peuvent être confondues également avec notre crawler. Avoir un maximum de données à notre disposition est aussi une bonne solution.

Pour donner encore plus de poids aux données de logs mixées à celle d’un crawl, il existe une étude qui regroupe 5 KPIs SEO liés aux logs sur les sites e-commerce menée par l’équipe d’Oncrawl.