Pour chaque site web, Google a un budget fixe pour le nombre de pages que ses robots peuvent et veulent parcourir. Internet étant un vaste espace, Googlebot ne peut pas passer plus de temps à explorer et à indexer les sites web. L’optimisation du budget de crawl est le processus qui consiste à s’assurer que les bonnes pages de nos sites se retrouvent dans l’index de Google et sont finalement montrées aux internautes.

Les recommandations de Google pour l’optimisation du budget de crawl sont plutôt limitées, car Googlebot parcourt la plupart des sites web sans atteindre ses limites. Mais les sites e-commerce comportant des milliers de pages de destination risquent de voir leur budget plafonné. Une étude de 2018 a même révélé que les crawlers de Google n’ont pas réussi à explorer plus de la moitié des pages web des grands sites utilisés lors de cette expérience.

Influencer la manière dont le budget d’exploration est dépensé peut être une optimisation technique plus difficile à mettre en œuvre pour les spécialistes SEO. Mais pour les sites d’entreprise et d’e-commerce, cela vaut la peine de maximiser le budget de crawl là où c’est possible. Avec quelques ajustements, les responsables des sites web et les spécialistes SEO peuvent aider Googlebot à indexer régulièrement leurs pages les plus performantes.

Comment Google détermine-t-il le budget de crawl ?

Le budget de crawl est essentiellement le temps et les ressources que Google est prêt à consacrer à l’exploration de votre site web. L’équation est la suivante :

Budget de crawl = taux de crawl + demande de crawl

L’autorité du domaine, les backlinks, la vitesse du site, les erreurs de crawl et le nombre de landing pages ont tous un impact sur le taux de crawl d’un site web. Les grands sites ont généralement un taux de crawl plus élevé, tandis que les petits sites, les sites plus lents ou ceux qui présentent un nombre excessif de redirections et d’erreurs de serveur sont généralement moins souvent crawlés.

Google détermine également le budget de crawl en fonction de la « demande de crawl ». Les URL populaires ont une demande de crawl plus élevée parce que Google veut fournir le contenu le plus récent aux utilisateurs. Google n’aime pas les contenus périmés dans son index, donc les pages qui n’ont pas été crawlées depuis un certain temps auront également une demande plus élevée. Si votre site web est soumis à une migration, Google augmentera la demande de crawl pour mettre à jour plus rapidement son index avec vos nouvelles urls.

Le crawl budget de votre site peut fluctuer et n’est certainement pas fixe. Si vous améliorez l’hébergement de votre serveur ou la vitesse de votre site, Googlebot peut commencer à crawler votre site plus souvent, sachant que cela ne ralentit pas l’expérience web des utilisateurs. Pour avoir une meilleure idée du taux de crawl moyen actuel de votre site, consultez le rapport de crawl de votre Google Search Console.

Tous les sites web doivent-ils se soucier de son crawl budget ?

Les petits sites web qui se concentrent uniquement sur le positionnement de quelques landing pages n’ont pas à se soucier de leur budget de crawl. Mais les sites plus importants, en particulier les sites avec un nombre excessif de pages brisées et de redirections, peuvent facilement atteindre leur limite de crawl.

Les types de grands sites web qui risquent le plus d’épuiser leur budget de crawl ont généralement des dizaines de milliers de pages de renvoi. Les grands sites d’e-commerce, en particulier, subissent souvent les effets négatifs des budgets de crawl. Je suis tombé sur de nombreux sites web dont un grand nombre de landing pages n’étaient pas indexées, ce qui signifie qu’elles n’ont aucune chance d’être positionnées dans Google.

Il y a plusieurs raisons pour lesquelles les sites d’e-commerce en particulier doivent accorder plus d’attention à la destination de leur crawl budget.

- De nombreux sites e-commerce créent par programmation des milliers de pages de renvoi pour leurs UGS ou pour chaque région ou pays où ils vendent leurs produits.

- Ces types de sites mettent régulièrement à jour leurs pages de renvoi lorsque des articles sont épuisés, que de nouveaux produits sont ajoutés ou que d’autres changements interviennent dans les stocks.

- Les sites e-commerce ont tendance à reproduire des pages (par exemple, des pages de produits) et des identificateurs de session (par exemple, des cookies). Ces deux types de sites sont perçus comme des urls à faible valeur ajoutée par Googlebot, ce qui a un impact négatif sur le taux de crawl.

Un autre défi pour influencer le budget de crawl est que Google peut l’augmenter ou le diminuer à tout moment. Bien qu’un sitemap soit une étape importante pour les grands sites web afin d’améliorer l’exploration et l’indexation de leurs pages les plus importantes, il ne suffit pas de s’assurer que Google ne maximise pas votre crawl budget sur des pages de moindre valeur ou peu performantes.

Comment peut-on optimiser leur budget de crawl ?

Bien que les propriétaires de sites puissent fixer des limites de crawl plus élevées dans leurs comptes Google Search Console, ce paramètre ne garantit pas une augmentation des demandes de crawl ni n’influence les pages que Google finit par explorer. Il peut sembler que la solution la plus naturelle consiste à faire en sorte que Google explore votre site web plus fréquemment, mais il existe des optimisations très limitées qui ont une corrélation directe avec l’augmentation du taux de crawl.

Nous savons tous qu’un bon budget ne consiste pas à augmenter vos limites de dépenses ; il s’agit d’être plus sélectif dans les dépenses que vous effectuez. Lorsque vous appliquez ce même concept au « crawl budget », cela peut donner d’énormes résultats. Voici quelques étapes stratégiques pour aider Google à dépenser votre budget à votre avantage.

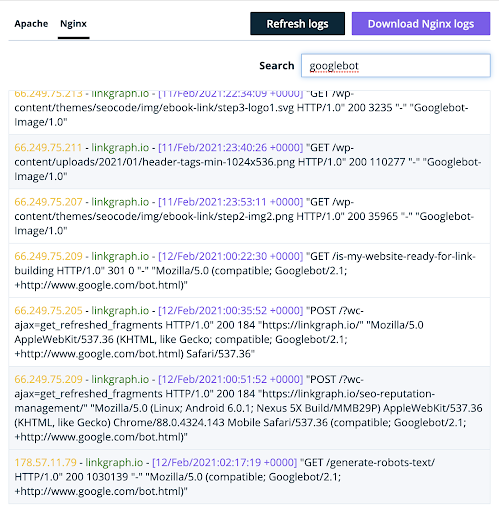

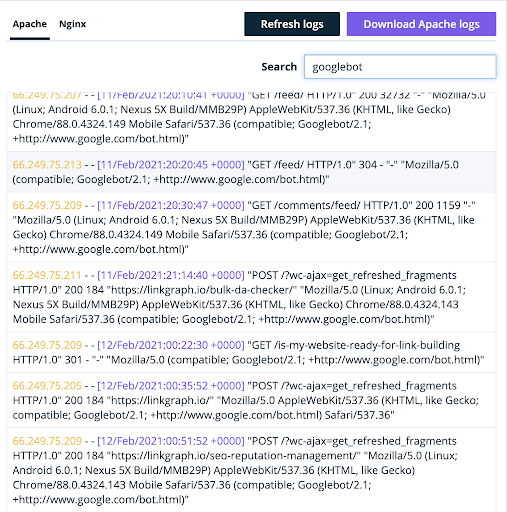

Étape 1 : Identifiez les pages que Google explore réellement sur votre site

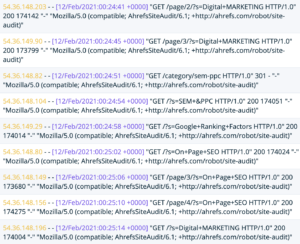

Jusqu’à récemment, le rapport de crawl de la Google Search Console indiquait uniquement aux propriétaires de sites le nombre de demandes de crawl reçues par leur site au cours d’une journée donnée. Bien que le nouveau « Crawl Stats » rapport de Google fournisse des informations beaucoup plus détaillées sur le crawl, le meilleur endroit pour comprendre comment Google crawle votre site se trouve toujours dans les fichiers de logs de votre serveur.

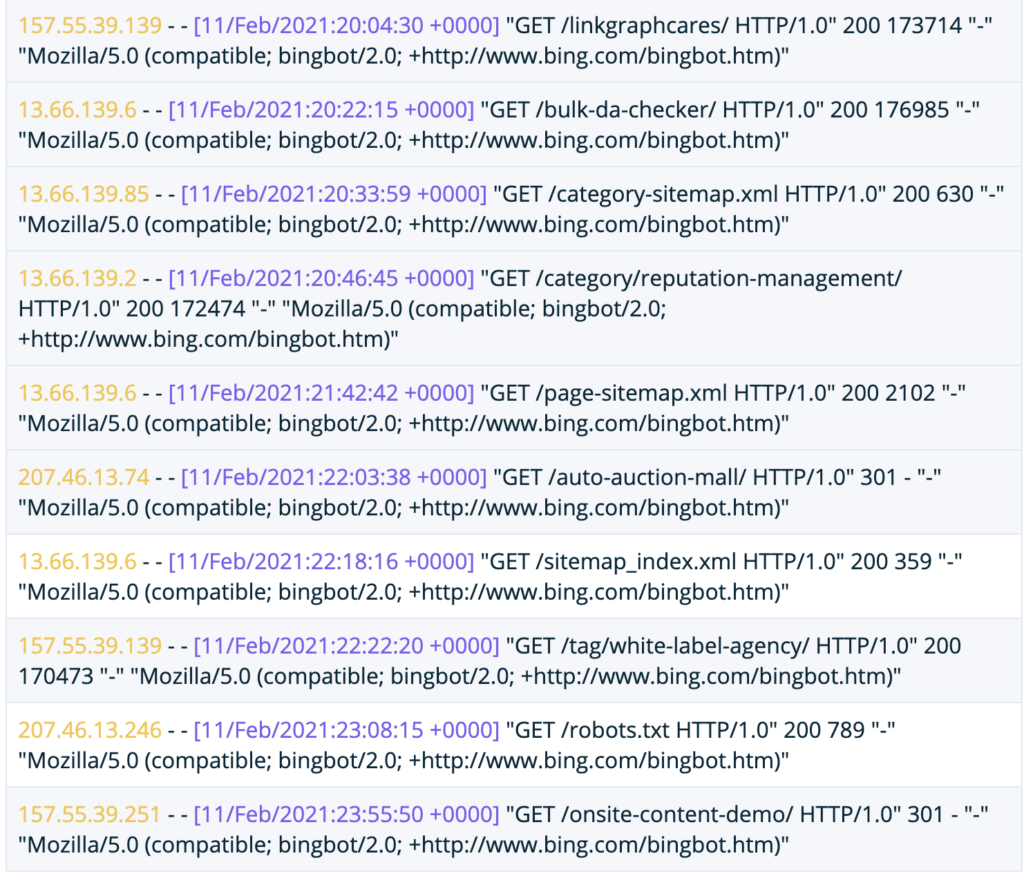

Lorsque Google visite votre site web, il utilise un user agent particulier. Cela permet à votre serveur de savoir que le trafic provient en réalité de Googlebot et non d’une personne réelle.

(Vous y trouverez également le bot de Bingbot et Ahrefs).

Oncrawl Analyseur de logs

Les propriétaires de sites qui analysent le contenu de ce fichier log obtiendront une foule d’informations sur le crawl budget de Google pour leur site. Le fichier révélera quelques éléments :

- Les pages que l’user agent visite

- Le nombre de pages parcourues par jour

- Si l’une des pages crawlées est en erreur 404 ou cassée

Idéalement, vous voulez que Google explore les pages de destination de votre site web qui sont optimisées pour les mots-clés les plus importants. De plus, les propriétaires de sites ne devraient jamais gaspiller leur crawl budget sur des pages en 404. Google Search Console ne vous montrera que certaines de vos erreurs 404, mais vous pouvez toutes les identifier dans les logs de votre serveur.

Une fois que vous avez des informations plus détaillées sur les pages de votre site web qui sont crawlées, effectuez les actions suivantes :

- Ajouter des balises meta robots : Si Googlebot parcourt ces pages 404 ou ces pages cassées, la priorité numéro un doit être l’ajout de balises meta robots [noindex, nofollow] pour empêcher Googlebot de parcourir et d’indexer ces pages.

- Ajustez votre sitemap : Si les logs de votre serveur révèlent que Google n’indexe pas vos pages potentiellement très performantes, placez-les plus haut dans votre sitemap pour vous assurer qu’elles sont indexées.

Étape 2 : Acceptez le fait que toutes vos pages ne doivent pas nécessairement être positionnées dans Google

La principale raison pour laquelle tant de sites web d’entreprise gaspillent leur budget de crawl est qu’ils permettent à Google d’explorer chaque page de destination de leur site. Beaucoup de sites web aiment même mettre toutes leurs pages dans leur application mobile pour que Google puisse les trouver et toutes les crawler. C’est une erreur, car en réalité, toutes nos pages ne seront pas positionnées.

Quel est l’intérêt d’avoir une landing page dans l’index de Google ? Positionnement et conversion. Si votre site web a des pages qui ne sont pas en mesure de se positionner pour plusieurs mots-clés ou de convertir les visiteurs du site en prospects et en revenus, pourquoi prendre le risque de laisser Google les crawler ?

Les entreprises et les propriétaires de sites e-commerce doivent savoir quelles sont les pages de leurs sites Web dont la conversion est optimisée et qui ont le plus de chances d’être positionnées et de convertir. Ensuite, ils doivent exploiter tous les avantages qu’ils peuvent pour s’assurer que Google consacre son crawl budget à ces pages très performantes.

Les pages de votre site web qui ont un fort potentiel de positionnement et de conversion valent la peine de dépenser du crawl budget. Voici quelques conseils pour vous assurer que Googlebot inclut ces pages dans votre budget.

- Réduisez le nombre de pages de votre sitemap. Concentrez-vous uniquement sur les pages qui ont réellement de bonnes chances d’être positionnées et d’obtenir un trafic organique.

- Supprimez les pages sous-performantes ou inutiles. Supprimez les pages qui n’apportent aucune valeur parce qu’elles n’ont pas de positionnement, de conversion ou d’utilité fonctionnelle.

- Éditez le contenu. Éliminez les pages qui ne reçoivent pas de trafic organique et redirigez-les vers d’autres pages de votre site qui sont pertinentes et qui reçoivent du trafic. Notez que les redirections absorbent une partie de votre budget de crawl, alors essayez de les utiliser avec parcimonie et ne les utilisez jamais deux fois de suite.

Il est difficile de se défaire de son contenu, mais il est beaucoup plus facile d’empêcher Google d’explorer certaines pages que d’obtenir de Google qu’il augmente son crawl budget global. Nettoyez votre site pour que les robots de Google aient plus de chances de trouver et d’indexer les meilleurs éléments est une priorité absolue si vous voulez dépenser votre budget de crawl de manière judicieuse.

Étape 3 : Utilisez les liens internes pour pousser les pages performantes aux crawlers de Google

Une fois que vous aurez identifié les pages que Google crawle, ajouté les balises meta robots nécessaires, supprimé ou édité les pages peu performantes et apporté des modifications à votre sitemap, les robots de Google seront plus enclins à dépenser leur budget sur les bonnes pages de votre site web.

Mais pour vraiment optimiser ce budget, vos pages doivent avoir ce qu’il faut pour se positionner. Les meilleures pratiques on-page SEO sont essentielles, mais une stratégie technique plus avancée consiste à utiliser votre structure de liens internes pour pousser ces pages potentiellement très performantes.

Tout comme Googlebot n’a qu’un budget limité pour le crawl, votre site web ne dispose que d’une certaine autorité basée sur son empreinte Internet. Il vous appartient de concentrer votre capital de manière intelligente. Cela signifie qu’il faut diriger l’autorité du site vers les pages qui ciblent les mots-clés pour lesquels vous avez de bonnes chances d’être positionné et vers celles qui vous apportent du trafic avec les bons types de clients, ceux qui sont susceptibles de convertir et qui ont une véritable valeur économique.

Cette stratégie SEO est connue sous le nom de PageRank sculpting. Si vous avez un grand site web avec des milliers de landing pages, un spécialiste aguerri peut mener des expériences SEO pour optimiser le profil de liens internes de votre site web pour une meilleure distribution du PageRank. Si vous êtes un nouveau site web, vous pouvez prendre une longueur d’avance en intégrant le PageRank sculpting dans l’architecture de votre site et en pensant à l’autorité du site à chaque nouvelle page que vous créez.

Voici deux de mes stratégies préférées pour analyser mes pages afin de déterminer lesquelles bénéficieraient le plus du PageRank sculpting.

- Trouvez les pages de votre site web qui ont un bon trafic mais qui n’ont pas assez de PageRank. Trouvez des moyens d’obtenir pour ces pages plus de liens internes et d’y envoyer plus de PageRank. L’ajout de ces liens dans l’en-tête ou le pied de page de votre site web est un excellent moyen de le faire rapidement, mais n’en faites pas trop dans votre menu de navigation.

- Concentrez-vous sur les pages qui comportent beaucoup de liens internes, mais qui ne génèrent pas beaucoup de trafic, d’impressions et se positionnent pour très peu de mots-clés. Les pages qui reçoivent beaucoup de liens internes contiennent généralement beaucoup de PageRank. Si elles n’utilisent pas ce PageRank pour apporter un trafic organique à votre site, elles le gaspillent. Il est préférable de déplacer ce PageRank vers des pages qui peuvent réellement faire la différence.

Comprendre le rôle que chaque lien sur votre site web joue non seulement dans l’envoi de Googlebot autour de votre site, mais aussi dans la répartition de votre jus de liens, est la dernière étape de l’optimisation du budget de crawl. Une bonne structure de liens internes peut entraîner une amélioration considérable du positionnement de vos pages les plus rentables. En fin de compte, la meilleure façon de dépenser votre crawl budget est d’utiliser les landing pages qui sont les plus susceptibles de vous rapporter de l’argent.

Une fois que vous aurez mis en œuvre vos changements, surveillez le positionnement par mot-clé de ces pages améliorées avec Google Search Console. Si le positionnement s’améliore pour ces pages, cela montre que l’optimisation de votre budget de crawl fonctionne. Ensuite, lorsque vous ajoutez de nouvelles pages à votre site web, soyez plus sélectif pour savoir si elles méritent ou non de consommer votre crawl budget. Si ce n’est pas le cas, continuez à diriger les crawlers uniquement vers les pages qui travaillent le plus pour votre marque.