Chhhuuut.. J’ai un secret pour vous!

Votre site a un « budget de crawl » fixé par Google.

C’est la donnée secrète utilisée par Google pour mesurer deux choses :

- La façon dont votre site est construit.

- La popularité de votre site.

Cet article se concentrera sur le premier point uniquement.

Améliorer la qualité de construction de votre site augmentera votre budget de crawl.

Plus votre budget de crawl sera important, plus Google s’arrêtera fréquemment pour crawler vos pages.

Commençons par définir ce qu’est un budget de crawl.

Qu’est-ce que le budget de crawl ?

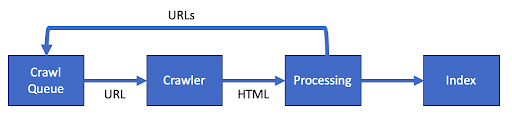

Google utilise un logiciel spécial appelé crawler (ou araignée) pour analyser les pages de votre site. Ils l’appellent, Googlebot.

Le budget de crawl est le terme utilisé pour décrire la fréquence à laquelle le Googlebot explore vos pages et en optimisant votre site, vous pouvez augmenter votre budget de crawl.

Google explique que votre budget de crawl est une combinaison de plusieurs choses :

- Taux de crawl : La vitesse à laquelle le Googlebot peut explorer votre site sans endommager vos serveurs.

- Les demandes de recherche : L’importance de votre page web pour les utilisateurs de Google.

Au fur et à mesure que ces élements s’améliorent, vous verrez le Googlebot vous rendre visite plus souvent.

Une fois que Google a parcouru une page, il ajoute le contenu à son index. Celui-ci met alors à jour les informations affichées dans les résultats de recherche.

En optimisant pour le budget de crawl, vous pouvez améliorer la vitesse des mises à jour de votre site.

[Étude de cas] Gérer le crawl du robot de Google

Pourquoi vous devriez améliorer votre Crawl Budget ?

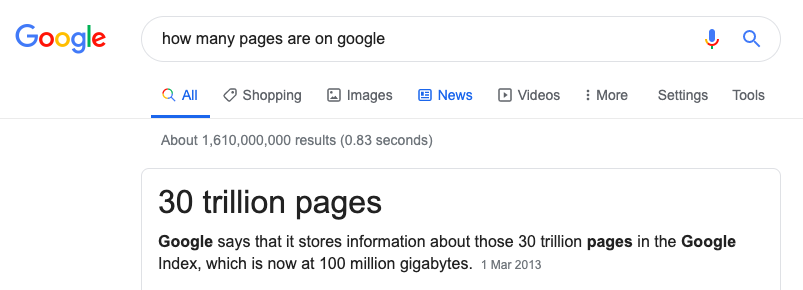

Le travail de Google n’est pas aisé.. Ils doivent explorer et indexer chaque page d’Internet.

L’énergie nécessaire pour faire cela est énorme et ils ne peuvent pas indexer chaque page. L’optimisation de votre budget de crawl donnera à votre site la meilleure chance d’apparaître dans les recherches.

Comment améliorer votre budget d’indexation ?

Améliorer un site consiste à optimiser de façon efficace chacune des visites du Googlebot.

Ce qu’il faut éviter :

- Que le GoogleBot crawl des pages que nous ne voulons pas.

- Que le GoogleBot voit des erreurs sur le serveur.

- Que le GoogleBot suivent des liens brisés / morts.

- Que le GoogleBot ait besoin d’attendre le changement des pages.

- Que le GoogleBot crawl du contenu dupliqué.

Tout ce qui précède est un gaspillage des ressources Google et le budget de crawl se verrait considérablement amoindri.

Budget prévisionnel et SEO technique

Une grande partie de ce que vous devez faire dans le cadre du référencement technique est identique à l’optimisation du budget de crawl.

Vous avez besoin :

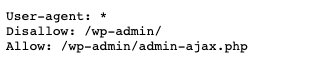

- D’optimiser le fichier robots.txt et vérifier les erreurs.

- De corriger toutes les balises hreflang et liens canoniques.

- De résoudre les problémes des pages qui renvoient un code autre que 200.

- Corriger les redirections et des boucles de redirection.

- S’assurer que les sitemaps sont exempts d’erreurs.

Ensuite, voyons comment créer la page parfaite pour Googlebot.

[Étude de cas] Gérer le crawl du robot de Google

Comment créer la page parfaite

D’accord, le titre était peut-être trop ambitieux mais l’objectif sera d’améliorer la page autant que possible.

Prenons quelques exemples que vous pouvez rencontrer.

Les conflits de page

- Contenu dupliqué : Marquez tout contenu dupliqué sur votre site avec une balise de lien canonical.

- Pages non-SSL : Trouvez tout lien HTTP et convertissez-les en HTTPS. Si vous n’avez pas de certificat SSL, obtenez-en un gratuitement chez Let’s Encrypt.

- Crawler uniquement que les pages utiles : Utilisez votre fichier robots.txt pour réduire les endroits où le Googlebot peut aller. Par exemple, si vous avez des pages utilisées pour un administrateur, désactivez cette option dans votre fichier robots.txt.

- Contenu pauvre : Envisagez de bloquer le crawl des pages à contenu « pauvre ». Si vous avez des pages qui ont peu de valeur pour un utilisateur, alors ne faites pas perdre de temps au Googlebot sur ces pages.

- Erreurs de serveur : Les erreurs de serveur sont le signe d’un serveur web non optimal. Si votre site renvoie 5xx erreurs, la correction de celles-ci peut augmenter le taux de crawl.

Un long chargement des pages

Une façon d’améliorer le budget de crawl est d’améliorer la vitesse des pages.

Des pages rapides rendent le Googlebot plus efficace et renvoi une image saine de votre site à Google.

À de plusieurs reprises, Google a mentionné que la vitesse des pages augmente le taux de crawl :

Rendre un site plus rapide améliore l’expérience des utilisateurs tout en augmentant le taux de crawl.

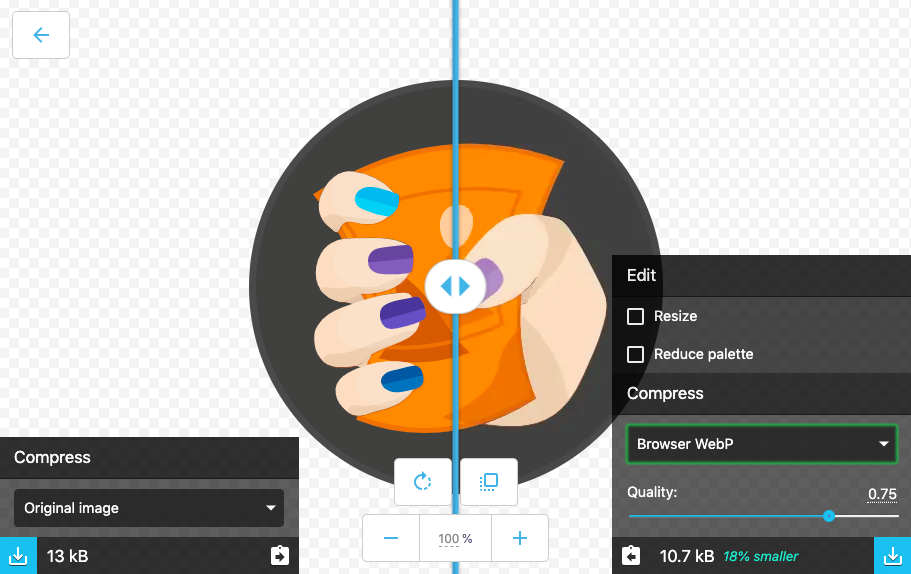

- Poids de la page : Cette mesure est la taille globale de votre page. Cela inclut toutes les CSS Javascript et les images de la page. Il devrait être inférieur à 1 mb au total.

- Images optimisées : Les images doivent être aussi petites que possible en Ko sans perdre en qualité. L’utilisation d’un outil comme Squoosh peut vous aider à cet égard.

- CSS et JS réduits : Réduisez vos fichiers JS et CSS. C’est le processus qui consiste à supprimer tous les caractères inutiles du fichier. Utilisez CSSNano et UglifyJS pour réduire les fichiers.

- Compression et mise en cache : Assurez-vous de la compression GZip ou BR sur le serveur. Cela va accélérer le temps nécessaire pour obtenir un fichier. Ajoutez la mise en cache pour que le fichier ne soit téléchargé qu’une seule fois.

Pour une liste des améliorations, consultez cette étude. Elle comporte 30 étapes pour améliorer les performances d’un site web.

Méthode pour mesurer vos changements

En tant que SEO intelligent, vous savez que avant de commencer toute optimisation que vous devez suivre les changements.

Vous devez choisir une donnée avec deux propriétés :

- Vous devez être capable de suivre cette donnée dans le temps.

- Vous devez être capable d’influencer cette donnée avec vos actions.

Alors, quelle donnée devons-nous suivre pour le budget de crawl ?

Nous avons dit précédemment que Google utilise deux facteurs pour définir le budget :

- Le taux de crawl : La vitesse à laquelle Googlebot peut explorer votre site sans endommager vos serveurs.

- Demande de recherche : L’importance de votre page web pour les utilisateurs de Google.

Puisque nous sommes des SEO techniques, notre travail est d’améliorer le taux de crawl.

C’est donc sur quoi nous devons nous pencher.

Suivi du taux de crawl

Alors comment on suit le taux de crawl des Googlebot ?

Vous devez utiliser les logs de votre serveur web.

Les logs stockent toutes les requêtes faites à votre serveur. Chaque fois qu’un utilisateur ou Googlebot visite votre site, une entrée de journal est ajoutée au fichier d’accès log.

Voici à quoi ressemblerait une entrée pour du Googlebot :

127.0.0.1 - - [11/Nov/2019:08:29:01 +0100] "GET /example HTTP/1.1" 200 2326 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Il y a trois points importants dans chaque log.

La date :

[11/Nov/2019:08:29:01 +0100]

L’URL :

« GET /example HTTP/1.1 »

Le user-agent qui nous dit que le Googlebot a fait la demande :

"Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Le log ci-dessus provient d’un serveur web Nginx. Mais, tous les serveurs web tels qu’Apache ou IIS auront une entrée de log similaire. Selon votre configuration, vous pouvez avoir un Content Delivery Network (CDN). Un CDN tel que Cloudflare ou Fastly créera également des accés aux logs.

Analyser un journal de logs n’est pas le plus amusant bien que cela soit possible.

Vous pouvez télécharger le fichier access.log et l’analyser à l’aide d’Excel. Cependant, je vous recommande d’utiliser un analyseur de logs tel que celui d’Oncrawl.

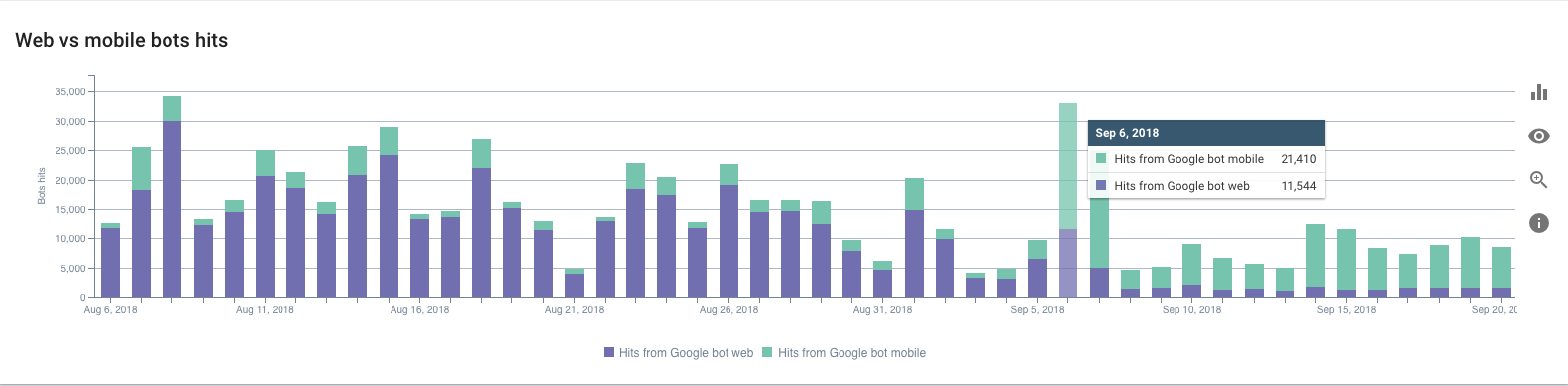

Cela vous permettra de voir le taux de crawl du Googlebot sur un graphique et en temps réel.

Une fois que vous avez cette configuration de surveillance pour suivre le taux de crawl, vous pouvez commencer à l’améliorer.

Apporter des modifications

Maintenant que nous savons ce que nous suivons, nous pouvons envisager d’apporter certaines améliorations. Mais, ne faites pas beaucoup de changements en même temps. Soyez méthodique et faites les changements un par un.

Construisez, mesurez, apprenez.

Grâce à cette technique, vous pouvez adapter les changements que vous faites au fur et à mesure que vous apprenez. Concentrez-vous sur les tâches qui améliorent le taux de crawl.

Si vous vous précipitez et changez trop de choses à la fois, il peut être difficile de comprendre les résultats.

Avec le temps, alors que la page s’améliore, vous verrez une augmentation du budget de crawl et par definiton, un accroissement du taux de crawl.

Récapitulons

Nous avons expliqué en détail ce qu’est un budget de crawl.

En tant que SEO technique, vous avez le pouvoir d’améliorer le taux de crawl du site.

En améliorant la santé technique, vous pouvez optimiser le passage du Googlebot.

Suivez le taux de crawl en utilisant vos logs pour des résultats précis.

Utilisez la technique « Construire, Mesurer, Apprendre » pour faire uniquement un changement à la fois et améliorer votre site petit à petit.

Avec le temps, votre taux de crawl augmentera. Vos pages apparaîtront plus rapidement dans les résultats de recherche Google et les utilisateurs auront une excellente expérience sur votre site.