Votre équipe en charge des contenus a une responsabilité principale : créer du contenu qui génère des résultats. Leur travail exige un mélange de créativité et de logique, la recherche des bons mots pour éduquer et persuader votre public, et l’utilisation des bonnes données pour optimiser le contenu en vue des performances.

En tant que responsable marketing, il serait difficile de demander à vos créateurs de contenu d’être également responsables de votre SEO technique. Le SEO technique nécessite une compréhension approfondie du développement web, une compétence complexe à maîtriser par soi-même.

Si vous ne pouvez pas demander à vos créateurs de contenu d’optimiser votre SEO technique, ils doivent malgré tout en comprendre les bases. Il est ainsi beaucoup plus facile pour votre équipe contenus de communiquer avec vos développeurs web et d’augmenter les performances de ce qu’ils produisent.

Examinons les bases du SEO technique que votre équipe de rédacteurs doit maîtriser afin de comprendre comment leur contenu parfaitement rédigé peut gagner encore plus de lecteurs organiques.

Qu’est-ce que le SEO technique ?

De façon basique, le SEO technique est l’aspect technique du SEO – il englobe toutes les tâches qui nécessitent des connaissances en matière de développement web, de fonctionnement des sites web et de la manière dont Google les explore et les indexe.

Pour être plus précis, le SEO technique comprend toute optimisation que vous effectuez pour aider Google à explorer et indexer correctement vos pages web.

Crawler et indexer

Toutes les pages web qui apparaissent dans les résultats de Google (également appelées SERPs, ou pages de résultats de moteurs de recherche) doivent d’abord exister dans l’index de Google. Cet index est le « répertoire » dans lequel Google répertorie toutes les pages qu’il analyse lors du positionnement d’une liste de pages pour une requête tapée dans le champ de recherche.

Avant de pouvoir ajouter une page dans leur index, les robots de Google – les algorithmes qu’ils utilisent pour analyser une page web – doivent pouvoir y accéder. Comme l’explique le support de Google :

« Il n’y a pas de registre central de toutes les pages web, donc Google doit constamment rechercher de nouvelles pages et les ajouter à sa liste de pages connues. Une fois que Google découvre l’URL d’une page, il la visite ou l’explore pour savoir ce qu’elle contient. »

En d’autres termes, le crawling est la capacité des robots de Google à scanner une page ; l’indexation vient plus tard.

La première étape d’une mise en œuvre technique correcte du SEO consiste à s’assurer que votre site web est « crawlable », c’est-à-dire que Google devrait être capable de crawler toutes les pages de votre site.

Il existe de nombreuses raisons pour lesquelles un site ou une page ne serait pas crawlable, notamment :

- Le serveur est hors service

- L’URL est cassée

- Il y a un problème de chargement du site/de la page

- Aucune autre page n’y renvoie

Certains types de problèmes de crawl ont tendance à être rares car ils sont relativement faciles à repérer. Néanmoins, vous ne devez jamais négliger le crawl dans votre analyse : d’autres problèmes peuvent être difficiles à trouver, comme les pages orphelines que vous avez créées mais que Google ne peut pas trouver, les pages qui sont redirigées en boucle ou les parties d’un site qui peuvent potentiellement créer un nombre infini de pages à explorer par Google, comme des archives de plusieurs années sans contenu.

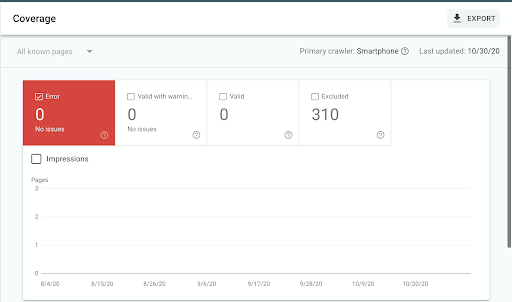

Pour trouver des problèmes de crawl, vous pouvez utiliser la Google Search Console, qui fonctionne comme le représentant de Google pour votre site web : en cas de problème technique, la GSC (comme on l’appelle) vous aidera.

Dans GSC, allez dans « Coverage Report » et vérifiez la colonne « Errors ».

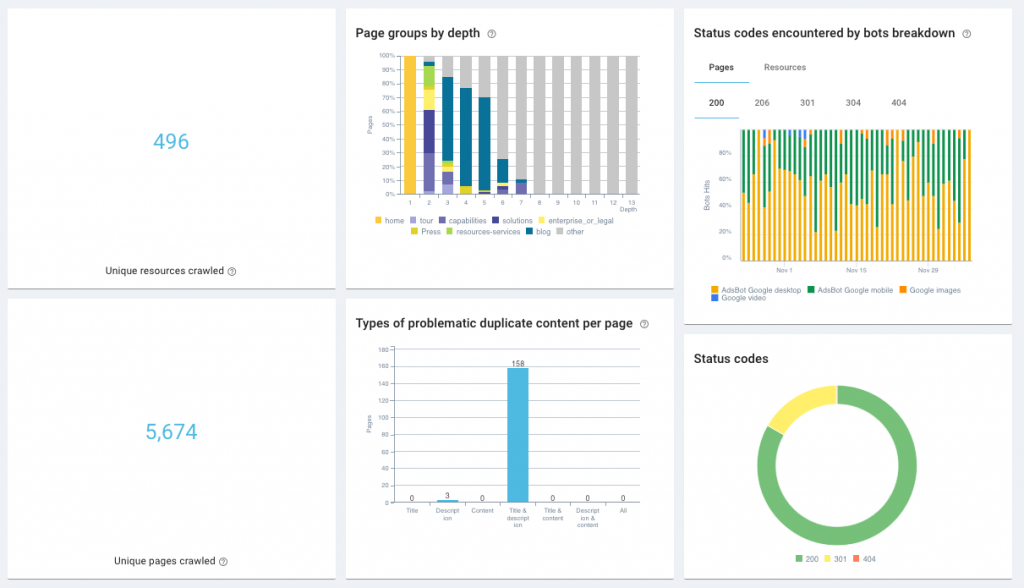

Vous pouvez vérifier les problèmes d’indexation en utilisant un outil de SEO qui comprend un crawler SEO, comme Oncrawl. Les crawlers SEO vous diront quand ils rencontrent des problèmes 5xx ou 4xx (ces chiffres bizarres font référence à leur code de statut – par exemple, une erreur 404 se produit quand une page ne peut pas être atteinte ou trouvée).

Oncrawl SEO Impact Report

Oncrawl SEO Impact Report

Oncrawl Health Dashboard

Oncrawl Health Dashboard

Une fois que Google a parcouru une page, il ne l’indexe pas immédiatement. L’indexation se produit lorsque Google décide d’ajouter une page à son index, le même index qu’il consulte lorsqu’il positionne une page pour les SERPs. Comme ils le déclarent:

« Google analyse le contenu de la page, catalogue les images et les fichiers vidéo intégrés à la page, et essaie de comprendre la page. Ces informations sont stockées dans l’index Google, une énorme base de données stockée dans de très nombreux (très nombreux !) ordinateurs. »

Pour être clair : toute page que les robots de Google peuvent parcourir sera parcourue, alors que nous ne pouvons pas en dire autant de l’indexation. Pour indexer une page, vous devez indiquer clairement que Google doit le faire. Voici comment faire :

- Évitez toute erreur de serveur. La meilleure façon de faire indexer une page est de s’assurer qu’elle est explorée en premier lieu. La meilleure façon d’y parvenir est d’éviter les erreurs de serveur. Vérifiez le rapport de couverture de la GSC, comme indiqué précédemment.

- Ajoutez des liens internes. Toutes vos pages doivent comporter au moins un lien vers l’une d’entre elles. Utilisez un texte d’ancrage pertinent qui décrit correctement le contenu de la page (par exemple, si je devais créer un lien vers ce billet, j’utiliserais le texte d’ancrage SEO technique).

- Créez et téléchargez un sitemap XML. Ils sont comme des brochures que vous utilisez pour présenter les pages de votre site aux robots de Google. Selon un ingénieur de Google, les sitemaps XML sont la « deuxième source la plus importante » pour trouver des URL – les liens internes semblent être la première.

- Évitez d’indiquer à Google de se tenir à l’écart de la page. Il peut s’agir d’instructions pour ne pas explorer la page dans le guide des robots du site, du fichier robots.txt ou des attributs « nofollow » sur les liens pointant vers la page.

- Assurez-vous que vous ne demandez pas à Google d’indexer une autre page. Les pages peuvent suggérer à Google qu’une autre page serait un meilleur choix pour indexer le même contenu, comme nous le verrons plus tard. Il peut envoyer à Google une page différente avec une redirection, ou il peut aussi dire directement à Google de ne pas l’indexer avec une balise « noindex ». Les pages qui font tout cela ne sont pas considérées comme indexables.

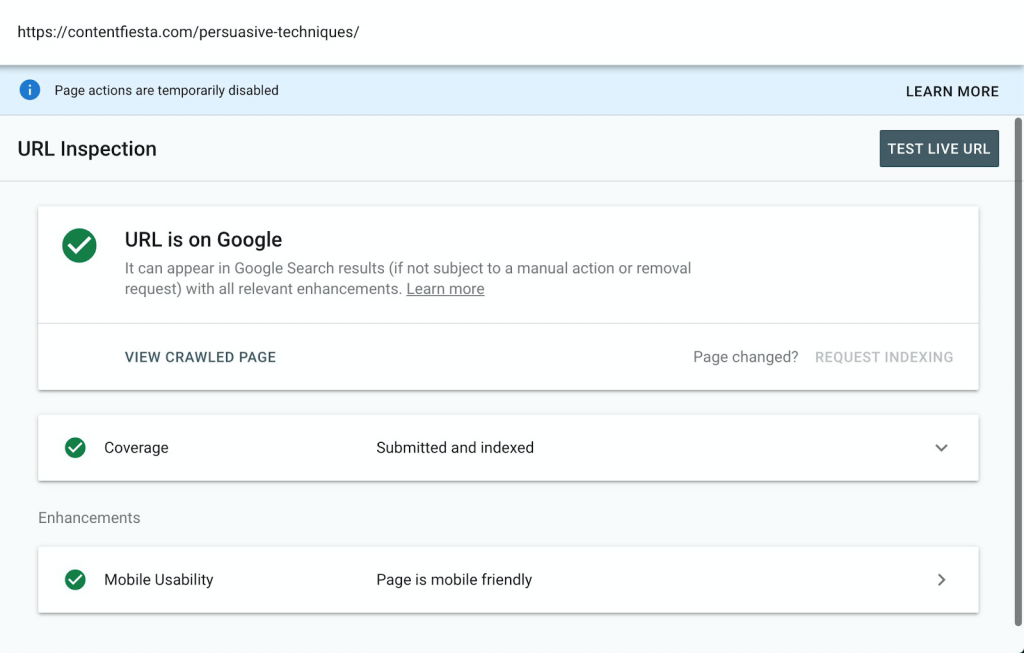

Pour garantir l’indexabilité de votre page, utilisez l’outil d’inspection des URLs de la GSC:

Une fois que Google a indexé une page que vous souhaitez activement positionner, vous pouvez y aller. Mais il y a de nombreux cas où vous ne voudriez pas que Google indexe vos pages.

- Vous disposez d’informations sensibles que personne en dehors de votre entreprise ne doit voir

- Vous avez plusieurs versions d’une page que vous voulez que Google ignore (plus tard, vous verrez à quoi cela ressemble quand on parlera d' »URLs canoniques »)

- Vous ne voulez pas diluer l’autorité de votre domaine en indexant des pages non pertinentes, par exemple, vos conditions de confidentialité

Lorsque vous désindexez volontairement une page, vous utilisez la puissance de Google de façon positive. Si vous le faites inconsciemment, les performances de votre site s’en trouveront considérablement diminuées.

Le reste de ce guide aborde trois sujets qui affectent directement ou indirectement le crawling et l’indexation de votre site.

Structure du site

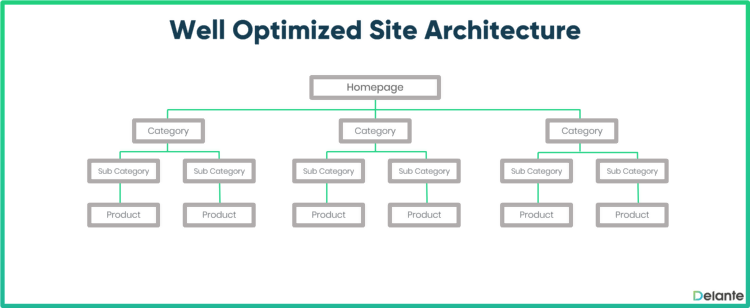

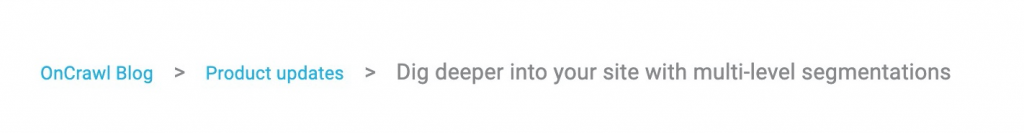

La structure de votre site fait référence à la façon dont vous planifiez et organisez vos pages. Toutefois, il ne s’agit pas de vos menus, mais plutôt de la structure créée par les liens d’une page à l’autre. Les spécialistes du SEO appellent souvent cela « l’architecture de site » parce que vous définissez la disposition des différentes parties de votre site, la façon dont elles sont liées les unes aux autres et comment elles soutiennent toutes votre site.

De nombreux problèmes de crawling et d’indexation surviennent lorsque Google ne peut pas accéder à une page ou l’indexer en raison d’une structure de site inefficace ; des sites dont les différentes parties sont enchevêtrées de manière incohérente et compliquée. Pour résoudre ce problème, une théorie de l’architecture SEO des sites utilise la règle empirique suivante : un site ne doit pas avoir plus de trois ou quatre couches.

Une structure de site aussi simple signifierait qu’à partir de votre page d’accueil, vous pourriez cliquer sur une page de blog à partir de votre page d’accueil et ensuite sur un billet de blog rédigé par votre équipe de contenu. Vous pourriez cliquer sur d’autres articles ou pages (par exemple, votre page de contact), mais tous pourraient aussi être accessibles en moins de trois ou quatre clics en partant de la page d’accueil. Un site de commerce électronique peut également comporter une page d’accueil, une page de catégorie et une page de produits (les paniers de caisse ne sont pas indexés, donc ils ne comptent pas).

Ces structures de site simples sont appelées « plates » en raison de leur apparence, comme vous l’avez vu dans l’image ci-dessus. Que votre site comporte deux, trois ou quatre couches, vous voulez un site facile à parcourir, tant pour vos visiteurs que pour le robot de Google.

Selon Google, « La navigation d’un site web est importante pour aider les visiteurs à trouver rapidement le contenu qu’ils souhaitent. Elle peut également aider les moteurs de recherche à comprendre quels sont les contenus que le webmaster juge importants ».

Pour avoir une idée de la structure de votre site, effectuez un audit du site avec Screaming Frog ou Oncrawl.

Si vous trouvez que la structure de votre site comporte trop de couches et de sections déroutantes, vous devez repenser votre structure avec l’aide de votre équipe technique et d’experts SEO professionnels. Vos créateurs de contenu n’ont peut-être pas besoin de participer à la discussion, mais il est important qu’ils sachent pourquoi ce sujet est important : si le contenu qu’ils créent se trouve trop loin dans l’architecture, ou n’en fait pas partie du tout, il ne sera pas indexé.

[Ebook] Le technical SEO pour les esprits non techniques

Optimisation de la vitesse

La vitesse est l’un des facteurs les plus critiques qui affectent l’expérience des utilisateurs (UX) et les positionnements. Par « vitesse », j’entends le temps qu’il faut à un navigateur pour récupérer les données d’un site web sur un serveur, créer la page et l’afficher.

Chaque page comporte des dizaines, voire des centaines d’éléments qu’un navigateur doit récupérer pour charger une page. La façon dont un navigateur charge ces éléments définit la vitesse de votre site ; plus le temps nécessaire au chargement des éléments de votre site est long, plus la vitesse de votre page est lente.

L’optimisation de la vitesse de votre site est l’une des modifications techniques les plus importantes que vous pouvez apporter en matière de SEO. Les modifications les plus courantes et, le plus souvent, les plus efficaces que vous pouvez apporter à l’optimisation de la vitesse sont:

- Compression et réduction de vos fichiers HTML, CSS et JS

- Optimiser la taille et la qualité de compression de vos images

- Mise en place de la mise en cache du navigateur

- Mise en place d’un CDN

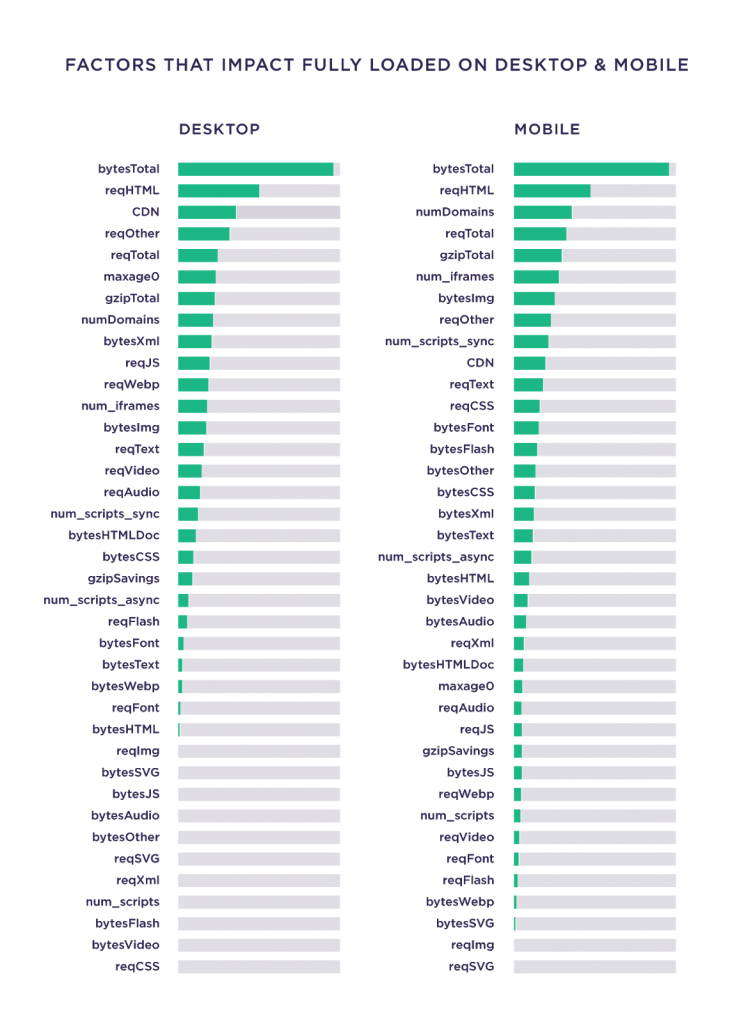

Selon une étude de Backlinko, la taille totale d’une page à la plus forte corrélation avec le temps de chargement, avant tous les autres facteurs.

Pour un créateur de contenu, l’optimisation de la vitesse est souvent hors de sa portée, car elle nécessite des compétences côté serveur et des compétences très techniques, par exemple l’utilisation de RegEx, du serveur HTTP Apache, etc. Néanmoins, il y a deux aspects dont n’importe quel spécialiste du contenu peut être responsable :

- L’utilisation des plugins : L’installation de plugins WordPress est non seulement facile mais aussi utile. Le problème est qu’ils peuvent réduire la vitesse d’un site, donc chaque fois qu’un créateur de contenu décide d’installer un plugin, il doit discuter correctement de l’implication de la vitesse avec un spécialiste SEO et un développeur web.

- Optimisation de l’image : Les images ont tendance à être les éléments les plus lourds d’une page. Pour surmonter ce problème, utilisez le format JPG, compressez vos images et, si possible, réduisez leurs dimensions.

Si vous optimisez une page, qui est déjà bien classée mais pas dans les toutes premières positions, et que vous avez vu qu’elle est déjà correctement optimisée pour le SEO on-page, vérifiez sa vitesse. Ajoutez votre page dans l’outil PageSpeed Insights de Google – ou alternativement, dans le rapport Payload d’Oncrawl – et optimisez-la en fonction des suggestions. Si ces suggestions ne vous concernent pas, discutez-en avec votre équipe SEO et les développeurs en charge de la gestion de votre site.

Optimisation du contenu

Lorsqu’un rédacteur crée un nouveau contenu, son objectif premier est d’éduquer le lecteur. Peu après la publication, un problème technique peut surgir, qui peut ruiner l’opération.

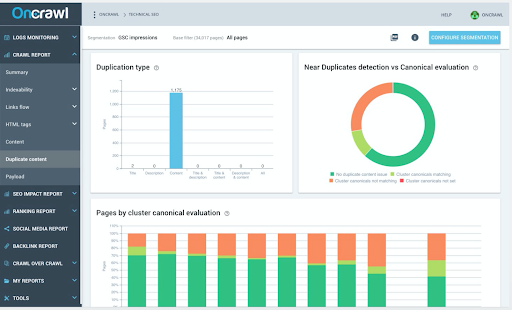

Je parle de contenu dupliqué, un problème qui survient lorsque Google indexe plusieurs versions d’une page. Les sites e-commerce ont tendance à avoir du contenu en double, ce qui conduit à l’indexation de pages variantes telles que :

- http://www.domain.com/product-list.html

- http://www.domain.com/product-list.html?sort=color

- http://www.domain.com/product-list.html?sort=price

Ces erreurs se produisent de manière involontaire et discrète. Votre objectif est d’éviter l’indexation de vos pages en double. Pour commencer, vérifiez votre site à l’aide du Near Duplicate Detector d’Oncrawl.

Il existe plusieurs solutions pour corriger les contenus dupliqués :

- Désindexez : Ajoutez la balise « noindex » à votre page dupliquée, afin que Google la supprime de son index.

- Ajoutez la balise canonical : Ajoutez la balise rel= »canonical » à la page dupliquée et indiquez la version réelle (ou « canonical ») de la page. Cela ne la désindexera pas, mais indiquera à Google quelle page il doit utiliser dans les SERPs.

- Redirigez-la : Utilisez une redirection de niveau 301 ou HTTP pour amener les visiteurs et les robots de la page dupliquée (http://www.domain.com/product-list.html?sort=color dans l’exemple ci-dessus) vers la bonne page.

- Supprimez-la : Dans certains cas, la page dupliquée a un fichier séparé dans votre serveur ou votre CMS. Dans ce cas, supprimez la page dupliquée et redirigez son URL.

- Réécrivez-la : Si vous avez plusieurs pages similaires, vous pouvez modifier leur contenu pour qu’elles soient reconnues comme des pages séparées.

Les contenus dupliqués ne doivent pas être ignorés, assurez-vous de vérifier votre site correctement et de corriger ces problèmes.

En résumé

Les conseils présentés ici ne sont que la partie émergée de l’iceberg. Le SEO technique peut être une tâche écrasante pour tout rédacteur de contenu non technique, c’est pourquoi un développeur doit effectuer les changements les plus complexes.

Néanmoins, aucun créateur de contenu ne devrait ignorer les bases du SEO technique, car elles sont essentielles pour s’assurer que le contenu fonctionne comme prévu. Tout problème pouvant entraîner un crawling et une indexation incorrects de la part de Google peut finir par causer de graves problèmes à l’ensemble du contenu.

Selon vous, qu’est ce qu’un spécialiste du contenu devrait également savoir sur le SEO technique ?