Quelle est la première chose que vous faites lorsque vous trouvez une solution à un problème SEO technique ? Où sont vos “quick wins” ? Comment savez-vous quelles métriques sont les plus importantes lorsque vous analysez votre site ?

Chez Oncrawl, nous nous sommes aperçus que nos utilisateurs étaient souvent bloqués à cette étape. C’est pourquoi nos Customer Success Managers travaillent parfois sur un site web spécifique pour créer un rapport dédié au site. Ce rapport attire l’attention des propriétaires de site sur les métriques Oncrawl qui révèlent le potentiel d’amélioration.

Ces informations permettent à l’équipe d’administration du site d’optimiser leur efficacité SEO s’ils implémentent des améliorations internes. Cela leur permet aussi de juger s’ils ont besoin ou non de faire appel à une agence ou un consultant pour réaliser un audit de site complet et résoudre les problèmes découverts.

Nous allons montrer ci-dessous quelques stratégies classiques que nos Customer Success Managers utilisent pour déterminer les métriques clés à suivre grâce à toutes les données disponibles dans Oncrawl.

Quelles données chercher et comment les trouver ?

Obtenez une vue d’ensemble complète

Commencez par conduire un crawl qui couvre tout votre site. Vous devez vous poser les questions suivantes :

- Est-ce que mes limites de crawl (profondeur maximale et nombre maximum d’URLs) sont suffisamment larges pour couvrir toutes mes pages ?

- Est-ce que je dois crawler mes sous-domaines ?

- Quelles sont les sources additionnelles de données qui pourraient être utiles pour une analyse technique de mon site ?

Vous devrez ensuite importer ou connecter toutes vos sources tierces ce qui peut être très pratique si vous savez mettre vos mains dans les serveurs de logs.

Concentrez-vous sur ce qui ressort

Ensuite, observez les résultats. Dans la plupart des cas, cela n’aide pas de se fixer sur les chiffres. Commencez par observer les tendances et pourcentages.

Si vous avez l’habitude des audits de sites, certains items vont ressortir dans les résultats de crawl et les analyses croisées. Souvent, vous n’avez pas besoin d’expérience pour détecter :

- Les aberrations et résultats inattendus : les groupes ou types de pages qui sur performent ou sous performent par rapport au reste du site

- Les profondeurs de site excessives

- Les erreurs de HTML et de qualité de site

- Les problèmes de dupliqué

- Les erreurs de redirections

- Les chutes dans le comportement de crawl

Utilisez des groupes significatifs pour répartir les données

Votre vision des ensembles de données change selon la manière dont vous groupez les données. Lorsque vous avez un site web avec différents types de pages, ou juste un site avec quelques pages, ce n’est plus viable de regarder les données individuellement. C’est là que la segmentation de vos données en groupes de pages intervient.

Utiliser les segmentations pour trouver la bonne visualisation des données vous aidera à voir distinctement les caractéristiques et faiblesses de votre site. Vous devez prendre en compte :

- Modifier la segmentation d’Oncrawl par défaut pour refléter les véritables groupes de pages de votre site

- Créer de nouvelles segmentations selons les parties de l’URL ou des données de la Google Search Console, d’analytics ou des logs.

Voici quelques unes des meilleures segmentations de site d’Oncrawl pour vous aider à démarrer.

À quoi vos résultats devraient ressembler ?

Lorsque vous créez votre propre rapport pour votre site, faites en sorte de pouvoir passer facilement de votre rapport à vos données. Nous aimons inclure des graphiques, des explications sur les problèmes que nous avons repérés et un lien vers le schéma ou le Data Explorer de la liste des pages affectées. Ainsi, vous pouvez repérer les informations importantes et revenir chercher plus de détails plus tard.

Résultats aberrants et résultats inattendus

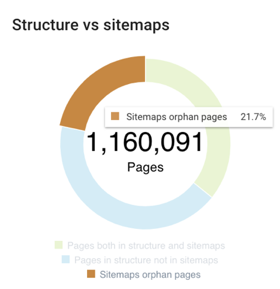

Cela peut couvrir tout ce qui a des proportions inhabituellement élevé (plus de 3 pages sur 4 requièrent plus de 500ms pour se charger ou 1 page sur 5 est orpheline) :

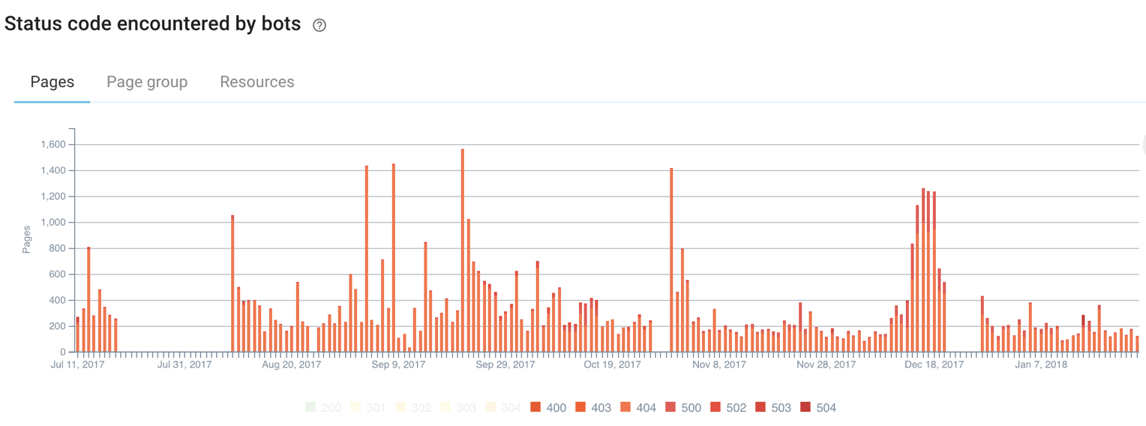

Aux erreurs 4xx ou 5xx fréquentes servies aux bots :

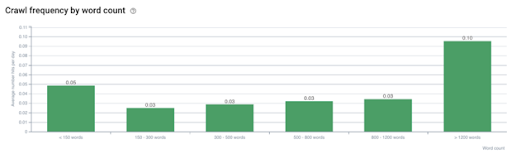

En passant par des corrélations inattendues, comme celle-ci qui montre que les pages avec un nombre de mots plus élevé (qui peuvent être les pages concernant les sujets sur lesquels vous avez le plus d’expérience ou les pages que vous avez le plus optimisées) sont crawlées bien plus souvent que les autres pages de votre site :

Profondeur de site excessive

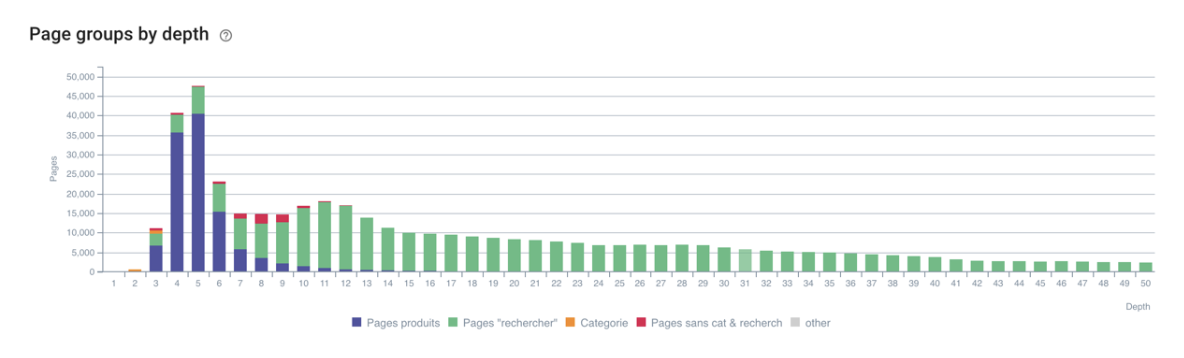

Ce crawl s’est arrêté à une profondeur de 50 avant d’avoir trouvé toutes les pages d’un site :

Les groupes avec plus d’erreurs que la moyenne

Parfois, un groupe particulier de pages a plus d’erreurs que les autres.

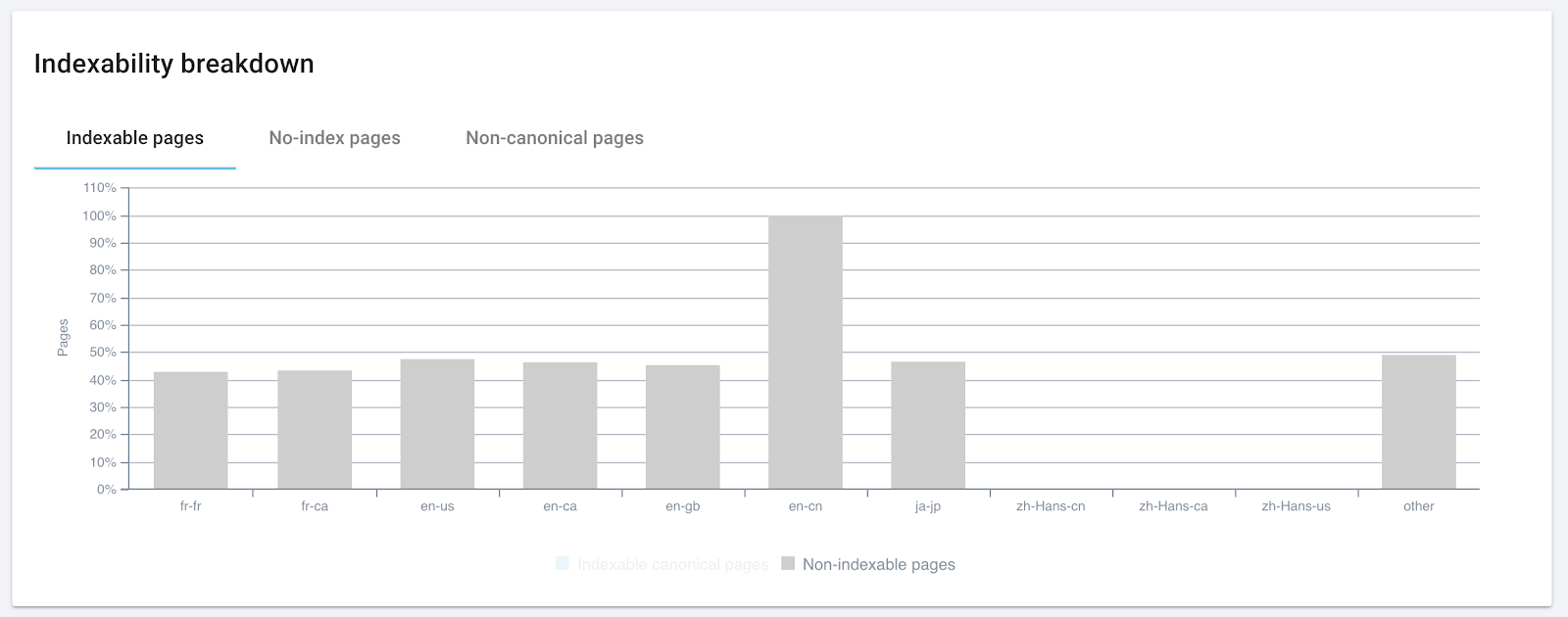

Dans ce cas, presque toutes les pages dans l’une des langues du site étaient non indexables.

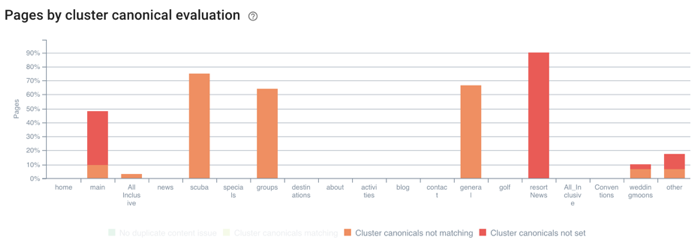

Dans cet autre exemple, l’une des sections de ce site a plus de problèmes avec la stratégie canonique que les autres :

Gérer du contenu dupliqué

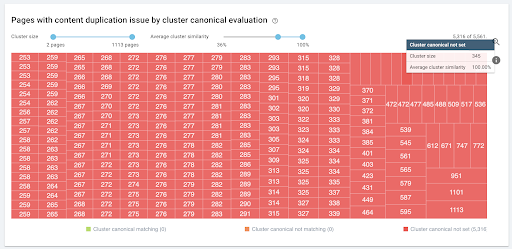

Si votre site a des groupes de centaines (ou plus) de pages presque identiques, assurez-vous qu’il y une stratégie canonique cohérente en place :

Maillage interne

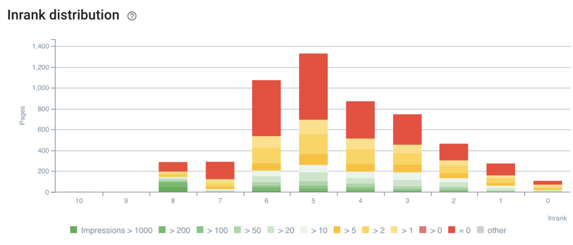

L’Inrank d’Oncrawl mesure l’importance relative des pages d’un site. Il peut révéler des problèmes au sein de la structure du maillage interne.

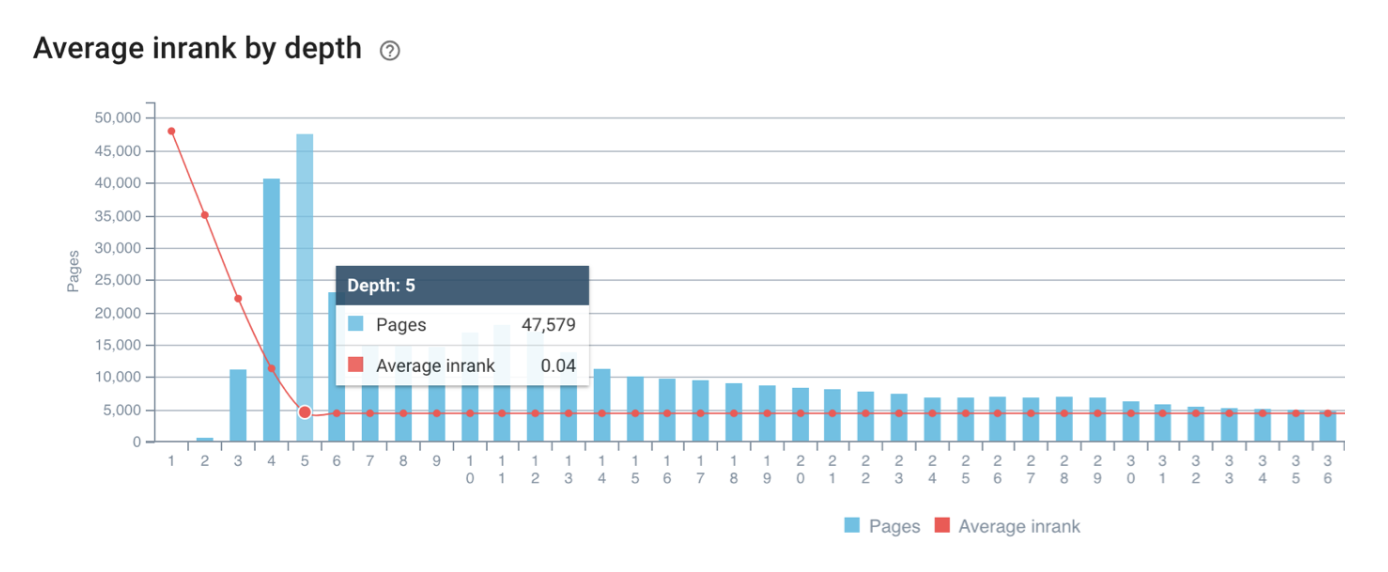

De grands headers, footers et liens dans les pages peuvent diluer l’importance des liens internes. La pire des situations serait que les pages situées juste derrière la page d’accueil ne reçoivent plus de bénéfices quantifiables des liens internes. Vous pouvez observer cela via une forte chute puis l’aplatissement de la ligne rouge qui représente l’Inrank moyen de chaque profondeur :

Les segmentations peuvent aussi révéler des problèmes en fournissant une vision clairvoyante des données. L’Inrank de ce site semble correct à première vue. Mais le nombre de pages qui gagnent des impressions augmente à un niveau d’Inrank de 5, ce qui suggère que ce site ne tire pas profit de sa nouvelle structure de maillage interne pour mieux promouvoir ces pages :

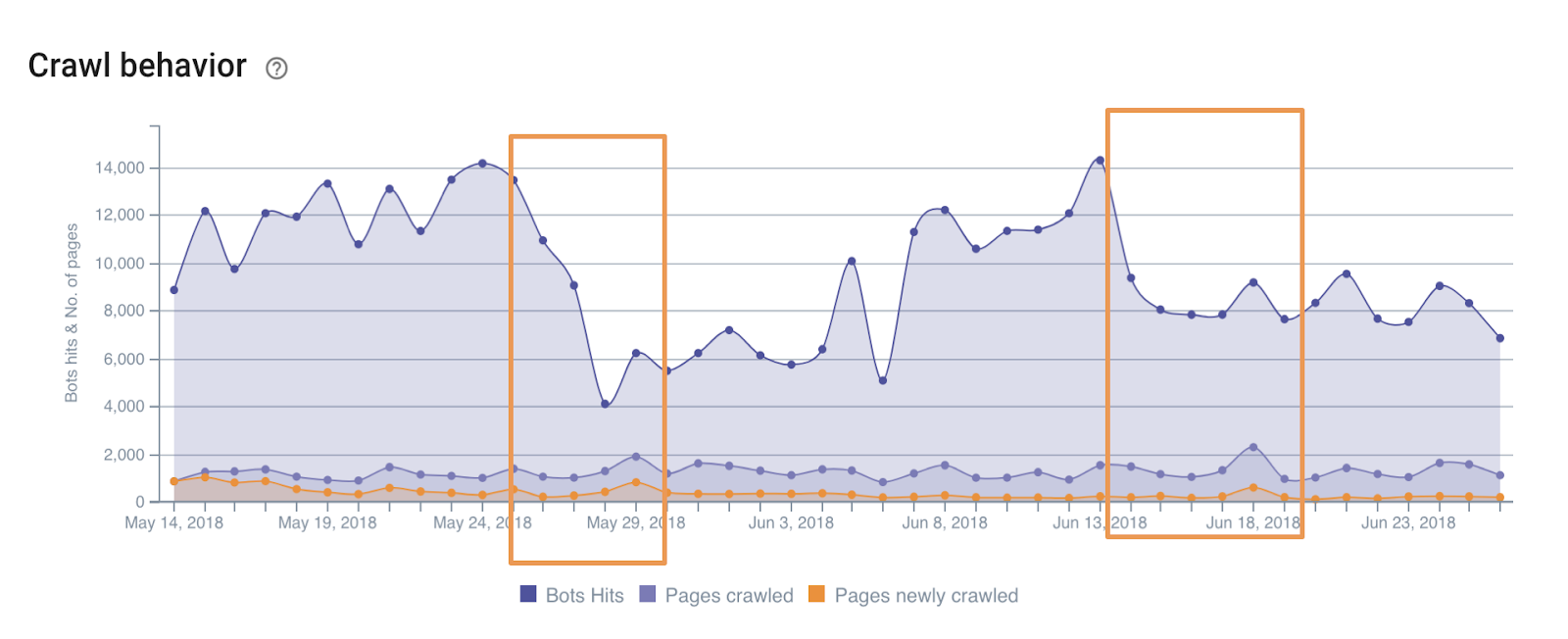

Comportement de crawl inattendu

Comparer des comportements de crawl inattendus aux événements de votre site peut révéler comment Google attend d’un site qu’il se comporte. De plus, cela permet de prédire les chutes dans les classements ou les impressions. Les périodes mises en avant ci-dessous ont toutes eu lieu une semaine avant que les classements n’aient chuté dans la Google Search Console :

Que faire après ?

Une fois que vous savez où sont situées les faiblesses de votre site, il est temps d’y remédier.

Vous savez maintenant où sont les dangers pour votre site et quelles métriques surveiller pour vous assurer de rester sur les rails. C’est une bonne idée d’analyser régulièrement votre site et de garder un oeil sur les changements dans les métriques ciblées.

Oncrawl est là pour vous aider, que ce soit votre première vérification de site ou la 10000ème fois. Et si vous êtes bloqué, notre équipe de Customer Success Managers, qui sont de véritables experts SEO, a pour objectif de vous conduire à la réussite.