Qu’est-ce que la mise à jour d’algorithme « Helpful Content » ?

La semaine dernière, Google a annoncé la sortie d’une mise à jour d’algorithme qui cherche à améliorer la qualité des résultats en favorisant le « Helpful Content » (contenu utile), actuellement en cours de déploiement. Cette mise à jour s’appliquera dans un premier temps aux sites web en anglais uniquement, et peut déprécier le contenu de tout le site, dans le cas où le site possède une quantité significative de contenu non utile.

Comme pour l’E-A-T, la notion d »utile » ne peut pas être facilement quantifiée par des métriques concrètes ; l’algorithme se repose sur le machine learning pour identifier les contenus non utiles.

Des SEOs expérimentés et spécialisés dans l’E-A-T et les mises à jour d’algorithmes ont déjà analysé avec beaucoup de finesse ce que l’on sait et comment réagir à la mise à jour Helpful Content. Les analyses de Marie Haynes, Glenn Gabe et Lily Ray méritent d’être lues avec attention.

Pour pousser la discussion plus loin, j’ai échangé avec Vincent Terrasi, Directeur Produit chez Oncrawl et expert en Data SEO avec un focus sur le machine learning et les modèles de langue comme BERT et GPT-3.

L’entretien avec Vincent Terrasi

« On peut identifier le contenu pur IA comme étant pas naturel, et donc ça sera pénalisé. Mais par contre, derrière cette Helpful Content, il y a un autre sujet et qui peut faire très mal à tous ces outils sémantiques qui se basent sur les SERPs. Google va enfin être capable de détecter la sur-optimisation, je veux dire, quelqu’un qui respecterait la parfaite empreinte pour se positionner dans Google. »

Analyse de contenus et détection de sur-optimisation : ce que va vraiment changer la mise à jour “Helpful Content”

Rebecca : Je me souviens très bien des éléments de ton travail qui a gagné la deuxième place au Tech SEO Boost 2019 où tu parlais de la génération du texte pour le SEO, les impacts et les dangers. Nous avons également discuté du sujet, notamment quand Google a sorti BERT, en parlant des prochaines étapes et comment est-ce qu’ils allaient pouvoir généraliser l’analyse textuel par le machine learning. Dans ce cas, ça ressemble un peu à la classification, puis à une analyse sémantique en plus. C’est à peu près ce que tu en tires aussi ? Est-ce que cette mise à jour te surprend ?

Vincent : En effet, c’est ce que j’avais annoncé au Tech SEO Boost : qu’ils [Google] allaient s’attaquer à ce type de contenu.

Je n’arrête pas d’expliquer aux clients qui s’intéressent à la génération de texte chez Oncrawl pourquoi il faut être prudent par rapport au contenu généré.

Il faut faire attention lorsqu’on parle du contenu généré par une IA (intelligence artificielle). Là, on n’est pas du tout sur une action manuelle. On aurait pu croire qu’il y a eu des actions manuelles. Tu auras dû voir sur les sites d’IA, et c’est bien ça que j’avais recensé. C’était il y a trois mois : il y a eu des fortes actions manuelles où il y avait des sites qui disaient qu’ils gagnaient 100 000 dollars par mois. Ils ont tous été désindexés. Là, ce sont des actions manuelles.

Maintenant, il y a cette partie avec un modèle de machine learning qui est capable d’identifier si ce sont des textes sans valeur ajoutée. Donc je ne préfère pas parler d’IA, mais des sites sans valeur ajoutée ou pas.

Rebecca : Oui, il y a une confirmation de la part de Google qu’il ne s’agit pas des actions manuelles. C’est intéressant que dans ce cas, Google dit clairement que c’est du machine learning et que ça tourne à peu près en permanence. Donc dans les mois qui suivent, un site impacté pourrait éventuellement être reclassifié… Ou pas.

Vincent : Je vais en parler à ma conférence en septembre avec Christian Méline à SEO Camp Paris, parce que c’est quelque chose que l’on avait identifié il y a cinq mois. Tu imagines ? On avait déjà identifié qu’il y avait des choses qui se passaient avec Google.

Globalement, il y a deux sujets :

Il y a le sujet du contenu généré. On va dire du contenu spammant et très facile à identifier parce que — je pourrais envoyer des exemples — l’IA se répète. Si tu regroupes par des groupes de mots de trois, quatre, cinq, il reprend les mêmes tournures. Et donc ça, c’est très facile à détecter. Tu n’as pas besoin de faire du machine learning. Et par contre la partie machine learning, c’est qu’il y a en fait des probabilités d’apparition du mot suivant qui sont très stables.

Rebecca : Oui, on en avait parlé également lors de la création de tes formations. En interne chez Oncrawl, cela a donné les travaux actuellement en cours de scoring de qualité des textes générés, afin trouver les contenus générés trop facilement identifiables comme tels.

Vincent : C’est ça.

On peut identifier le contenu pur IA comme étant pas naturel, et donc ça sera pénalisé. Donc ça, c’est le premier sujet.

Mais par contre, derrière cette Helpful Content, il y a un autre sujet et qui peut faire très très mal à tous ces outils sémantiques qui se basent sur les SERPs.

Google va enfin être capable de détecter la sur-optimisation, je veux dire, quelqu’un qui respecterait la parfaite empreinte pour se positionner dans Google. Et là nous avons des acteurs forts et talentueux en France qui n’ont pas trop réagi : les Frères Peyronnet, 1.fr, SEO Quantum, etc. Eux, ils sont directement concernés par cette update.

Rebecca : Si on prend ton site transfert-learning.ai qui était plutôt un bac à sable qui permettait de tester si l’on pouvait créer du contenu complètement généré, mais en ajoutant quelque chose qui n’existe pas aujourd’hui (dans ce cas la liaison entre la recherche académique et les formations sur les sujets machine learning).. Selon toi, est-ce qu’il est toujours possible de faire ce type de chose ?

Vincent : S’il apporte une originalité et qu’il n’est pas détecté comme spammant, oui, ça sera toujours possible de faire.

Par contre, s’il n’est pas considéré comme utile, là ça ne passera plus.

Après, il y a un énorme warning à faire : on est sur l’anglais. On sait que l’anglais, ça peut durer des mois, voire souvent une année. Quand on prend du recul sur les anciennes Core Updates sauvages comme Panda ou Penguin, ça a duré même plusieurs années dans certains cas. Je pense que certains vont profiter de ce laps de tir en français pour continuer à faire ce qu’on appelle du spam. Et après Google va intervenir.

Ce que je vais présenter avec ma conférence avec Christian Méline, c’est que plutôt que de proposer des sujets que Google a déjà et qui ne l’intéresse pas, on est capable d’utiliser des nouvelles technologies où on propose des nouveaux sujets.

Je vais te donner un exemple. Moi, je teste tous les outils SEO, et je génère des idées de sujets avec GPT-3 ou par exemple dans un outil français comme le yourtext.guru sur cette forme, j’en obtiens 40. Si j’utilise la technique de Christian Méline, j’en obtiens 4500. Et même des sujets qui n’ont jamais été créés et qui ne sont même pas dans Google.

D’après toi, qu’est ce que va préférer Google ? Avoir ce qu’il connaît déjà, ou avoir des sujets hyper intéressants dont jamais personne n’a parlé ?

Je pense que ça, c’est le futur du SEO : être capable de détecter les nouveautés. Je sais que Koray, il va beaucoup dans ce sens sémantique.

Rebecca : Oui, dans le sens d’analyse des lacunes dans le contenu ou des absences où du coup tu peux prendre une expertise parce que ce sont ces zones sémantiques d’un sujet qui ne sont pas du tout traitées.

Vincent : Exactement. Par contre, je pense que cette update là, elle ne va pas faire ça immédiatement. Là, on est sur la version 0. Il y aura une version 1, une version 2, etc. Mais le but ultime de cette update, c’est d’arriver à faire ça.

[Étude de cas] Gérer le crawl du robot de Google

Autres langues, autre support : comment cette mise à jour va-t-elle se déployer?

Rebecca : Tu as évoqué toute à l’heure la différence entre l’anglais et les autres langues comme le français. On a fait d’énormes progrès dans la traduction, dans le traitement « language agnostic » (du sens, peu importe la langue), comme avec MuM. Tu penses que cette mise à jour va vraiment prendre aussi longtemps à se diffuser dans les autres langues ?

Vincent : Franchement, j’ai fait des travaux en interne. Moi, j’ai pas les technos de Google, je n’ai pas la connaissance de Google mais j’ai jamais vu un algorithme aussi long à tourner. Ça veut dire que pour un paragraphe de 300 mots, ça met à peu près dix secondes, c’est juste une éternité. Alors d’habitude c’est les TF-IDF du word embeddings, ça prend une seconde. C’est assez lourd à déployer comme type d’algo. Aujourd’hui je sais que Google a les technos, ils ont des TPU, ils ont des ingénieurs super intelligents, mais je pense qu’ils vont avoir cette limite pour traquer un langage modèle, tu dois charger le langage model. Et quand tu sais qu’il y a 200 milliards de paramètres, ça pique en fait.

C’est marrant en plus, ça correspond pile à la sortie du modèle de génération textes sur HuggingFace. Donc je pense, et il n’y a personne qui peut le certifier, mais c’est là dessus qu’ils se sont basés pour le détecter. En fait, ils ont sorti un modèle de génération de texte pour détecter la génération texte. Il combat le feu par le feu, comme l’on dit.

Rebecca : Oui, c’est un peu comme ça quand on tourne. Même dans la détection d’utilisation de machine learning, ça a toujours été comme ça. On utilise ce qu’on sait de comment est-ce qu’ils se sont construits pour les détecter.

Vincent : Mais moi, ce qui m’impressionne, ce sont les outils SEOs, ils fournissent une empreinte des SERPs. Et là, Google est en train de dire, « nous on a l’empreinte et on va être capable de savoir si vous vous êtes trop inspiré ou pas de cette empreinte. » Personne ne sait comment ils font. Je sais comment font les autres outils SEO, mais comment eux [Google] font-ils ? Personne ne le sait.

Rebecca : En fait, l’autre chose qui m’avait marquée, c’est que c’est une analyse au niveau du site et que du coup pour chaque site il y a, si l’on parle vraiment de vulgarisation très haut niveau, une « valeur » qui est attribuée de Helpful ou Unhelpful Content qui peut impacter les autres contenus sur ce site. Et c’est beaucoup d’analyses individuelles, et beaucoup de stockage d’infos. Ainsi donc, même juste pour processer ou re-processer cela, ça prend énormément de temps.

Vincent : Je pense que c’est la contrainte qu’ils ont. Ils ont annoncé qu’ils ne le faisaient que sur Google Search pas pour Google Discover.

C’est un peu paradoxal parce que sur Google Discover, tout le monde triche, tout le monde optimise des contenus « SEO » juste pour être dans Google Discover. Je pense qu’ils ont un gros problème en ce moment avec Google Search et tout ce contenu généré automatiquement. Il y en a qui ont fait ça sans limite.

Ils ne parlent pas d’une pénalité, donc ils tournent ça un peu comme avec Google RankBrain, comme un nouveau signal.

Et tous les sites ne seront pas concernés. Je pense notamment aux sites e-commerce. On sait très bien : toutes les description produits, tout le monde copient les uns sur les autres.

Rebecca : Oui, ça vient des descriptions officielles des producteurs, des marques.

Vincent : Oui.

Mais certains sites des médias courent un risque plus important. Il y a un phénomène très connu en SEO depuis longtemps. Par exemple, certains prennent du contenu en anglais et le traduisent sans apporter aucune valeur ajoutée. Personne n’en a parlé, mais il y a un risque majeur pour ce type de sites car cela n’apporte rien et en plus, ils ont le défaut de ne pas citer les sources.

Rebecca : Et ils auront aussi les bases en anglais pour faire une comparaison aussi.

Vincent : Oui, sur le coup, le passage anglais-français risque de faire mal à certains sites qui spamment.

Dans les actualités SEO depuis pas mal de mois, c’est la mise à jour la plus importante. RankBrain aussi, on pourrait la mettre dedans, mais on l’a pas trop vu passer, on n’a pas trop vu son application.

Rebecca : Je trouve que ça se rapproche en fait, avec le concept d’analyse sémantique et les parties du site web qui ne sont pas liées au reste du site web.

Vincent : Exactement.

Je sais qu’ils ont mis les moyens parce qu’ils bossaient sur ces sujets depuis un moment. J’avais un ami qui travaille chez Google, qui dit bosser sur ce sujet depuis 2009, il y avait deux équipes de recherche là-dessus. Ils tâchent de le faire maintenant en temps réel et vont faire un sacré nettoyage.

Mais on en sait toujours peu sur l’implémentation. Ils vont faire comment ? Avec un signal ? Est-ce qu’ils vont moins bien indexer ceux qui trichent ? Personne ne peut répondre à cette question, à part John Mueller.

Rebecca : Même lui, il n’aura pas le droit. J’imagine qu’ils vont garder leur ligne de conduite, “créez des contenus utiles pour des utilisateurs, pas pour les moteurs de recherche et vous n’aurez pas de problème. »

Vincent : Sur Twitter, il est bombardé de questions sur ce sujet et il y répond un peu de façon floue.

L’impact sur la création de contenus dans le futur

Rebecca : Ça ne m’étonne pas. Je pense qu’il n’a sûrement pas d’informations plus précises. Et même s’il en a, il doit y avoir une interdiction absolue de parler de l’algorithme.

Quoi qu’il en soit, j’ai très hâte de commencer à voir les brevets qui sont liés, à refaire une analyse des brevets d’ici un an, deux ans, à voir ce qui est présent et si l’on aura des indices d’utilisation un peu plus tard. Mais ça, c’est un autre sujet.

Vincent : Pour préparer ma conférence en septembre, j’ai listé comment on reconnait un contenu de qualité, un contenu utile. Je me suis basé sur l’article dans le journal du net où Christian Méline avait écrit sur le sujet il y a [trois] ans. Son contenu est encore complètement d’actualité. Par contre, il ne s’appuie pas sur du machine learning. Il déteste cela, donc ce sont des métriques basiques, utiles : est-ce que le titre est bien écrit ? Est-ce qu’il y a des fautes d’orthographe ? Est-ce que ça apporte de nouvelles connaissances ? Rarement des choses où tu auras besoin du machine learning pour les faire.

Rebecca : Ce type de conseil va être super important parce que la plupart des SEOs n’ont pas forcément les ressources, les données, le temps ou tout simplement les compétences pour implémenter du machine learning, pour pouvoir analyser leurs sites, pour savoir s’il y a des risques de tomber là dedans ou pas.

Vincent : Exactement. Il faut suivre ça de très très près.

De plus, il faut faire très attention à ce qu’on dit. Il faut parler au conditionnel. Il n’y a personne qui ait des certitudes sur ce sujet.

Rebecca : C’est certain. On n’a que de choses de très haut niveau, ce qui veut dire qu’on n’a pas de preuve, pas d’indice et pas d’infos. Donc clairement tout ce qu’on peut dire dessus, ce ne sont pas des conclusions, ce sont des théories.

Vincent : Exactement.

Voici ce que j’avais mis en place rapidement :

- L’analyse des tokens pour regarder la répétition : quand c’est excessif, quand c’est que pour ranker.

- Ensuite, les fameuses probabilités entre les mots.

- Et le dernier, c’était les groupes de mots.

Juste avec ces trois combos-là, je détecte 90 % des textes générés, on va dire, sans optimisation humaine. Imaginez donc ce que peut faire Google ! C’est hallucinant.

Rebecca : Du coup, il faut absolument suivre ta conférence SEO Campus le 23 septembre avec Christian.

Vincent : Oui, on voulait un peu démonter le sujet du contenu utile. C’est marrant : avant même qu’on commence à parler de l’update, c’était prévu.

J’aime bien ce sujet aussi parce que je suis très orienté planète. Ça me rassure. Il y a des contrôles comme ça pour éviter aux gens de spammer. Parce que ça nous coûte des ressources inimaginables.

Rebecca : En effet. Avec cette update, tout le monde est très attentif. Je pense que ceux qui pensent que ça ne va rien changer ont tort. On voit que ça va changer non seulement comment est-ce qu’on doit créer des contenus, mais aussi comment est-ce que Google évalue les contenus. Et ce sont des stratégies qu’on n’a pas vues jusque là.

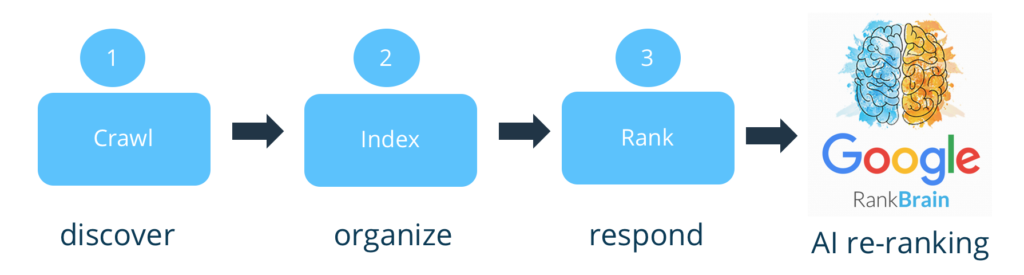

Vincent : Exactement. En fait, si l’on peut le dire, Google n’évalue pas le contenu. C’est une énorme faiblesse. Il se contentait d’indexer et de ranker. Maintenant ils vont filtrer en amont. Et c’est ce que reprochait Bing à Google.

Rebecca : Effectivement, la plupart des analyses [sur le contenu] venaient au moment de ranker.

Vincent : C’est ça. Là, il semble avoir un petit filtre. Moi, je suis comme toi. Je suis impatient de voir le brevet qui va sortir là dessus. Ils vont être obligés de dévoiler où ils ont mis le filtre. Tu paries qu’ils ont mis le filtre où ? Avant, après l’indexation ou avant, après le ranking ? Tu le mettrais où ?

Rebecca : Vu qu’il faut avoir la plupart du site pour pouvoir le faire, je dirais…

Vincent : N’oublie pas qu’il faut l’empreinte des SERPs, comme on en a discuté, pour l’indexation. On est donc obligé de les indexer.

Rebecca : Oui, c’est ce que j’allais dire. Je pense que ça devrait être une étape supplémentaire, on court à priori pas de risque de désindexation, donc on parle bien d’un impact après l’indexation, peut-être aussi après le ranking [initial].

Vincent : Oui, pour moi, c’est après le ranking. À la place de Google, c’est c’est quelque chose que j’aurais ajouté sur Google RankBrain, parce que lui, il est capable d’agréger des signaux, etc. Maintenant, la question c’est à quel point il va être impactant sur les sites.

Rebecca : Avec le machine learning, ça peut varier énormément de site en site, parce qu’on peut avoir un contrôle beaucoup plus fin sur son impact et sur l’importance du « unhelpful content » sur chaque site.

Vincent : La limite chez Google, c’est les faux positifs. Ce serait de désindexer [ou pénaliser] des pages légitimes. Donc je pense que l’impact au départ va être très très bas, mais qu’ils vont vraiment s’en prendre à ceux qui trichent.

Il y a quand même des personnes qui m’ont contacté, qui étaient un peu inquiètes. Je leur ai répondu qu’au début, ça va seulement détecter les textes sans qualité. C’est-à-dire, je pense qu’un texte [généré], mais avec relecture humaine, il peut avoir tout son côté utile.

Je ne suis pas aussi tranchant que les autres qui disent « IA = poubelle ». Ça, je n’y crois pas trop non plus.

Rebecca : Ça ne m’étonne pas de toi !

C’est un peu frustrant, de savoir que ça va aller assez lentement. Justement, comme tu dis, pour éviter les faux positifs, c’est encore une raison pour un lancement qu’en anglais : ils ont une meilleure maîtrise en anglais. Cela permet de mettre des contrôles supplémentaires qui sont beaucoup plus coûteux, avant de généraliser sur tout le web et dans d’autres langues qui sont moins bien maîtrisées, moins bien automatisées.

Dans tous les cas, ça a été une discussion très riche. Merci beaucoup pour cet échange.

Vincent : On en rediscute quand tu veux.

Rebecca : Au plaisir !