En mémoire de Bill Slawski.

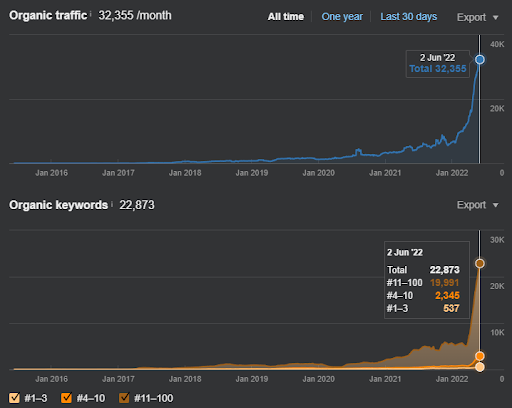

Cette étude de cas SEO a été rédigée avec 27 articles, en prenant le trafic de Healthline.com, Webmd.com, et Medicalnewstoday.com en 30 jours. Les premiers résultats sont ci-dessous.

- 20 000 nouvelles requêtes en 30 jours.

- 3 000 nouvelles requêtes sur la première page Web.

- 13 000 nouvelles requêtes entre 10 et 50 positionnements.

- 847% d’augmentation des impressions organiques

- 142% d’augmentation des clics organiques

Les derniers résultats sont encore meilleurs, mais nous allons nous concentrer sur les 30 premiers jours avec 27 articles. Le reste de l’article pourrait être plus académique pour la compréhension des moteurs de recherche. Comme il s’agit d’une section d’étude de cas SEO de mon futur cours de SEO sémantique, l’explication sera plus légère.

Pour savoir quand le cours sur le SEO sémantique sera disponible, inscrivez-vous à la newsletter Holistic SEO : https://www.getrevue.co/profile/koraygubur

Koray Tuğberk GÜBÜR est le PDG de Holistic SEO, une agence de référencement qui se concentre sur la compréhension des moteurs de recherche, de manière holistique.

Que sont le seuil de qualité et le classement prédictif ?

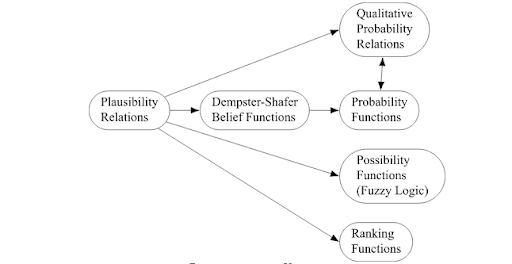

Les seuils de qualité et le classement prédictif basé sur la recherche d’information sont pertinents l’un par rapport à l’autre pour déterminer le potentiel de positionnement global d’une source dans un index inversé. Le seuil de qualité implique un score pour être positionné pour une certaine requête, ou un réseau de requêtes, tandis que le classement prédictif permet aux seuils de qualité de changer, et de s’améliorer avec des tests continus des résultats.

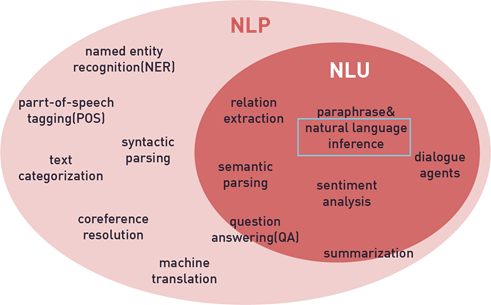

Le classement prédictif est appelé Predictive Information Retrieval par certaines sources, comme Google. Dans d’autres documents universitaires, il est utilisé comme « Inférence incertaine ». Même s’ils ne sont pas complètement identiques, ils sont très similaires les uns aux autres.

Dans cet article, un exemple d’étude de cas SEO sera présenté du point de vue de l’E-A-T et de l’autorité thématique pour démontrer les seuils de qualité et le classement prédictif.

Contexte de l’étude de cas SEO

L’étude de cas SEO pour expliquer les seuils de qualité des moteurs de recherche porte sur un site web e-commerce qui vend des produits de luxe liés à la santé. Le produit est directement lié à la santé.

L’objectif du projet est d’augmenter le trafic organique via le SEO sémantique afin d’améliorer les conversions et d’investir dans le développement de la marque.

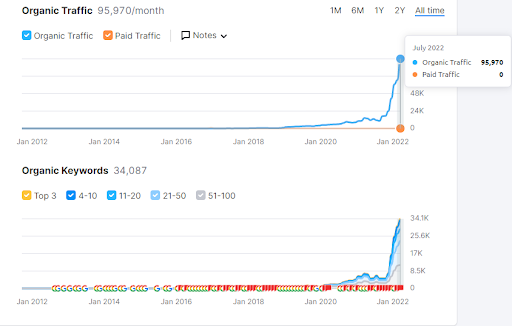

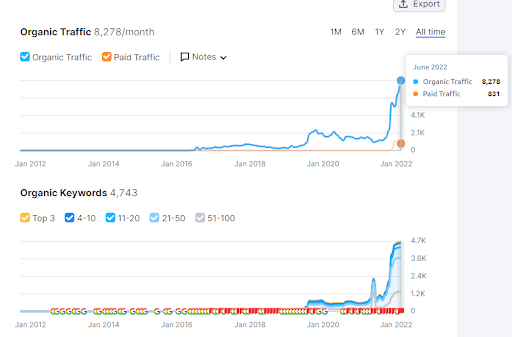

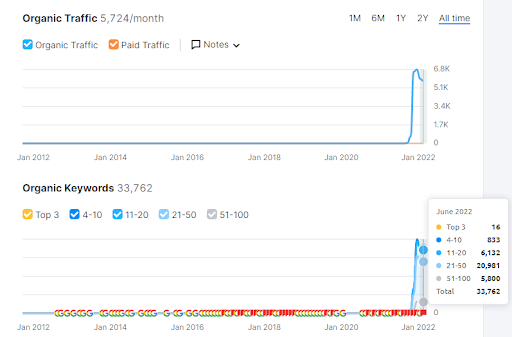

Ci-dessous, vous verrez le graphique des résultats de SEMrush.

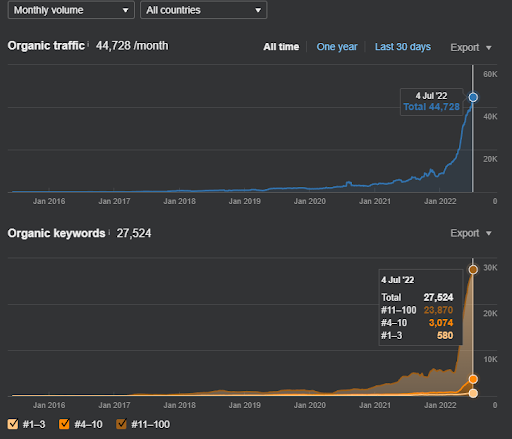

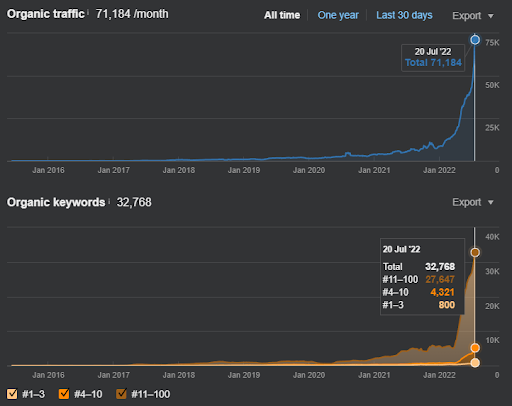

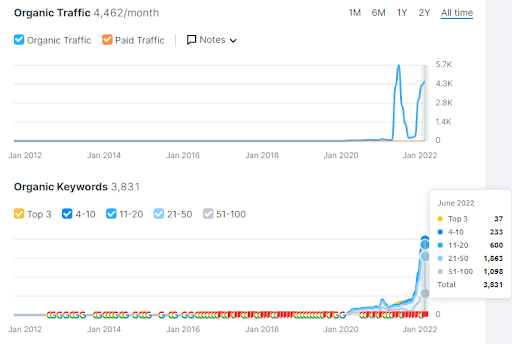

Ci-dessous, on peut voir le graphique des résultats d’Ahrefs.

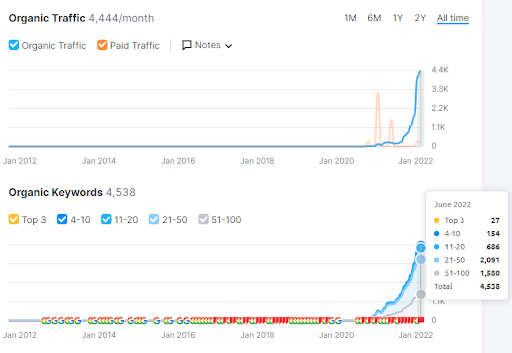

Ci-dessous, on peut voir la version du site Web en question un mois plus tard, d’après Ahrefs.

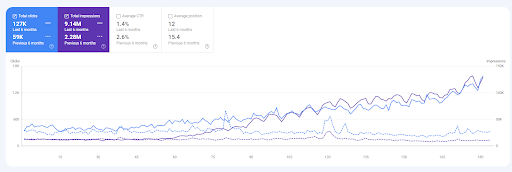

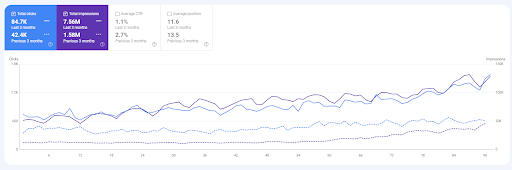

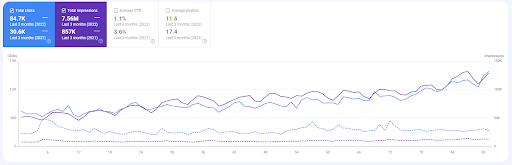

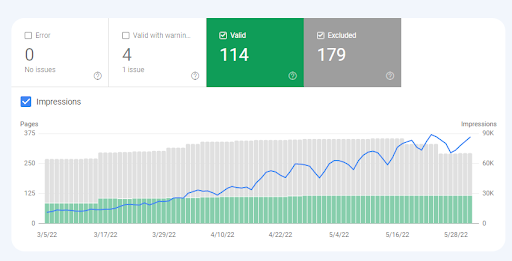

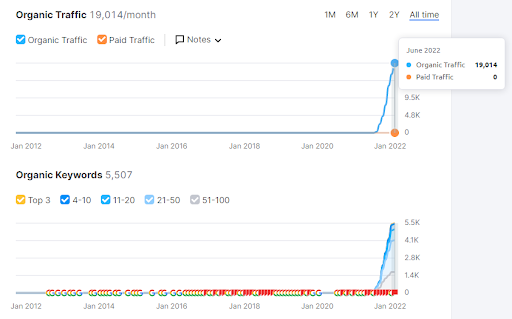

Les données de la GSC pour le site Web de l’échantillon sont présentées ci-dessous. Malgré l’augmentation du nombre de requêtes, la position moyenne n’a pas diminué, elle a continué à augmenter.

Pour voir le contexte général de l’étude de cas SEO du seuil de qualité, vous pouvez regarder la vidéo ci-dessous.

Mises à jour du seuil de qualité de l’étude de cas SEO

Les mises à jour de l’étude de cas SEO Quality Threshold concernent les changements qui ont eu lieu les deux semaines suivant la publication initiale sur Oncrawl.

Après la publication de l’étude de cas sur le référencement du seuil de qualité, les mises à jour continues de Google et l’accumulation de données historiques ont garanti un état de positionnement positif avec des augmentations régulières des performances de recherche organique.

En incluant les deux dernières semaines, vous pouvez voir l’augmentation évidente qui est déclarée et l’augmentation du trafic organique annoncée par le dépassement du seuil de qualité.

Les 6 derniers mois de comparaison des recherches sur Google des sites Web concernés par l’étude de cas SEO sont présentés ci-dessous.

Augmentation de 115,25 % des clics organiques, 308,87 % des impressions organiques, 21,4 % de la position moyenne.

Les 3 derniers mois de comparaison :

Augmentation des clics organiques de 99,45 %, augmentation des impressions organiques de 378,48 %, augmentation de la position dans les résultats de recherche organiques de 16,37 %.

Augmentation des clics organiques de 176,79 %, augmentation des impressions organiques de 789,41 %, augmentation de la position dans les résultats de recherche organiques de 34,09 %.

Ci-dessous, vous pouvez voir la version des résultats de recherche organique Ahrefs et les données de performance pour le site web sujet de l’étude de cas sur l’importance des seuils de qualité pour le SEO, 16 jours plus tard.

Il y a 6 000 requêtes de plus avec 27 000 sessions de trafic organique calculées par Ahrefs.

La version des données de performance de recherche organique de SEMrush pour le même site Web, 16 jours plus tard, montre 34 000 nouveaux clics organiques et près de 10 000 nouvelles requêtes organiques. Pour démontrer que la source domine contre les autorités de la niche santé avec seulement 27 articles bien écrits, vous pouvez vérifier les sections ci-dessous.

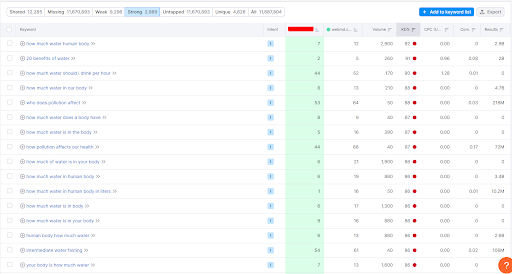

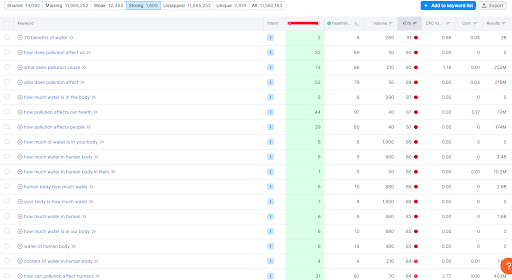

Il y a 13 000 requêtes communes avec Webmd.com. Et, pour près de 3 000 d’entre elles, le site Web sujet domine Webmd.com. De plus, la difficulté moyenne des mots-clés est supérieure à 85.

Il y a plus de 11 000 requêtes communes contre Healthline.com. Pour plus de 2 800 d’entre elles, le mot clé moyen du site Web sujet domine Healthline.com.

Il y a plus de sites Web d’autorité mondiale sur la santé et les sujets YMYL et perdre contre le site Web de sujet. Les requêtes ci-dessus sont des échantillons aléatoires qui sont choisis parmi des sources aléatoires. Ci-dessous, vous pouvez voir la direction et l’ampleur du dernier repositionnement pour le site web en question.

Les 16 derniers mois de données GSC du site web en question. Il montre une ligne plate constante jusqu’à la publication des 27 derniers articles qui ont été écrits de manière algorithmique. Pour mieux comprendre la paternité algorithmique, lisez Semantic Networks for SEO.

Pour démontrer l’autorité du contenu et l’authenticité de l’auteur (créateur principal du contenu), vous devez comprendre l’expert du domaine de connaissances. Un expert du domaine de connaissances est une source principale d’information pour un sujet, et différents contextes dans les réseaux thématiques. Prouver l’authenticité et l’autorité de l’information à un moteur de recherche sémantique change l’identité d’une source (site web).

Pourquoi un moteur de recherche a-t-il besoin d’un seuil de qualité ?

Les seuils de qualité sont utilisés dans presque tous les algorithmes de classement, de filtrage et de tri basés sur certaines métriques.

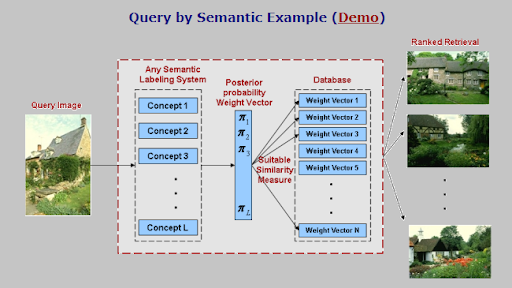

Par exemple, pour classer une image de 800×600, un algorithme de machine learning a besoin de 58 millions de « boîtes de regroupement » différentes, mais il est impossible de le faire. Parce que c’est coûteux. Ainsi, les moteurs de recherche utilisent des « propositions de régions » avec « recherche sélective » pour la détection des objets. Et, s’il y a 5 objets différents, il sera difficile d’étiqueter l’image. Ainsi, un seuil est indispensable.

C’est un petit site web.

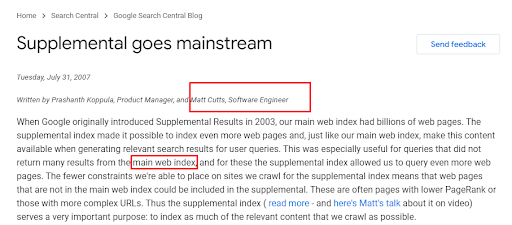

Un autre exemple de seuil de qualité est celui des index supplémentaires. Le Charles Darwin du SEO, Bill Slawski, a été la première personne à mentionner le concept de l’index supplémentaire par Google. Selon le concept, Google utilise un index supplémentaire et l’index principal. Si une source dépasse le seuil de qualité, elle change sa position de l’index supplémentaire à l’index principal.

Un autre exemple du seuil de qualité qui se produit avec l’indexation. Google utilise la compréhension prédictive de la qualité en vérifiant les URLs initiales de la file d’attente de crawl pour savoir s’il vaut la peine de crawler plus profondément ou non.

Un dernier exemple de seuil de qualité provient du référencement des actualités. Si Google ne voit pas de résumé approprié dans l’introduction de l’article, il peut ignorer l’article à des fins de positionnement ultérieur. Ainsi, la qualité du résumé peut affecter le positionnement général, même si ce n’est pas la qualité de l’article entier.

Note : La version réelle de l’étude de cas SEO sera donnée pendant le cours de SEO sémantique avec 5 sites web supplémentaires, des documents de recherche réels et plus d’informations.

Quelques autres exemples de sites Web et d’industries pour le positionnement initial avec des seuils de qualité dépassés

Avant d’aller plus loin, vous pouvez voir d’autres échantillons de sites Web qui dépassent les seuils de qualité dans différents secteurs.

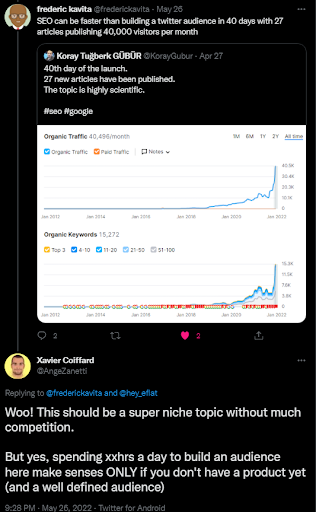

L’échantillon ci-dessus est une boutique e-commerce pour certains produits cadeaux, et il y a un lancement prévu. Ainsi, il a été indexé et rendu plus rapidement.

L’exemple ci-dessous provient à nouveau d’un site Web YMYL avec un lancement rapide pour cause de dépassement des seuils de qualité.

L’exemple ci-dessous provient d’un site Web du secteur de la santé. Vous voyez, ce « classement prédictif » fonctionne avec différents niveaux de confiance.

L’exemple ci-dessous est un autre seuil de qualité dépassé. Il s’agit d’un annuaire de recherche locale pour les entreprises hors ligne pour des activités commerciales. Son principal avantage est l’information sur les stocks.

Le dernier exemple ci-dessous est un domaine de correspondance exacte pour l’industrie YMYL, les voitures d’occasion.

Ces échantillons seront donnés dans le cours de SEO sémantique avec des explications scientifiques plus détaillées. Tous ces lancements ont porté sur des types spécifiques de réseaux de requêtes avec une compréhension des algorithmes de classement de Google, et des seuils de qualité avec un classement prédictif. Puisque tous les échantillons sont des sites YMYL et touchent à la santé, il est plus crucial d’affirmer qu’il est possible de prendre le trafic des autorités mondiales sans attendre si longtemps.

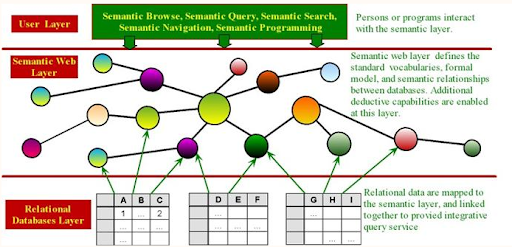

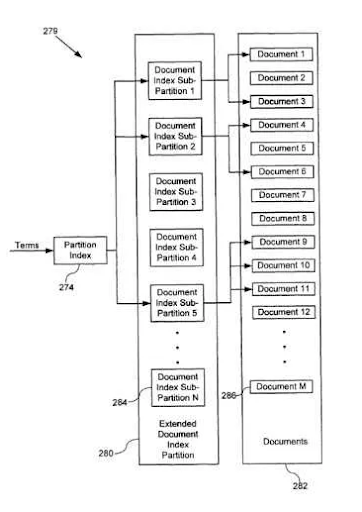

Pourquoi la partition d’index est-elle nécessaire pour un moteur de recherche ?

ILa partition de l’index signifie qu’un moteur de recherche divise son index en plusieurs parties. Lorsqu’un utilisateur saisit une requête dans un moteur de recherche, pensez-vous que ce dernier vérifie l’intégralité de l’index ? Dans ce cas, vous attendriez 2 heures pour une seule SERP. Et si un moteur de recherche recherchait les requêtes possibles des utilisateurs avant même que l’utilisateur ne les cherche pour créer des groupes de documents ?

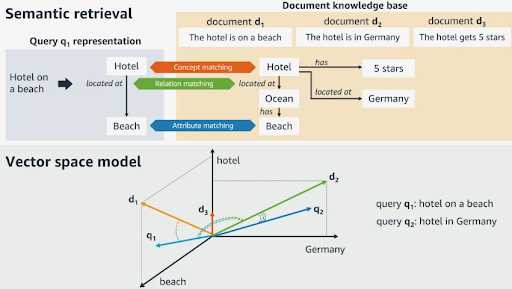

C’est ce qu’on appelle les requêtes synthétiques, que j’ai expliquées dans ma méthodologie de traitement des requêtes et des moteurs de recherche sémantiques. L’objectif du moteur de recherche avec la partition de l’index est de décider quel document et quelle requête iront à quel cluster de concepts. Et, il existe différentes méthodes de partition d’index. Les dernières méthodes se concentrent sur les Triples (Sujet, Prédicat, Objet). Les échantillons précédents se concentraient sur les termes contextuels et les mots-clés dans les documents.

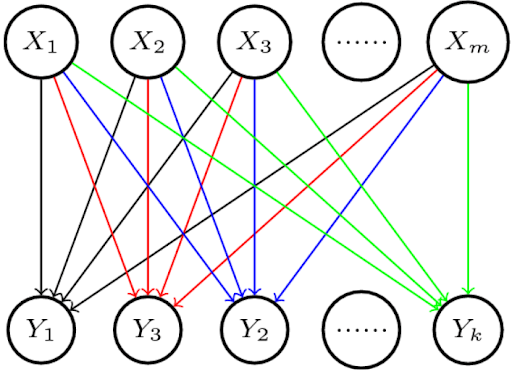

Un exemple d’inférence incertaine pour les requêtes.

La partition de l’index et les seuils de qualité sont liés l’un à l’autre.

Comment décider quel document va à quel cluster ?

Un moteur de recherche peut indexer un document, puis le désindexer et le réindexer pour une autre requête. Une requête sous forme de verbe peut avoir différentes lemmatisations, et le moteur de recherche peut créer différentes partitions d’index pour différents formats de verbe. Le document peut ne pas avoir les formats de verbe spécifiques, ou les séquences verbe + nom spécifiques, ou même s’il les a, il peut donner des informations incorrectes qui contiennent le sujet d’une base de connaissances. Ainsi, différents seuils de qualité sont déterminés pour différents formats de noms, de verbes et d’autres types de mots tels que les adjectifs.

Je n’ai pas écrit cette étude de cas contre ces affirmations. Mais je veux changer la façon dont le SEO est fait.

La pertinence permet de décider de la connectivité globale entre un document et la requête. Si le document présente plusieurs macro et micro-contextes, il peut s’agir d’un document sans contexte ou mal formaté. Pour ces types de situations, le moteur de recherche dispose de l’indexation par passage, qui est une méthode permettant d’éliminer la plupart des sections non pertinentes du document et de le classer uniquement avec ce passage spécifique.

Mais, comment décider quelle partition d’index est la meilleure pour quel document et quel groupe de requêtes ? Plongeons dans la sémantique des requêtes.

Qu’est-ce que la sémantique des requêtes ?

La sémantique lexicale et la sémantique d’interrogation sont différentes l’une de l’autre. « Acheter » est l’antonyme de « Vendre », mais pour la sémantique des requêtes, ce sont des « synonymes ». Cela signifie que la pertinence globale d’un document lié à « Acheter » est égale à la pertinence globale d’un document lié à « Vendre ». La sémantique des requêtes se concentre sur le besoin qui se cache derrière la requête.

Si l’état général des utilisateurs est le même que celui d’un autre utilisateur du même groupe de requêtes, ils se trouvent dans le même état markovien. Ce phénomène est parfois appelé « biais d’état ». En d’autres termes, un utilisateur a toujours un biais qui provient d’un état, et de nombreux états d’utilisateurs se suivent avec des mots, des verbes et des noms similaires. L’intégration de ces concepts dans le format synonyme permet au moteur de recherche de réduire les besoins de calcul tout en augmentant la pertinence globale et la correspondance conceptuelle entre les besoins de l’utilisateur et la requête.

Un schéma de l’inférence incertaine de l’Université de Stanford.

Un exemple de partition d’index et de seuils de qualité

La requête sera au format « Verbe + Nom ». Il y a deux partitions d’index candidates et la pertinence globale sera calculée avec les principes de base de l’Extraction d’Information (Information Retrieval).

La page web utilise le titre « Best Verb + Methods for Small + Nouns ».

- Le « nom » est au pluriel.

- Le mot « méthode » est qualifié de « verbe ».

- Le « petit » réduit les ensembles du « nom » pluriel.

- La marque n’est pas incluse.

- Il existe de multiples méthodologies pour le « verbe ».

- La personne cherche des instructions et des suggestions liées au « verbe ».

- Les synonymes de « méthode » sont « approche », « procédure », « plans » et « système ».

- Les synonymes de « plus petit », « minuscule » et « mineur » sont des synonymes possibles.

- Le thème du mot et le contexte passent d’un synonyme à l’autre.

Puisque nous nous concentrons uniquement sur les principes de base de l’IR (Information Retrieval), je ne m’intéresserai pas à la mise en page des pages Web, au format du contenu, à la langue ou aux structures de phrases.

Commençons par créer nos partitions d’index basées sur les clusters de documents.

- Le premier groupe de documents comprend des documents qui contiennent le mot « Best », mais pas la « méthode », il s’agit de « Best + Nouns for People with Small X ».

- Le deuxième groupe de documents comprend des documents qui contiennent le mot « Best », mais pas le petit X, il s’agit de « Best + Noun + Procedures for + Verb ».

- Le troisième groupe de documents contient le verbe correct et le nom, mais pas le meilleur. Il s’agit de « Noms + Verbe pour Petit X ».

Du point de vue du moteur de recherche, le document n’appartient pas vraiment à un de ces groupes. Mais, lorsque nous nous concentrons sur la sémantique des requêtes, le moteur de recherche et les opérateurs de sites Web travaillent ensemble.

Une explication de Google, pour Supplemental Index.

Si les requêtes contiennent le mot « méthode », ou des mots similaires, il aura un poids plus important sur les documents pour le score IR, même s’il n’y a pas de partition d’index pour cela. Et c’est ici que nous commençons à comprendre les concepts de « recherche d’information continue » et de « reclassement automatisé ». Un moteur de recherche crée toujours de nouvelles partitions de l’index en prenant les scores IR en permanence, tout en reclassant les documents.

Si les requêtes contiennent la « méthode » de manière plus contextuelle, le groupe de requêtes spécifique modifiera davantage les groupes de documents. Et d’autres documents de l’index supplémentaire seront déplacés dans l' »index principal ».

Ainsi, dans les projets d’autorité thématique et de SEO sémantique, les moteurs de recherche commencent à modifier leurs groupes de documents en fonction des sources faisant autorité et de leur similarité avec les autres.

La plupart des mises à jour de l’algorithme de base général se concentrent sur la « pertinence », plutôt que sur les aspects techniques du web. Elles modifient la pertinence de la distance, de la proximité sémantique et des matrices de cooccurrence.

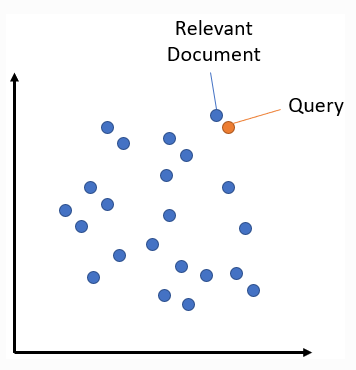

Un exemple de recherche sémantique avec recherche vectorielle d’Alessandro Moschitti.

S’il y a suffisamment de niveaux de documents similaires dans le groupe de documents, le seuil de qualité sera plus élevé. Sinon, le seuil de qualité sera plus petit pour la pertinence, et les moteurs de recherche choisiront de classer les sources à haut PageRank même si leurs pages Web ne correspondent pas parfaitement à la requête spécifique. Mais elles sont pertinentes pour le sujet général. À partir de cette dernière phrase, vous pouvez voir encore plus loin le lien avec l’indexation par passage.

Puisque, dans cet exemple, nous nous sommes concentrés uniquement sur la partition de l’index avec l’IR, nous n’avons pas mentionné les entités, les attributs ou la corroboration des réponses Web.

Pourquoi l’autorité thématique est-elle pertinente pour les seuils de qualité ?

La qualité catégorielle est une sous-section de l’autorité thématique qui provient de Trystan Upstill. La qualité catégorielle implique la qualité de la source pour certains types de requêtes. Si une source contient les n-grammes, les phrases ou les combinaisons de phrases pertinentes pour une source, elle reçoit une qualité de catégorie supérieure. Les catégories de requêtes sont créées sur la base de trois éléments.

- Taxonomies de phrases de requêtes.

- Taxonomie des requêtes pour le comportement de recherche

- Pertinence de l’expression de la requête

La qualité catégorielle est mesurée à l’aide du traitement des requêtes et des résultats de l’analyse syntaxique. Un moteur de recherche peut attribuer différents scores de qualité catégorielle aux différentes sources en fonction de leur pertinence globale pour certains types de requêtes.

Un exemple d’étiquetage d’images et de recherche avec des requêtes visuelles.

À partir de notre exemple de score IR et de partition d’index, vous pouvez comprendre que la qualité catégorielle globale change en fonction de la pertinence globale de la source par rapport au réseau global de la requête. Ainsi, un sujet est constitué de différents sous-thèmes. Les réseaux de requêtes sont créés sur la base des sujets et des contextes. Ainsi, pour avoir une autorité thématique pour un sujet, une marque ou une source doit suivre certains réseaux de requêtes.

De plus, différentes formes de verbes, de noms, d’adjectifs ou de groupes de requêtes peuvent entraîner des changements dans la qualité catégorielle tout en nécessitant des changements dans la conception du réseau de contenu sémantique. Pour dépasser le seuil de qualité avec l’autorité thématique, la source doit prouver qu’elle a un niveau de consolidation suffisant pour la profondeur, l’étendue et l’activité de publication avec une conception appropriée de la paire document-requête.

Quelle est la pertinence de l’E-A-T pour les seuils de qualité ?

E-A-T est un concept fondamental de filtrage et de hiérarchisation des sources pour un groupe de signaux qui démontrent la qualité globale de la source, et sa capacité à répondre aux besoins de l’utilisateur de manière saine. E-A-T est lié aux seuils de qualité, car même si une source a une autorité thématique, une qualité catégorielle et une pertinence globale pour certains groupes de requêtes, si la source n’est pas fiable ou digne de confiance, le moteur de recherche peut filtrer le site Web.

L’autorité thématique est l’un des signaux E-A-T, mais ce n’est pas la même chose. Une source faisant autorité sur un sujet doit prouver son expertise, ses informations et son expérience unique. Ce sont des signaux E-A-T. Mais l’E-A-T est un concept plus large que l’autorité thématique. Et, pour dépasser le seuil de qualité, la source ne doit pas avoir de problème d’E-A-T, ou même si la source pouvait se classer initialement, le processus de re-classement se terminerait par une désindexation.

La recherche vectorielle est pertinente pour les seuils de qualité. Les vecteurs des requêtes et des documents peuvent être pris dans des clusters de similarité pour générer un score de pertinence.

Comment comprendre les algorithmes de classement pour les seuils de qualité ?

Pour comprendre les algorithmes de classement de Google pour les seuils de qualité, il faut comprendre le positionnement initial. Le positionnement initial d’une page Web est affecté par des algorithmes de pertinence spécifiques et des processus d’extraction d’informations. La qualité globale de la source, son autorité thématique, son PageRank, ses données historiques et son E-A-T affectent le positionnement initial.

Le score du positionnement initial affecte le processus global de reclassement et les données historiques pour les algorithmes PageRank spécifiques. Dans certains modèles et brevets de Google, le « premier temps lié » après le positionnement initial indique la proéminence et l’autorité générale de la source et la qualité de la page Web. Car le PageRank est un approbateur du « classement prédictif ».

Les seuils de qualité sont liés au positionnement initial plutôt qu’au reclassement, car les seuils de qualité servent à filtrer les sources et les pages Web les plus qualitatives pour les intégrer dans l’index principal. Le succès du positionnement initial d’une page Web d’une source affecte la possibilité pour les autres pages Web de se positionner pour les mêmes groupes de requêtes catégorielles. Le classement prédictif et la recherche d’informations visent à économiser du temps et de l’énergie lors du classement en faisant confiance à certaines sources.

Un exemple de partitionnement d’index avec un index supplémentaire et un index principal.

Pour améliorer une source pour le positionnement général, et dépasser les seuils de qualité, la source doit créer une différence par rapport à l’état précédent, que ce soit en publiant du nouveau contenu ou en mettant à jour le contenu existant.

Pour comprendre les algorithmes de classement de Google, lisez l’étude de cas sur le classement initial et le re-classement.

Comment déterminer les seuils de qualité ?

Les seuils de qualité proviennent des sources de base. En d’autres termes, la source la plus qualifiée de la SERP et la source la moins qualifiée de la SERP créent la gamme de qualité des documents. Ces sources et leurs pages Web créent les types de pages Web et de sources à classer. Un moteur de recherche peut promouvoir certains types de sources sur la SERP si les algorithmes pensent qu’ils correspondent mieux aux comportements des utilisateurs. Pour une requête d’un seul mot, il est difficile de déterminer le comportement ou l’objectif de l’utilisateur après la recherche. Par conséquent, le moteur de recherche doit utiliser la recherche d’informations pour construire une SERP multicouche et diversifiée avec différents types de sources.

Il existait même des outils permettant de vérifier le ratio de documents indexés en plus pour le SEO Google.

Pour chaque type de source, il existe un seuil de qualité différent. Un site web de la deuxième page web de la SERP ne peut pas se concentrer sur tous ses concurrents de la première page web, car les moteurs de recherche comparent les sites web entre eux en fonction de leurs types. Si le résultat d’une requête contient les types de sites Web suivants :

- sites Web e-commerce

- sites Web d’information

- blogs généraux

- site Web de vidéo

Pour déterminer les seuils de qualité d’une instance SERP, il faut déterminer le type, l’identité et le contexte du site Web. Car, sur la base du classement comparatif, la source sera comparée à différents types. Un moteur de recherche compare d’abord les types de sites Web entre eux. En d’autres termes, dans les mises à jour des algorithmes de base, un site Web n’est pas le seul à être en concurrence avec un autre site Web. Un groupe entier de sites Web est en concurrence avec d’autres groupes de sites Web. Et chaque groupe a un échantillon représentatif différent.

Dans la vidéo ci-dessous, j’explique plus en détail les concepts d’autorité thématique et de source représentative.

Pour déterminer les seuils de qualité d’un site web, le SEO doit lire l’esprit du moteur de recherche. Du qualitatif au quantitatif, il doit y avoir différentes mesures à prendre en compte et à optimiser, comme le nombre de n-grammes, les mots dominants du skip-gram, les n-grams du site, les structures de phrases, les noms et les prédicats, la stylométrie des documents, les pourcentages, les valeurs numériques, la dominance de certains types d’entités, l’exactitude des informations, le nombre d’images, les besoins et les objets d’image, les étiquettes d’image, les besoins en vidéo, l’identité du propriétaire de l’entreprise, etc. Selon les résultats et les possibilités du projet, le SEO devrait créer un équilibre différent entre la qualité et la quantité pour différentes métriques afin de dépasser rapidement les seuils de qualité pour pouvoir prendre le trafic des sites web.

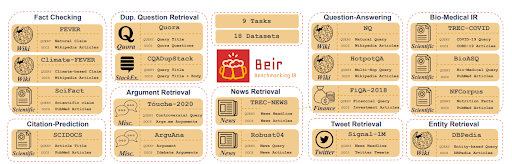

Un exemple d’évaluation comparative de modèles de recherche d’information avec différentes tâches. Tous ces modèles appartiennent à des tâches spécifiques de modèles linguistiques de moteurs de recherche sémantique.

Comment faire en sorte qu’un moteur de recherche réorganise les partitions d’index ?

Pour qu’un moteur de recherche réorganise les partitions de l’index, les concepts centraux et les requêtes d’amorçage doivent être utilisés avec des matrices d’information et de cooccurrence différentes. Un nouveau graphe d’information et un réseau de contenu sémantique peuvent obliger Google à réorganiser les domaines de contexte et les domaines de connaissance.

Google choisit une source représentative pour un sujet et classe les autres sources si elles sont similaires ou hautement qualifiées pour le même niveau de signaux que la source représentative. J’ai expliqué ces concepts avec le « Source Shadowing », ou comment un site web peut prendre le positionnement d’un autre en l’imitant, en devenant un représentant de celui-ci. Et, en ce qui concerne le « Source Shadowing », ou le fait de faire en sorte que le moteur de recherche réorganise les requêtes et les groupes de documents, la source doit dépasser le seuil de qualité pour un sujet et modifier les connexions conceptuelles et les relations entité-attribut avec un niveau de confiance élevé.

En d’autres termes, il s’agit de la « corroboration des réponses Web » et du choix d’une « réelle autorité ». Si une source crée un meilleur arbre d’information, les moteurs de recherche comprendront le même sujet plus facilement et avec plus de confiance. Et, puisque les seuils de qualité inférieurs et supérieurs sont dépassés par une nouvelle source d’information qui n’a pas de problème d’E-A-T, le site Web peut dépasser tous les sites Web d’autorité mondiale spécifiques de haute qualité. La fréquence de publication et les algorithmes convaincants liés à l’exhaustivité des différentes pages Web avec des déclarations cohérentes et des informations véridiques sont importants pour qu’un moteur de recherche évite le « facteur d’embarras ».

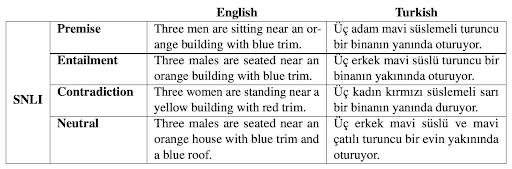

La notion de NLI (Natural Language Inference) doit être comprise pour créer des documents de qualité.

Comment dépasser les seuils de qualité ?

Pour dépasser les seuils de qualité, mettez en œuvre les méthodologies ci-dessous.

- Utilisez des structures de phrases factuelles. (X est connu pour Y → X fait Y.)

- Utilisez des recherches, et des études universitaires pour prouver votre propos. (X fournit Y → Selon les recherches de l’université X du département Z, à la date C, le P fournit Y.)

- Soyez concis, n’utilisez pas de termes inutiles dans la phrase. (X est le Y le plus courant. → X est Y avec D%)

- Incluez des images de marque avec une composition unique.

- Ayez toutes les données EXIF et les licences des images.

- Ne cassez pas le contexte à travers différents paragraphes.

- Optimisez l’intégration du discours.

- Protégez le format des questions et des réponses.

- Ne mettez pas de distance entre la question et la réponse.

- Développez les preuves avec des variations.

- Ne brisez pas le graphique d’information avec des transitions compliquées. Suivez un ordre logique dans les déclarations.

- Utilisez des phrases courtes autant que possible.

- Réduisez le nombre de mots sans contexte dans le document.

- Si un mot ne change pas le sens de la phrase, supprimez-le.

- Mettez de la distance entre les textes d’ancrage et les liens internes.

- Donnez plus d’informations par page Web, par section, par paragraphe et par phrase.

- Créez un vecteur contextuel approprié de H1 au dernier titre du document.

- Concentrez-vous sur la sémantique des requêtes avec l’inférence incertaine.

- Faites toujours des déclarations cohérentes, et ne changez pas d’opinion ou d’affirmation d’une page Web à l’autre.

- Utilisez un style cohérent dans tous les documents pour montrer l’identité de marque du document.

- Ne pas avoir de négativité E-A-T, avoir des nouvelles de la marque avec une adresse physique et des installations.

- Être revu par les concurrents ou les passionnés du secteur.

- Augmentez la « différence de qualité relative » entre l’état actuel et précédent de la source pour déclencher un reclassement.

- Inclure les documents les plus qualitatifs comme liens sur la page d’accueil pour les montrer plus tôt au robot d’exploration.

- Présentez des n-grams et des combinaisons de phrases uniques pour montrer l’originalité du document.

- Incluez plusieurs exemples, points de données, ensembles de données et pourcentages pour chaque point d’information.

- Incluez davantage d’entités et de valeurs d’attributs, pour autant qu’elles soient pertinentes pour le macro contexte.

- Incluez un seul macro contexte pour chaque page Web.

- Complétez un seul sujet avec tous les détails, même s’ils n’apparaissent pas dans les requêtes et les documents des concurrents.

- Reformatez le document sous forme d’infographie, d’audio ou de vidéo pour créer une meilleure couverture globale.

- Utilisez les liens internes pour couvrir les sous-requêtes de la même requête initiale avec des variations de la taxonomie des phrases.

- Utilisez moins de liens par document tout en ajoutant plus d’informations.

- Utilisez la FAQ et les données structurées des articles pour communiquer de manière cohérente avec le moteur de recherche à tous les niveaux et pour tous les algorithmes d’extraction de données.

- Ayez une autorité d’auteur concrète pour votre propre sujet.

- Ne faites pas la promotion des produits tout en donnant des informations sur la santé.

- Utilisez des CTA de marque en les différenciant du contexte et de la structure principale du document.

- Rafraîchissez au moins 30% de la source en augmentant la différence relative. (C’est expliqué dans la version complète de l’étude de cas SEO).

Qu’est-ce que le classement prédictif ?

Le classement prédictif s’appuie sur la recherche prédictive d’informations de manière rentable. Le classement prédictif prédit une capacité et un emplacement de positionnement optimal pour la source et les pages Web de la source avec une certaine confiance. Si les positionnements sont volatiles pour certaines requêtes, cela signifie que le moteur de recherche n’a pas confiance dans le classement et tente de prédire de nouvelles valeurs.

En ce qui concerne le classement prédictif ou les algorithmes de classement général, il n’y a aucune certitude. Ainsi, les moteurs de recherche ne devraient pas être évalués de manière déterministe. Ils doivent être évalués avec une compréhension probabiliste. Les algorithmes de classement prédictif peuvent utiliser les commentaires implicites des utilisateurs, le manque d’information et le contenu informatif des documents, ainsi que le PageRank et l’intensité de référence des sources pour certains sujets. Pour les seuils de qualité, le classement prédictif fournit un changement dynamique du seuil de score de recherche d’information tout en divisant les index en sous-parties et sections supplémentaires.

Les différentes tâches NLP et la compréhension sont importantes pour voir les priorités du moteur de recherche sémantique.

Pourquoi le classement prédictif et l’inférence incertaine occupent-ils une place prépondérante ?

L’inférence incertaine est un concept de la recherche d’information trouvée par C. J. van Rijsbergen, un leader de concept pour les moteurs de recherche de l’Université de Glasgow et le fondateur du IR Club. L’inférence incertaine ne se concentre pas sur une seule requête.

L’inférence incertaine se concentre sur toutes les requêtes connectées et les variations de phrases, ainsi que sur les synonymes des choses. Mais la principale contribution de l’inférence incertaine est la « base de connaissances ». C’est la première fois qu’un spécialiste des moteurs de recherche a mentionné qu’une base de connaissances était nécessaire pour déduire les requêtes de manière factuelle.

Le chemin de la requête ou les requêtes séquentielles sont nécessaires pour comprendre l’état de l’utilisateur et les connexions entre les concepts. Le classement prédictif est pertinent pour l’inférence incertaine car il n’est pas facile pour un moteur de recherche de voir les connexions. Si un moteur de recherche ne peut pas voir les connexions entre les choses, il y a deux possibilités.

- IR classique

- PageRank classique

Ces deux méthodes ont bien fonctionné pendant 20 ans. Mais, aujourd’hui, même une petite marque de moteur de recherche peut créer un référentiel factuel via des bases de données communes à code source ouvert et classer les documents mieux que Google. Un autre inconvénient est que les nouveaux moteurs de recherche n’ont pas de problème de crawl ou de stockage supplémentaire, et qu’ils n’ont pas besoin de tant de données pour classer les documents en fonction de la compréhension de l’information.

Cela signifie que Google doit redoubler d’efforts dans deux domaines :

- Optimisation de l’ambiance

- Précision de l’information

- Connexions de l’information

Le premier est un autre sujet, mais les deux derniers sont directement liés au SEO sémantique et à la linguistique. Si un moteur de recherche voit mieux les états des utilisateurs, le contenu est suggéré aux utilisateurs sans que ceux-ci connaissent ou recherchent le concept spécifique. Ainsi, une structure et un graphe d’information appropriés, ainsi qu’une meilleure connexion entre les éléments des documents, aident un moteur de recherche à déduire le monde physique. Comprenez que les moteurs de recherche indexent le monde physique via le monde numérique. C’est le principal résumé de la recherche orientée vers les entités.

Il existe différentes recherches pour comparer les modèles de RI entre eux. L’une d’entre elles se concentre sur le nombre de références des modèles de RI pour certains documents. Si différents modèles de RI font référence au même document, cela signifie que le document est pertinent pour toutes les possibilités.

Dernières réflexions sur l’étude de cas SEO des seuils de qualité

Des seuils de qualité existent dans chaque réseau de requêtes pour fournir un filtrage qualitatif et quantitatif du classement. Ces seuils peuvent différer d’un sujet à l’autre ou d’une source représentative à une autre source représentative. Les seuils de qualité doivent être considérés comme le principal seuil de classement des sources. Et chaque référenceur devrait calculer les seuils pour dominer sa propre niche avec un état d’esprit mieux structuré et discipliné pour le SEO.

J’ai commencé cette étude de cas SEO avec le Charles Darwin du référencement, Bill Slawski. La plupart de ces concepts et théories proviennent de sa philosophie de recherche théorique. N’oublions jamais le nom de Bill Slawski.